Шахматный подход к предсказанию исторических событий

Когда я в прошлом году (2025) писал роман "Бес парадоксов" (главу 18 "Сталкеры"), пришлось тщательно изучить события 1951-1953 годов. Конкретно: матч на первенство мира по шахматам Ботвинник - Бронштейн, и личность Лаврентия Павловича Берии.

С матчем оказалось всё более или менее понятно, хороший матч, один из интереснейших за всю историю шахмат. Но вот с Берией оказалось всё очень сложно. Чем больше я читал первоисточников и производных материалов, тем меньше понимал. Принципиальные вопросы типа "почему Хрущёв победил Берию", "почему Берия и Хрущёв не могли договориться и править вместе после смерти Сталина", "что было бы в случае победы Берии" оставались без ответа.

Вот тогда мне в голову и пришла мысль, почему бы не использовать шахматный подход к предсказанию исторических событий, которые могут состояться или которые могли бы состояться?

Если вы не увлекаетесь шахматами, самое время заняться этим. Для погружение в тему прочитайте мои произведения "Шахматы, самоучитель для новичков", "Шахматы. Эпическая битва против смартфона 20250711", "Шахматы: человек против робота". Интересно, увлекательно и полезно.

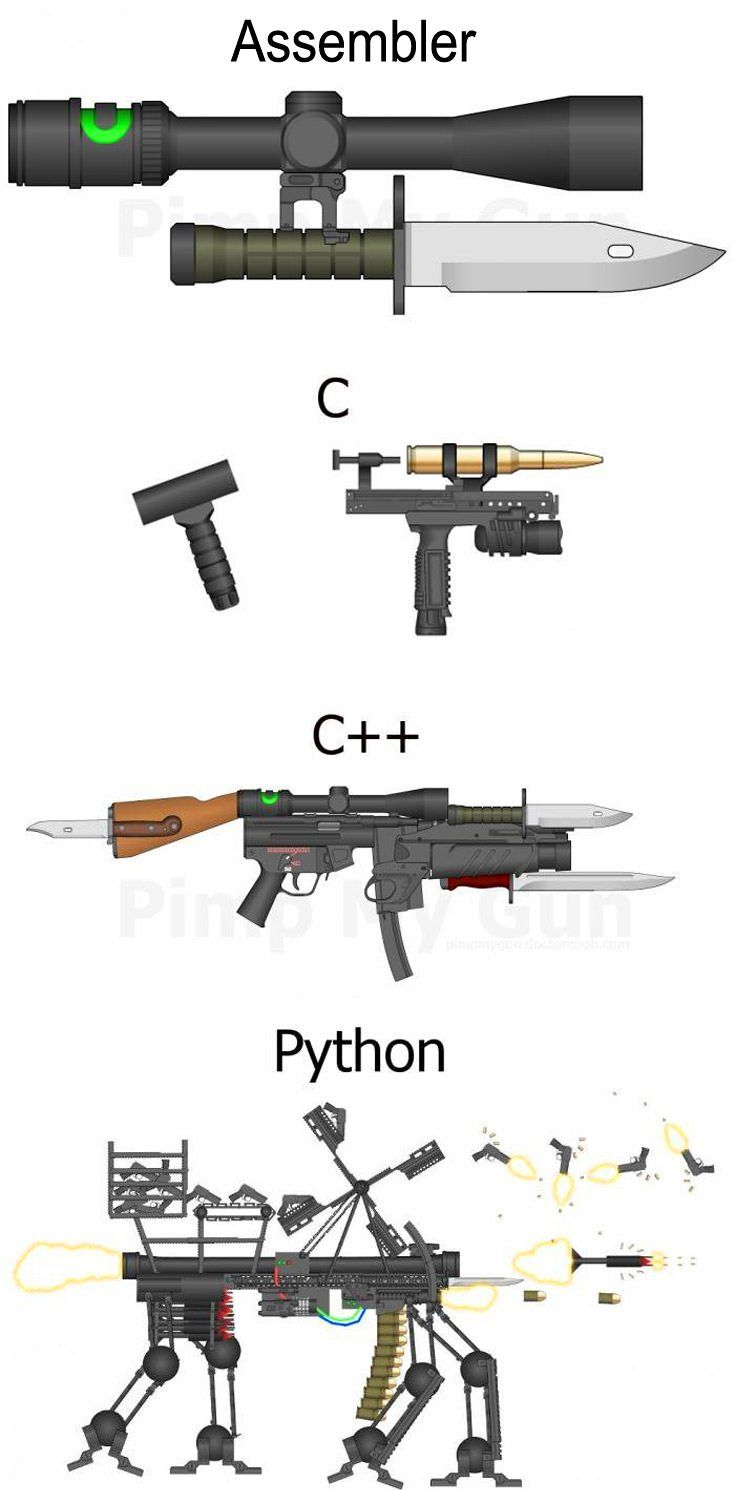

Сегодня силами энтузиастов всего мира создано несколько сотен шахматных программ (движков), которые играют лучше сильнейших гроссмейстеров. Почему бы не использовать эти наработки для чего-то полезного, например, для создания системы прогнозирования событий? Конечно, такая система будет сложнее самого мощного шахматного движка примерно в миллиард раз.

Позволяю тут процитировать себя (песня "Секретное задание"):

Эх! Чем трудней задача, тем интереснее найти для неё решение,

А сложная работа для нас, это лучшее на свете развлечение.

К тому же, с другой стороны, нейронки бурно развиваются. Если объединить идеи шахматного движка и нейросети, то вполне реально сделать что-то полезное.

Например, можно будет довольно точно предсказать, станет ли Трамп захватывать Гренландию или ограничится исключительно словесными атаками. Я пытался предсказывать что-то такое (читайте "Сделаем что-нибудь великим снова"), но намного интереснее и полезнее выслушать мнение кибернетической нейро-системы. Она ведь учтёт характеристики семи миллиардов человек, имеющих отношение к процессу, влияние солнечного ветра, пролетающих комет и ещё чёрт знает чего!

Теперь переходим к развлекательной части нашей программы.

Да, понять личность Берии у меня не получилось, всё свелось к выдаче известных фактов в таком вот стиле:

Здравствуйте, дорогой товарищ Берия,

Отношусь к вам не против, почти даже "за"...

Но зачем из народного вы вышли доверия?

И за что вам иголкой прокололи глаза?

Особенно мне понравился заключительный куплет:

Прокололись во время важной встречи вы случайно,

Вдруг чисто и не к месту сказали "данке шон"

Оправдывались ловко, логично и отчаянно,

Но стало ясно всем: английский вы шпион.

Фирменный юмор Оборотова во всей красе! Отличная свежая остроумная рифма "данке шон" и "английский вы шпион". Очень тонко!

Но где тонко, там обычно и рвётся. Нейронка сказала так. Логические неувязки: Автор путает страны. Берию обвиняли в шпионаже на английскую разведку, но фраза «данке шон» (нем. Danke schön) - немецкая.

Ладно, посмотрим, как эта песня и видео к ней понравятся людям.

Видео забавное, почти как у классика: "кричали женщины ура и в воздух Берию бросали".

Кстати, чуть не забыл. Я там указал выше некоторые свои произведения, но ссылки ставить не буду. Лучше так сделаем. Вы у себя измените поисковик по умолчанию на Яндекс и получите бонус 300 рублей на счёт телефона. Всё просто, прозрачно и понятно. Поиск работает отлично и по тексту, и голосом, и по картинкам. А с Алисой мы ранее знакомились, делали тексты и видео. Бесплатно!

Теперь вы легко сможете найти, что вам реально нужно в жизни: тексты, песни и видео Константина Оборотова. Ну и ещё, возможно, что-то.

Итак, прошу на просмотр-прослушивание клипа "Товарищ Берия".

Спасибо за внимание!

...

Первоисточники:

Песня "Товарищ Берия"

Текст, критика, версия mp4 и полная версия mp3

(бесплатно, без регистрации, без СМС)

"Яндекс Поиск" с бонусом

===