Девушка сравнила видюху с размером материнки MiniATX. Придётся не просто подставку покупать, а бетонировать.

Приветствую вас уважаемые читатели.

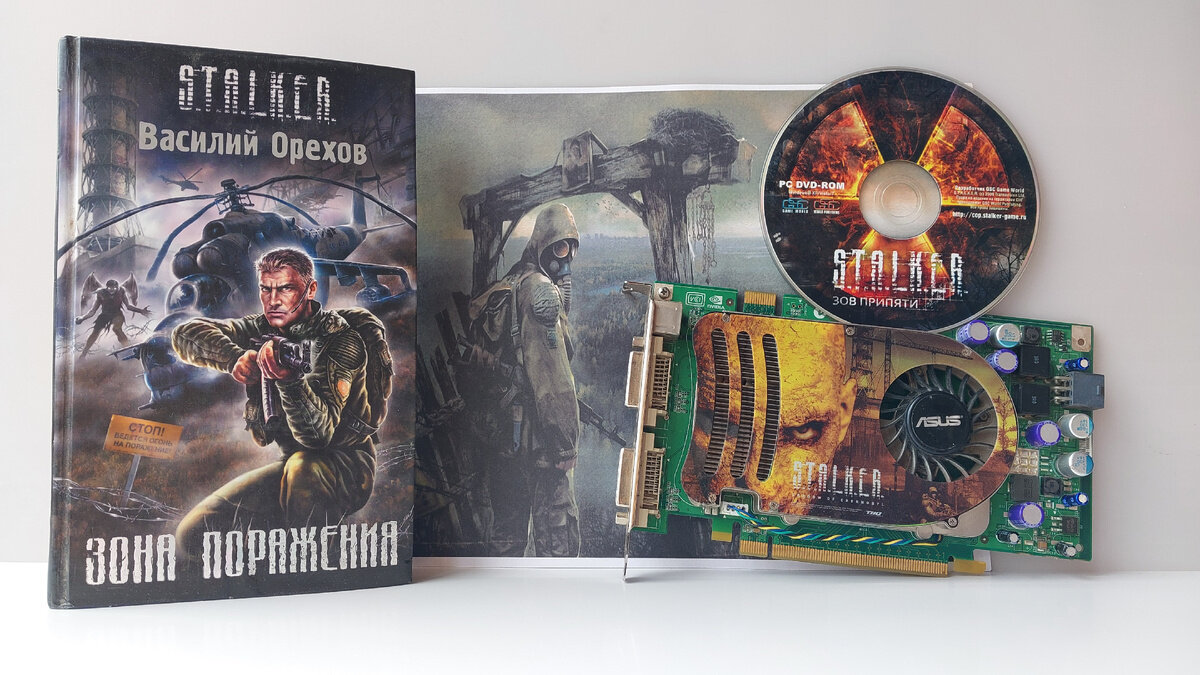

Как вы поняли по превью сегодня у нас немного тематический гость, но, к сожалению, в самой игре S.T.A.L.K.E.R мы его не протестируем.

К слову это очередная народная видеокарта только на этот раз уже 2007 года, да еще и немного тематическая.

Увы, видеокарта досталась мне только в варианте OEM, да еще и не сильно и живая, но обо всем по порядку.

На одном из сайтов посвященных игре S.T.A.L.K.E.R есть информация что вместе с видеокартой поставлялась игра S.T.A.L.K.E.R.: Shadow of Chernobyl.

К сожалению такого диска у меня не оказалось, поэтому я взял диск от Зова Припяти, не канонично, но все равно красиво

Пора отойти от картинки для превью, которую я готовил пол вечера для утренней съемки и пора перейди к нашей гостье.

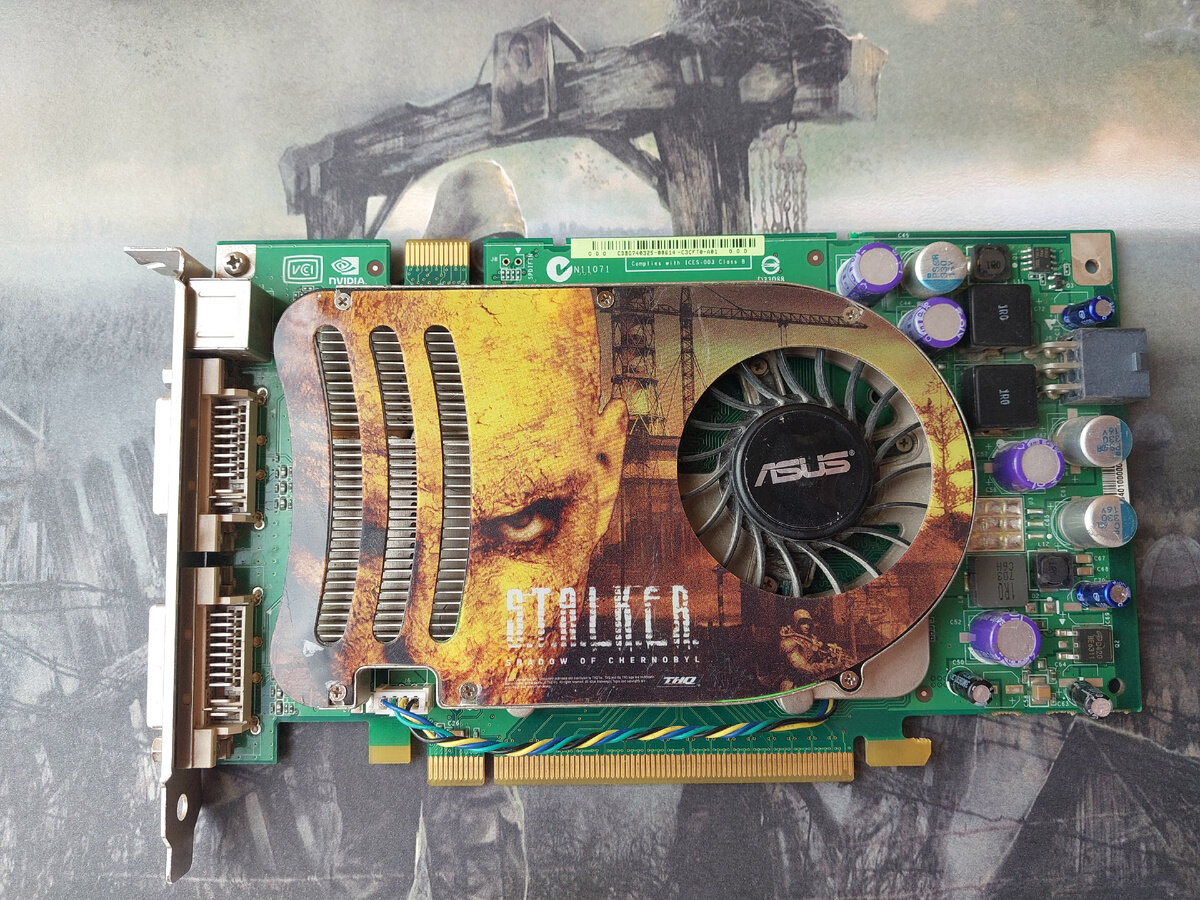

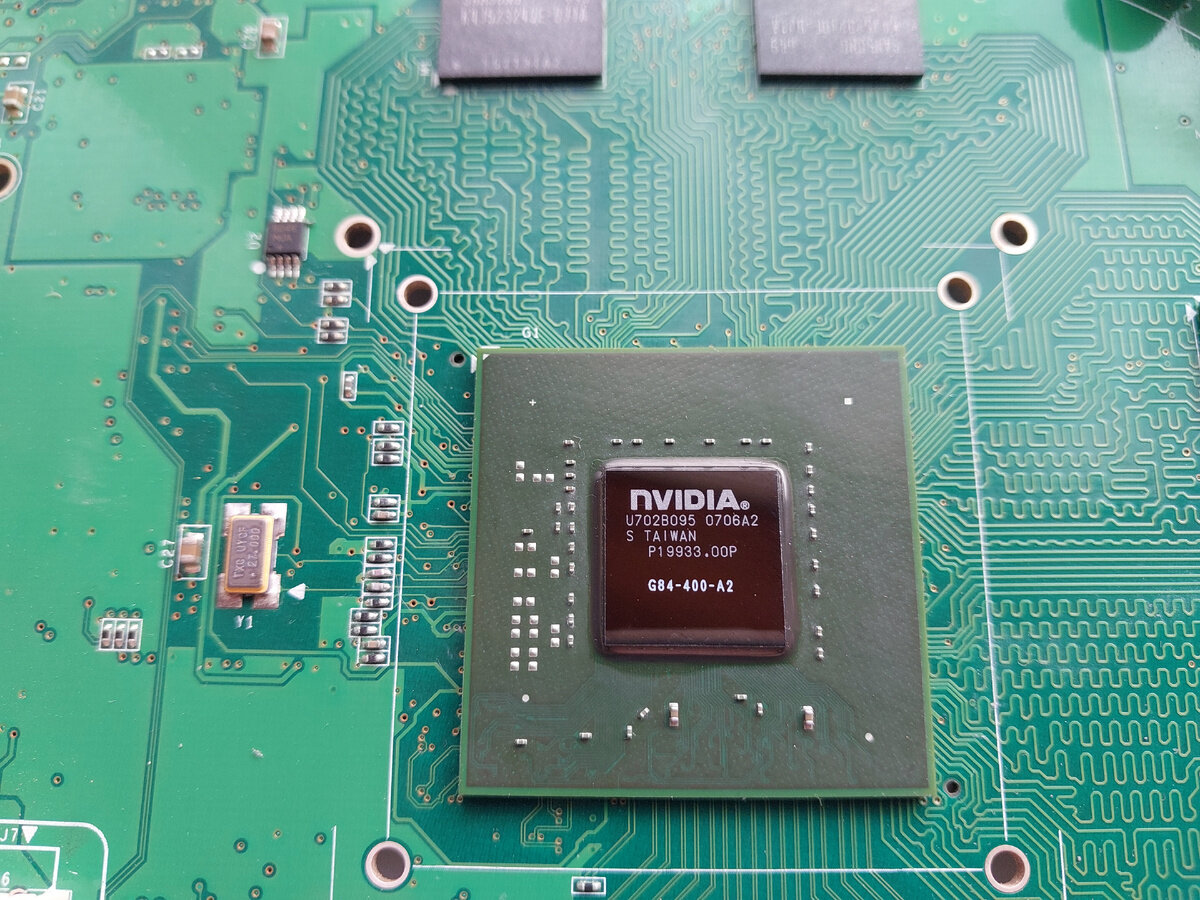

nVidia GeForce 8600 GTS на 256 Мб от вендора Asus.

Вообще 8 серия GeForce была настоящим прорывом, но и при этом массово-умирающим прорывом, но об этом немного позже.

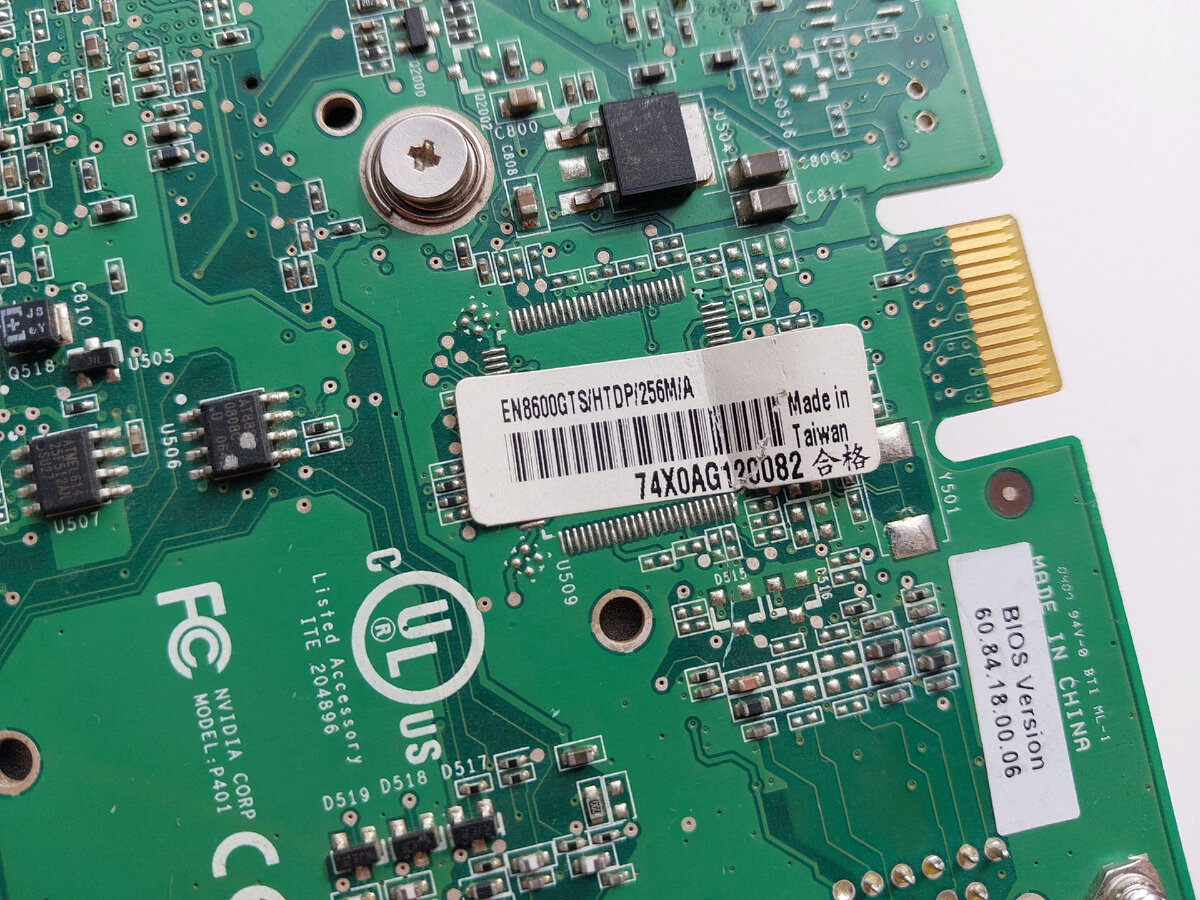

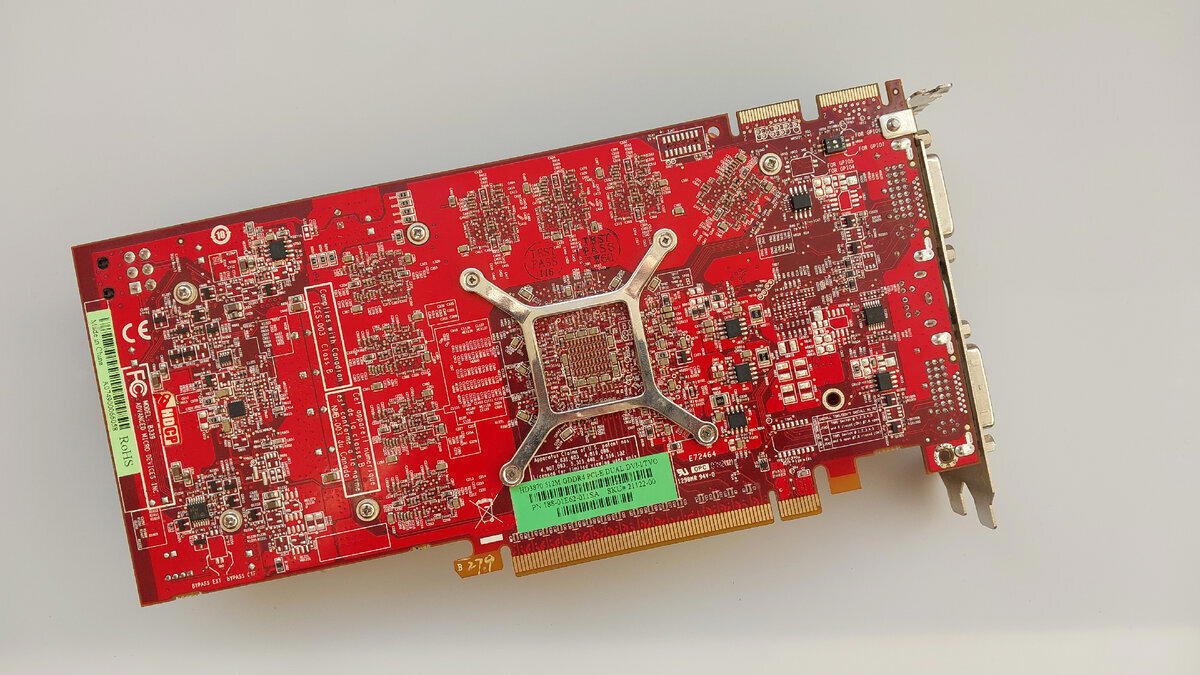

Обратная часть видеокарты не имеет ни чего особенного, даже информационная наклейка дает скудную информацию, только модель карты и объем памяти. Есть конечно еще обозначения, но их расшифровку я не нашел, подозреваю что HTDP как то связано с выводом цифровой картинки.

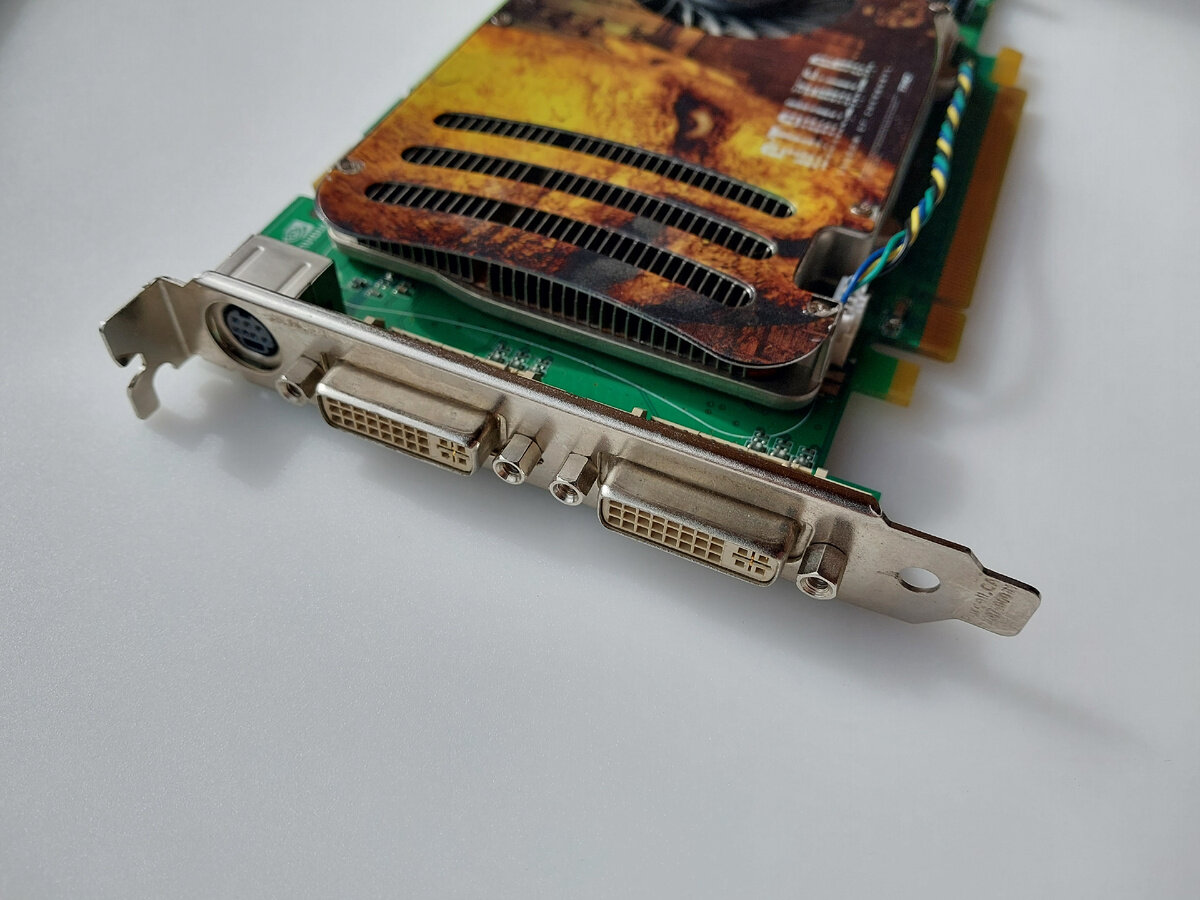

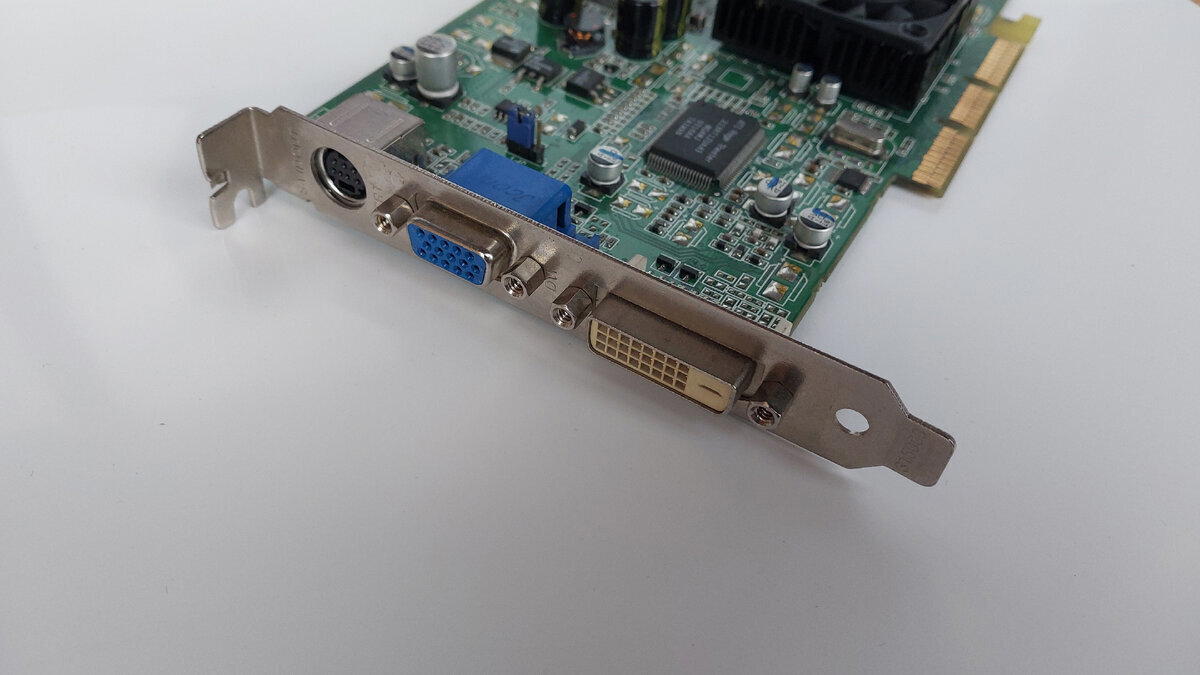

Из видеовыходов у нас тут 2 разъема DVI и S-Video способный выдавать композитный и компонентный сигнал.

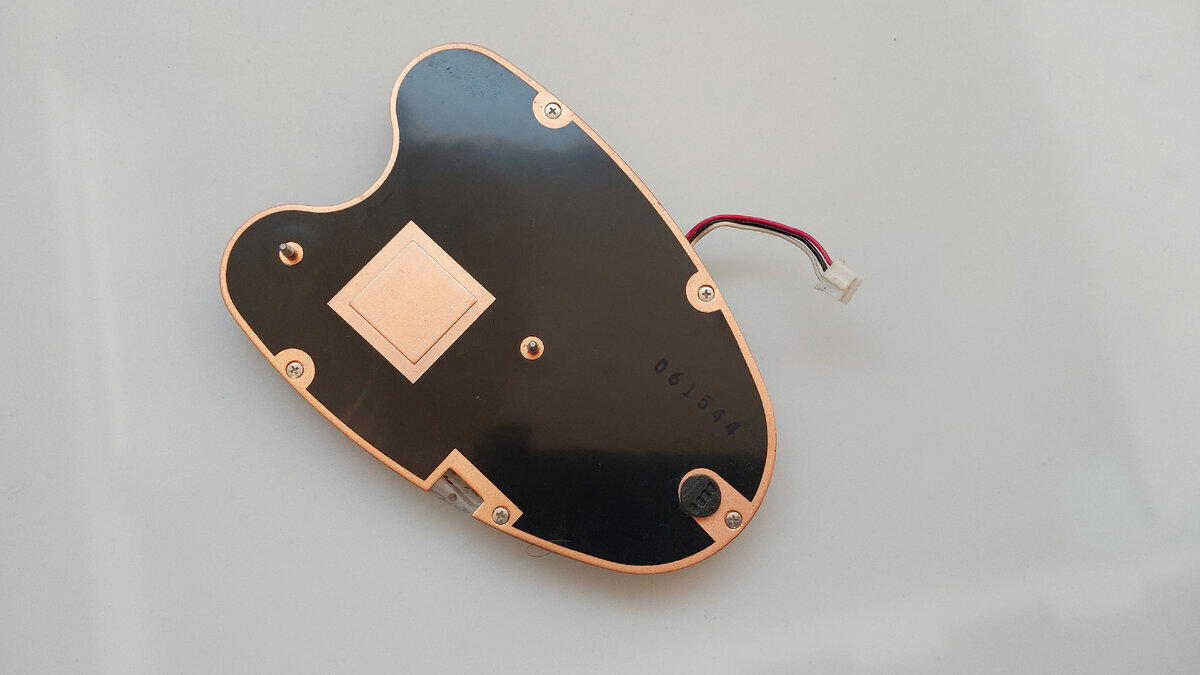

У видеокарты установлена турбинная система охлаждения (которая, как вы помните по предыдущим статьям очень, любит забиваться пылью) с медным пятачком. Видеопамять передает тепло на эту же систему охлаждения через термопрокладки.

Система охлаждения достаточно шумная, но способная умерить пыл горячего графического процессора.

Горячий воздух из системы охлаждения выбрасывается вперед к видео разъёмам и ввиду того что карта однослотовая и могла стоять заглушка в следующем слоте видеокарта могла «гонять» горячий воздух по кругу. Плюс несвоевременное обслуживание могло окончательно «добить» видеокарту.

С нашей картой это и произошло.

Пробежимся по техническим характеристикам и поговорим о причинах столь массового отказа видеокарт 8 серии GeForce.

8 серия GeForce получила поддержку DirectX 10.1, OpenGL 3.3 и Shader Model4.0.

Так же видеокарта получила поддержку CUDA и PhysH (с определенной версией драйверов).

А еще видеокарты 8 серии последние что поддерживаются официально в операционных системах Windows 10 и имеют драйвера под них.

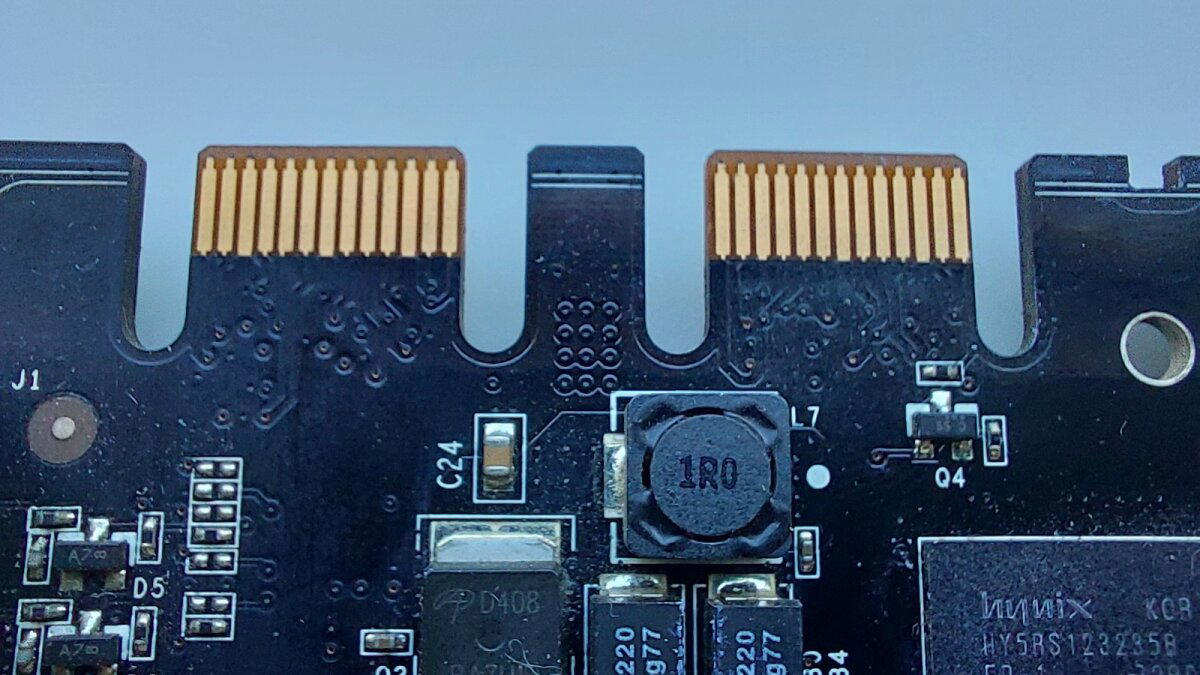

Видеокарта требует подключение дополнительного питания 6Pin.

Можно конечно установить драйвера на 6 и на 7 серию GeForce от более ранних систем, и обычно это работает.

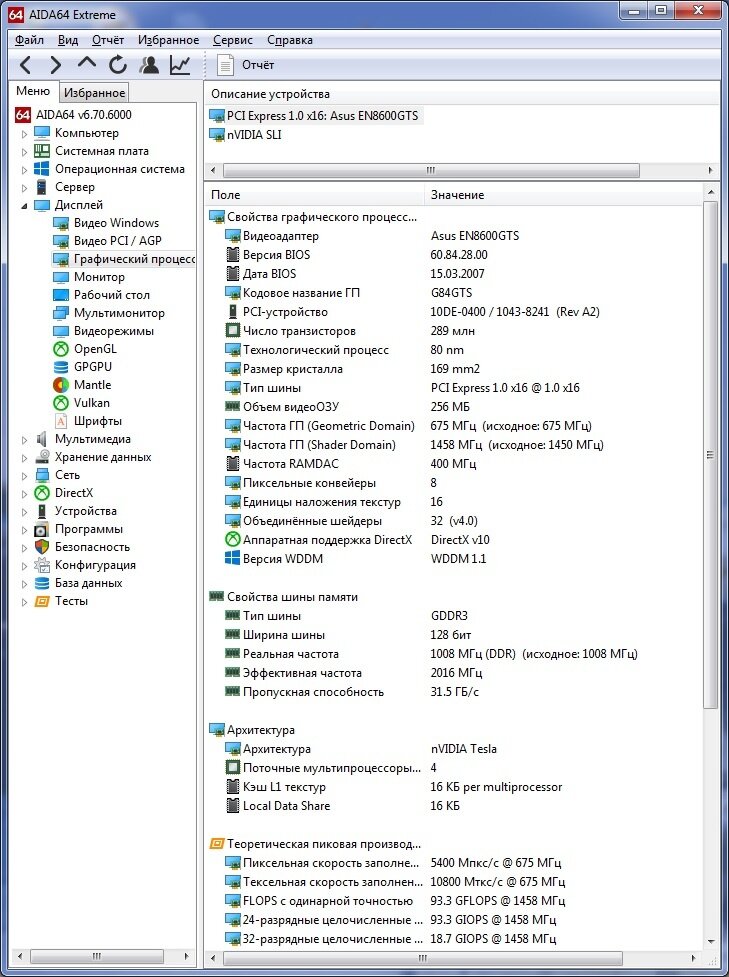

В нашей версии частота графического процессора составляет 675 МГц, а частота шейдерного блока 1458 МГц.

Видеокарта работает на шине PCI-E x16 и официально под AGP шину не выпускались.

Оперативная память установлена Samsung, 4 чипа по 64 мегабайта что в сумме составляет 256 мегабайт. Тип памяти GDDR3 и работает на частоте 1008 МГц. Ширина шины памяти 128 бит.

Теперь поговорим о смертности видеокарт данной серии.

Многие из вас узнали, что такое отвал благодаря этой серии. Отвал был, как и видеокарт для настольного компьютера, так и видеокарт установленных в ноутбуках.

По каким же причинам происходил отвал?

Первое и основное это деградация чипа из-за нагрева. 8 серия получилась очень горячей, за исключением младших видеокарт из серии по типу 8400(которые, кстати, тоже отваливались, но спустя более долгий срок).

Так называемый “отвал“ это не просто слово, это реальный процесс, происходящий в основном между кристаллом чипа и его подложкой. Во время прогрева видеочипа шарики на подложке не успевают расплавиться, чтобы восстановить контакт, но успевают расплавиться под самим кристаллом и вновь соединиться с подложкой.

В истории техники это произошло одновременно с переходом на безсвинцовый припой.

Так как полностью перекатать шары под кристаллом задача из невозможных, плюс кристаллы очень качественно залиты компаундом через время после прогрева контакт все равно пропадет.

Наверное вы скажете указывая на мою статью про 8800GTX что там кристалла нет, вы ошибаетесь. Так как видеокарта и система очень массивная графический процессор там сделан наподобие обычного компьютерного процессора (если очень грубо) и кристалл закрыт теплораспределительной крышкой. Кстати, если сделать скальпирование на еще живой 8800GTX (Или GTX280, GTX560, к примеру) то можно серьезно продлить ей жизнь в коллекционных интересах.

С приходом GTX10xx линейки и выше отвал ушел в прошлое, теперь чипы просто получают термический пробой.

С 8600 у меня связана часть молодости. В одно время я был владельцем 8600GT от вендора Palit на целый 1 Гб памяти, но DDR2. Покупал я ее в 2011 году, когда у меня случился небольшой финансовый провал, и чтобы как то удержаться я продал свою видеокарту и купил недорого данный экземпляр. Не лишним будет сказать, что до сих пор трудится в одном из моих старых компьютеров адаптированных для программного ремонта старых кнопочных телефонов и ранних андроидов.

Те задачи, которые мне были нужны (а точнее в игры которые я играл) Мне ее хватало за глаза, поменял я ее только в 2016 году.

Я думаю к этому моменту у читателя статьи (и не только этой) возникнет вопрос, что же значат эти буквы: GT, GS, GTS, GTX.

Действительно, я ни в одной статье не разбирал это. Данные обозначения действительны только для видеокарт от GeForce.

Возьмем в пример видеокарту GeForce 6600.

Пока в модели не указано ни каких букв, это базовая модель на частотах рекомендуемых производителем и с установленной памятью, работающей на тех же рекомендованных частотах. Грубо говоря «ванильная» версия

Если же у нас GeForce 6600GS, то эта карточка будет уже чуть мощнее обычной, более высокие частоты графического процессора, может стоять чуть мощнее память или более будет использована более широкая шина.

GeForce 6600GT будет еще мощнее GS, будет установлена другая система охлаждения, частоты будут на порядок выше, да и память будет стоять намного быстрее.

А вот GeForce 6600LE это никчемный обрезок, с самой минимальной шириной шины, медленной памятью и низкой частотой графического процессора. Именно поэтому они чаще всего идут с пассивным охлаждением.

GTS версия находится ровно между GS и GT, а GTX соответственно выше.

Еще существовали GTX+ и Ultra обозначения, но дальше 8 и 9 серии я их не видел

В дальнейшем большинство обозначений просто убрали, оставили GTS, GT и GTX, среди которых GT считается базовой версией.

Расшифровки этих аббревиатур нет, в интернете существует только шуточная таблица.

Вроде рассказал обо всем и надо бы переходить к графическим бенчмаркам и посмотреть столько набирает наша гостья баллов.

Но так как у нас тематическая видеокарта хоть и уже вышедшая из строя после прогона тестов (честно не было времени прогревать) я решил найти в открытых источниках ее показания FPS в разных версиях S.T.A.L.K.E.R

И я нашел три ролика от одного автора именно с этой видеокартой.

Платформа: Core i7-4790k, 16Гб Оперативной памяти типа DDRIII и установленная Windows 7.

Сталкер Тень Чернобыля

1280х720, полное динамическое освещение, высокие настройки.

В обычном пробеге по локации средний FPS имеет значение 75-90, при каких либо перестрелках или местах с большим количеством эффектов (взрывы, аномалии) FPS может провалиться в 55-65 кадров.

Сталкер Чистое небо

1280х720, полное динамическое освещение, высокие настройки.

В обычном пробеге по локации средний FPS имеет значение 30-45, при каких либо перестрелках или местах с большим количеством эффектов (взрывы, аномалии) FPS может провалиться в 20-25 кадров.

Но мы с вами знаем, какая там оптимизация.

Сталкер Зов Припяти

1280х720, полное динамическое освещение, высокие настройки.

В обычном пробеге по локации средний FPS имеет значение 35-40, при каких либо перестрелках или местах с большим количеством эффектов (взрывы, аномалии) FPS может провалиться в 25-30 кадров.

Пора к тестам.

Наша тестовая платформа от видеокарты к видеокарте не меняется (разве что у AGP другая) Intel Core 2 Quad Q9550, DDRII – 8Gb, Windows 7 x64. Пресеты настроек бенчмарков: по умолчанию, разрешение 1024х768х32 кроме 3DMark 2006.

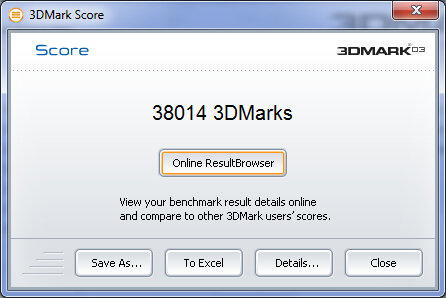

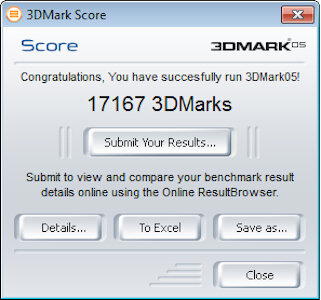

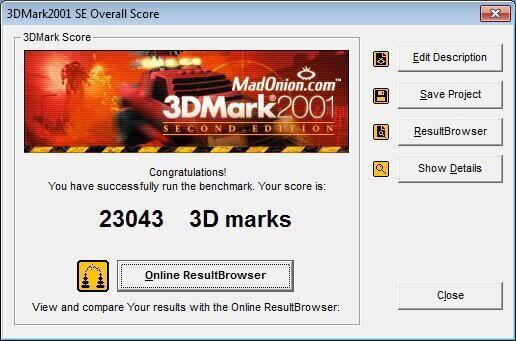

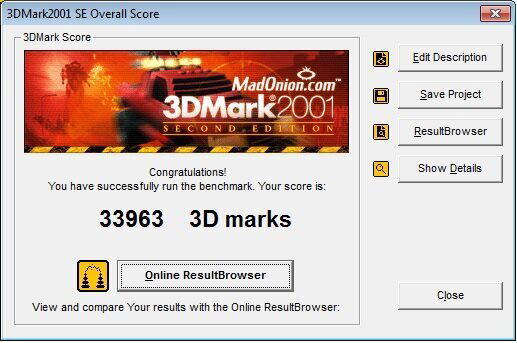

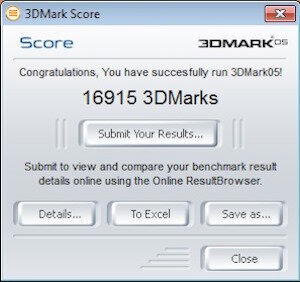

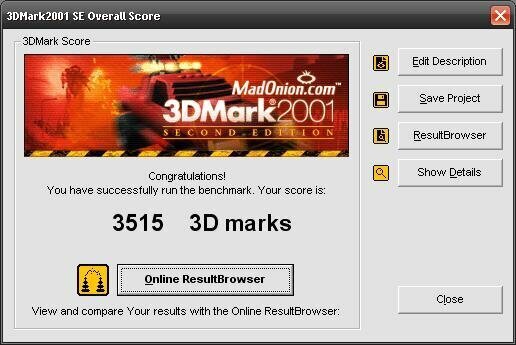

3DMark 2001. Выбиваем 32224 очков. Чуть медленнее, чем 8800 GTX, но почти вровень с HD3870.

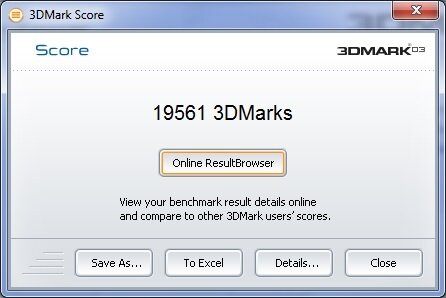

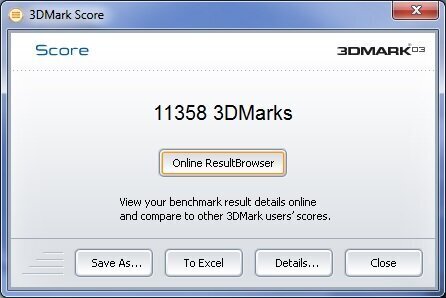

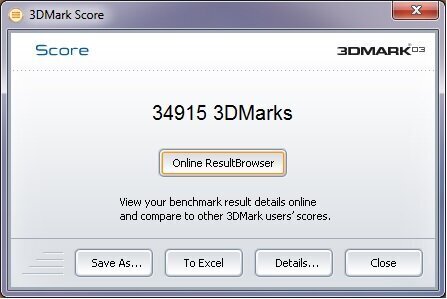

3DMark2003. Выбиваем 19561. Далеко отстаем от 8800GTX и HD3870. Подозреваю дело в ширине шины, либо странной оптимизации бенчмарка.

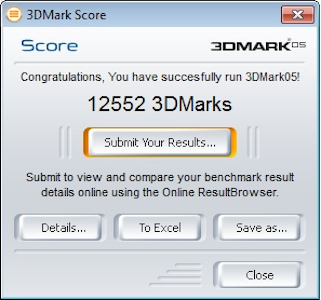

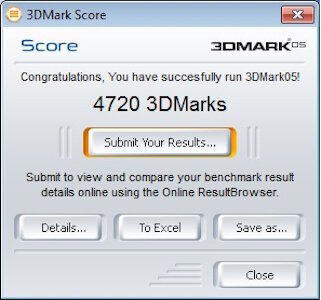

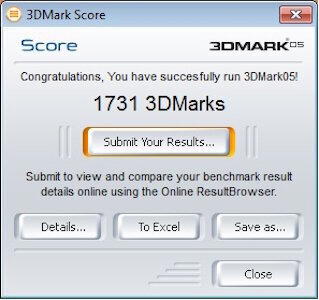

3DMark 2005. 12552 очков. И это вполне достойный результат. Мы снова сблизились к HD3870.

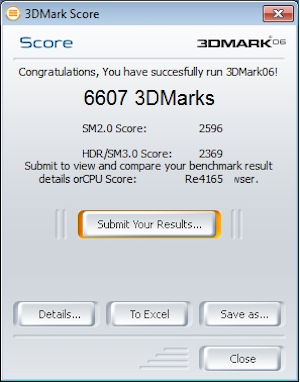

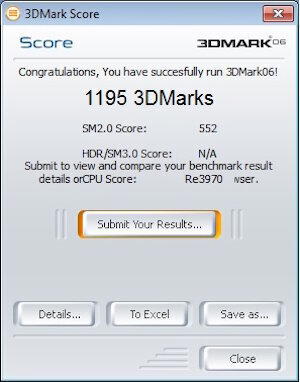

Ну и последний 3DMark2006 с пресетом настроек 1280х1024.

Набираем 6607 очков. Видеокарта крепкий среднячок, даже не смотря на мое сравнение с более мощным собратом она полностью себя оправдывает.

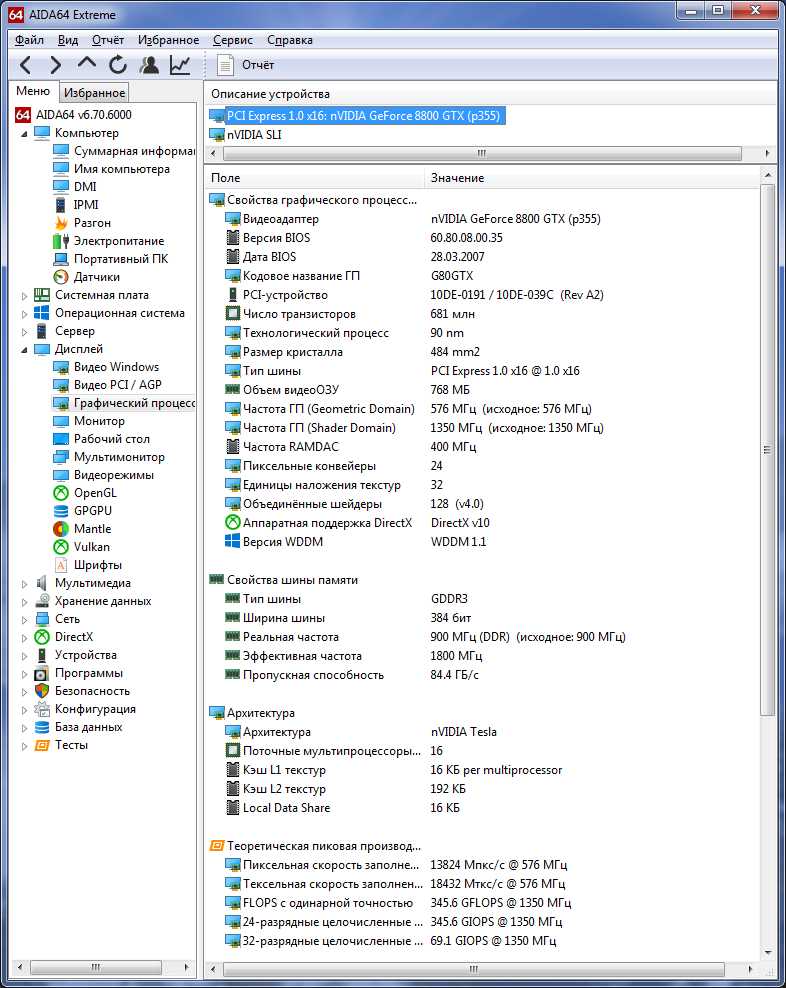

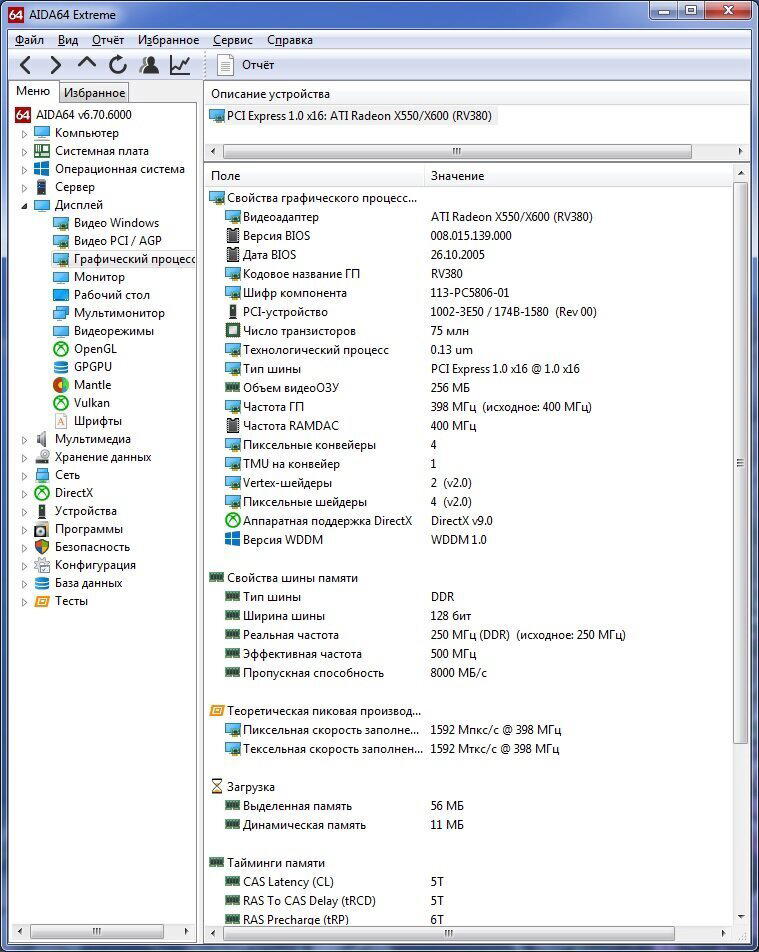

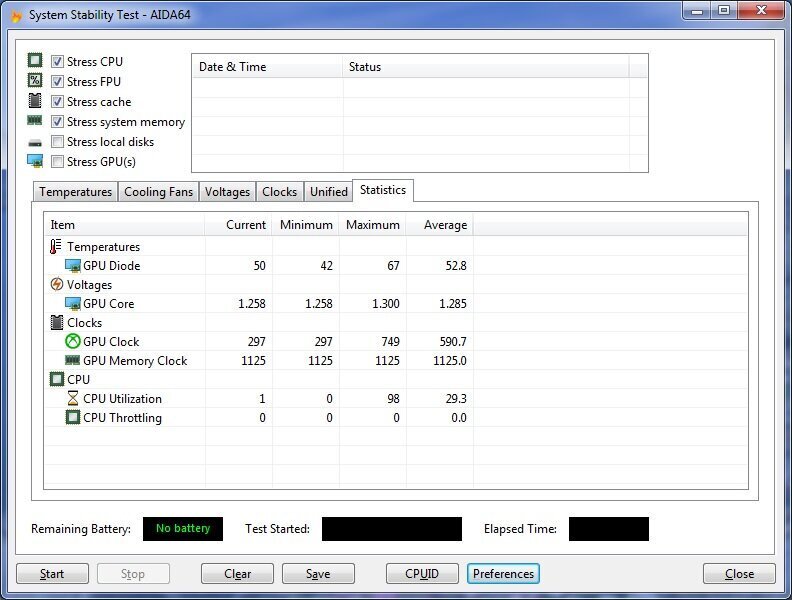

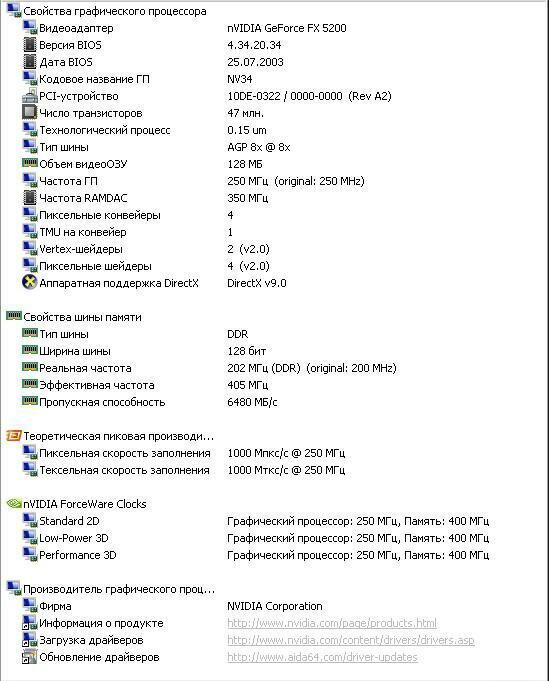

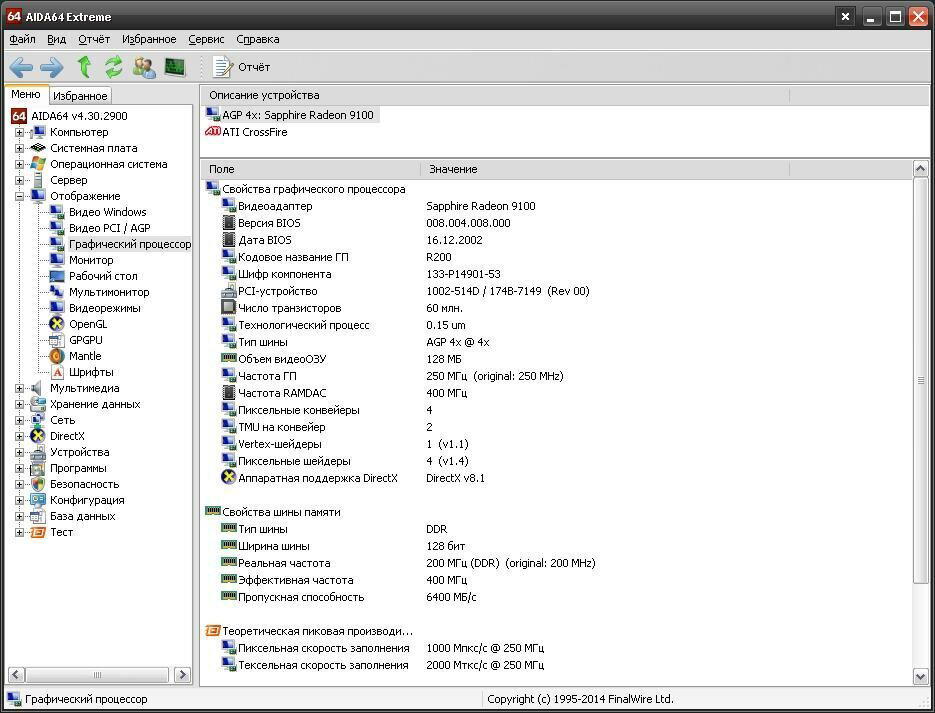

Ну и по традиции скриншот из программы AIDA64.

На этом я завершаю данную статью. Надеюсь, вам было интересно.

Всем спасибо и до новых встреч.

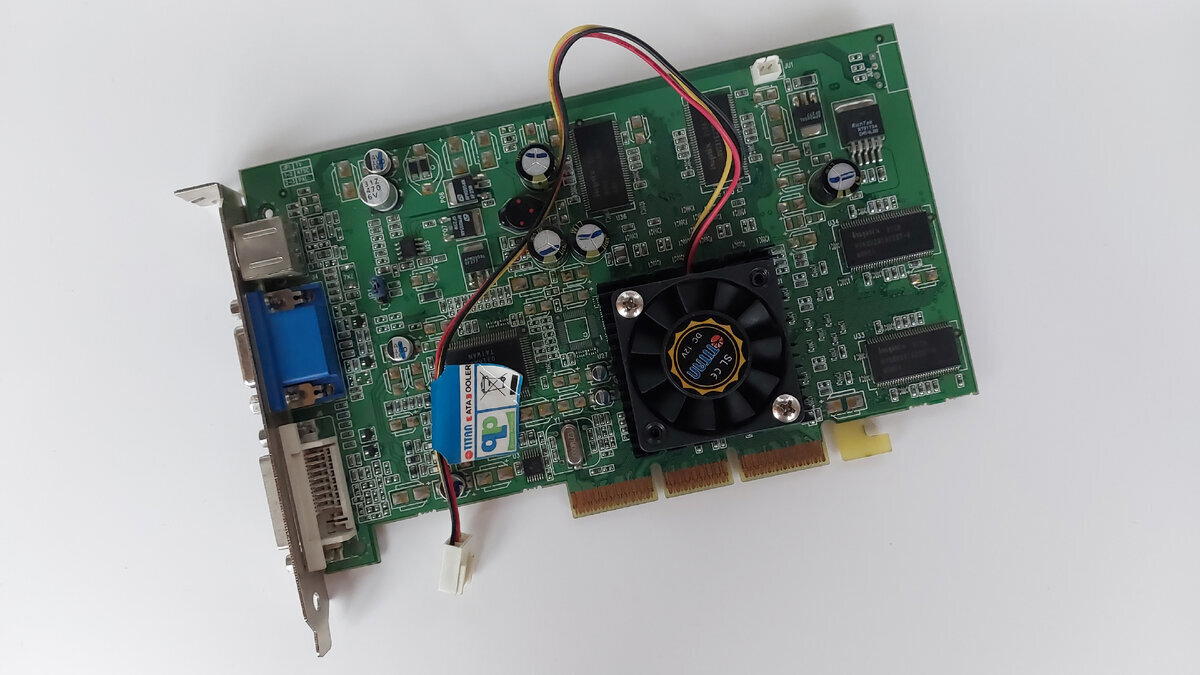

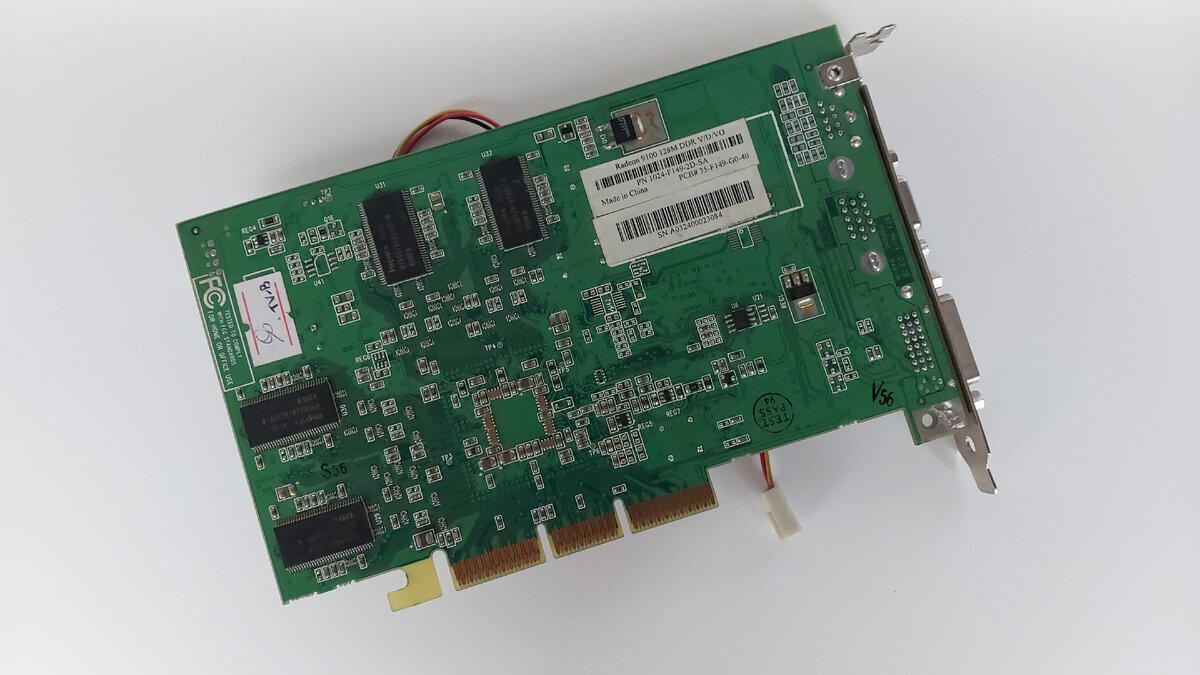

Рад приветствовать вас дорогие друзья.

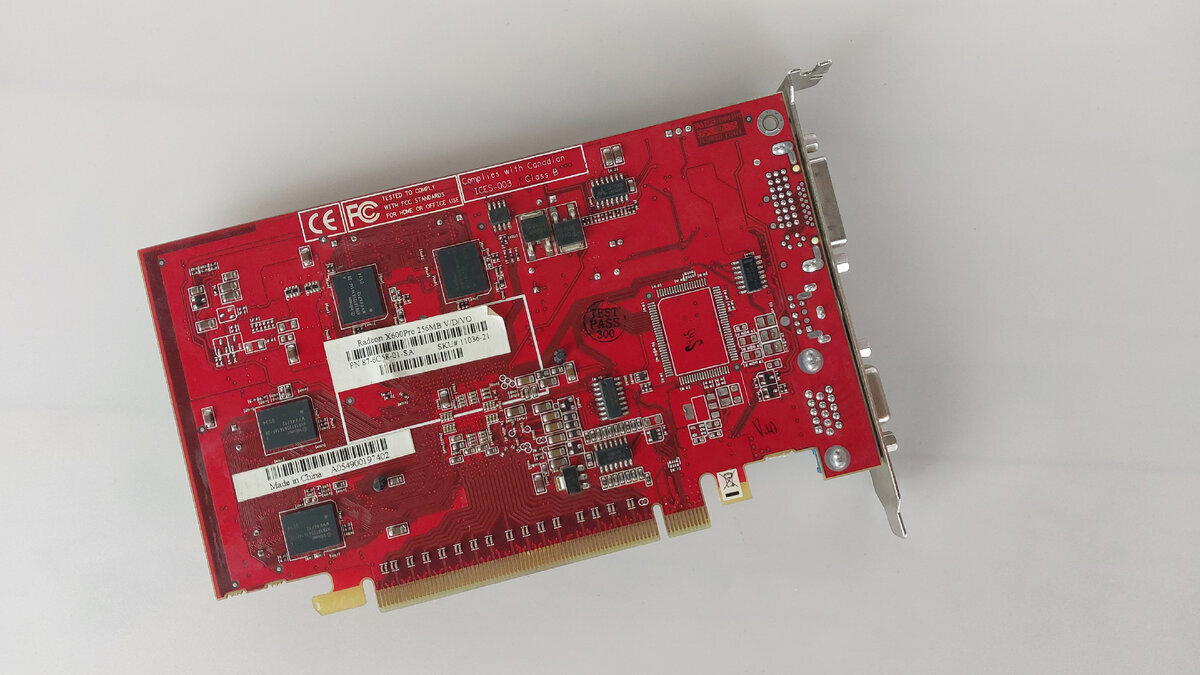

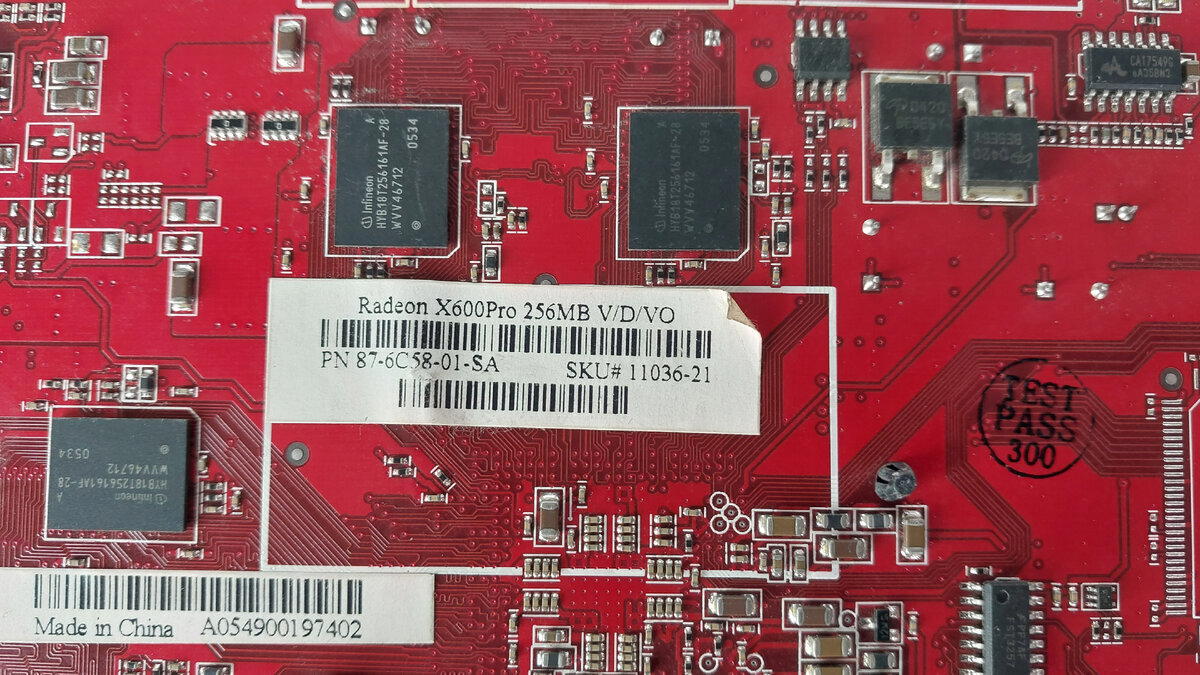

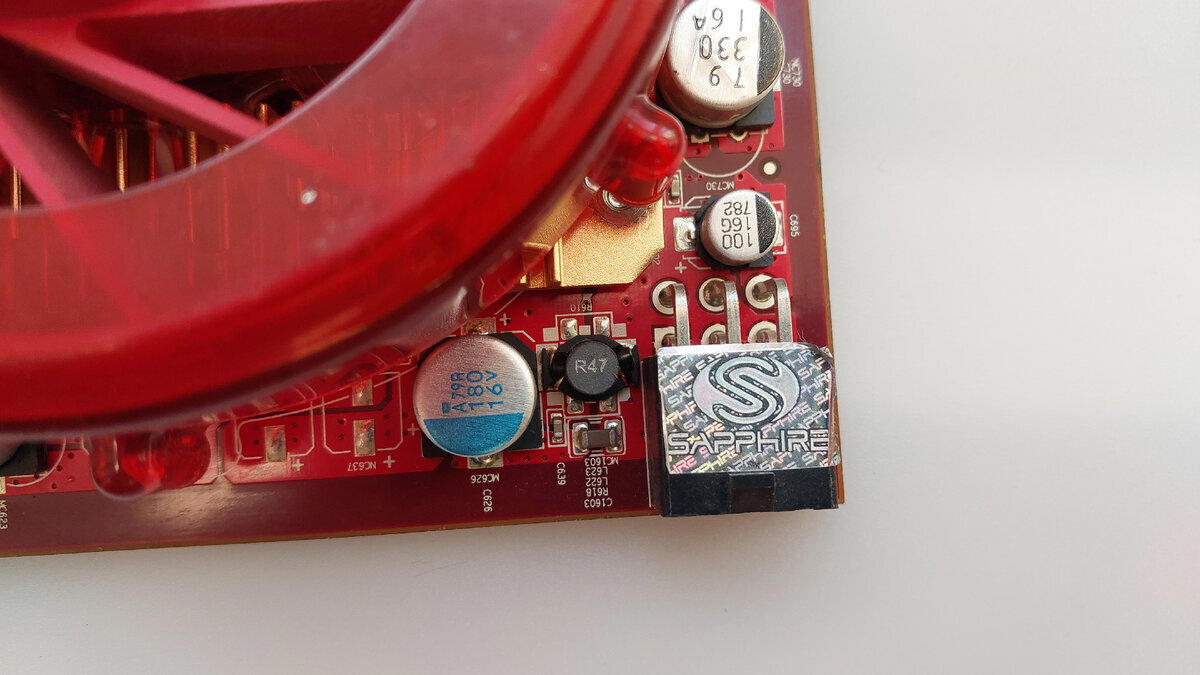

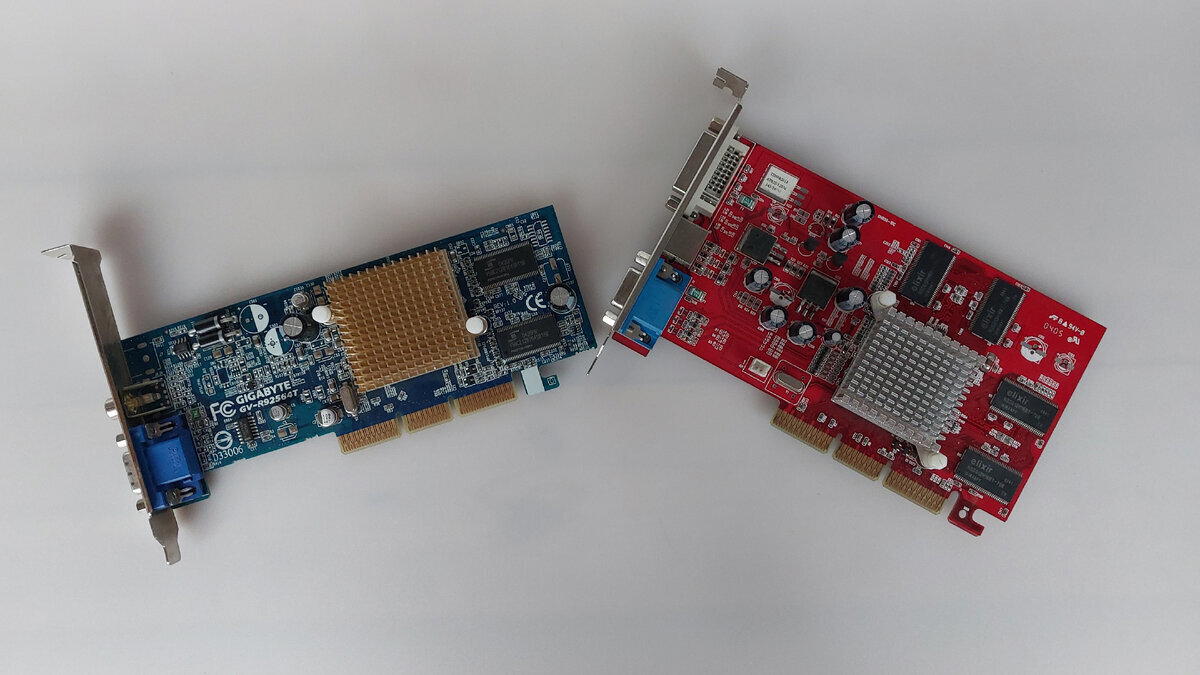

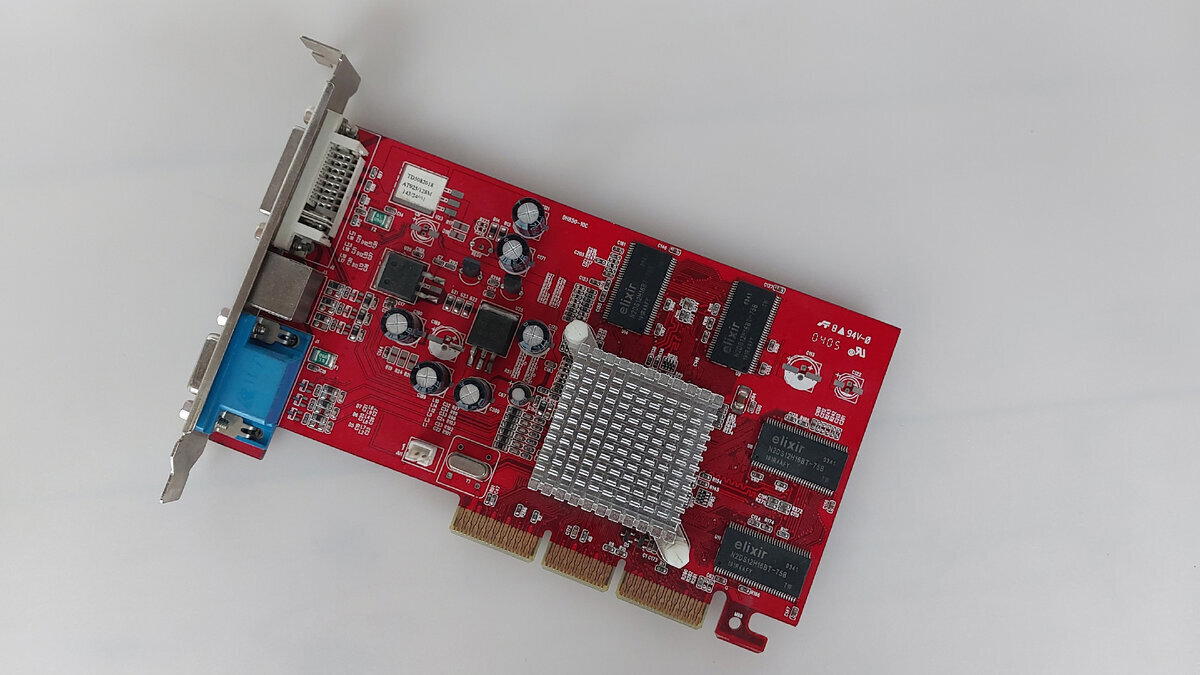

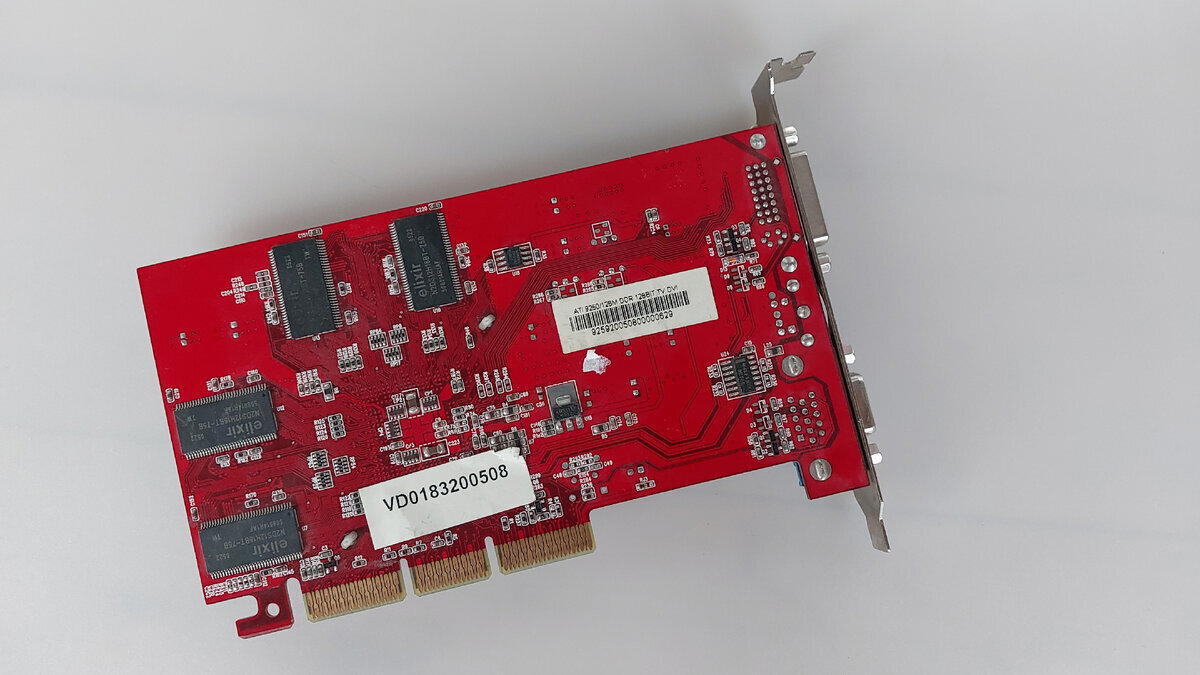

Сегодня мы поговорим о народных видеокартах своего времени, а именно о ATI Radeon 9600 от вендора Sapphire, а так же поймем, что разница в количестве памяти не прибавляло особой производительности видеокарте.

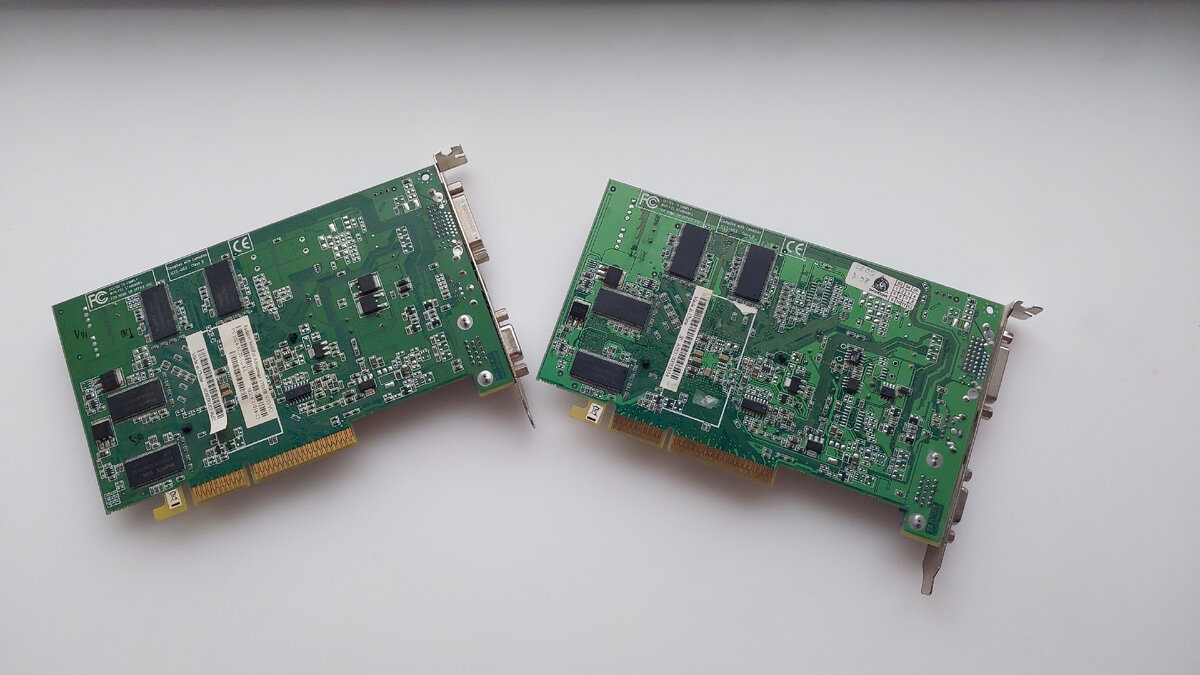

Хочу заметить, что у нас визуально две одинаковые видеокарты, так же их производительность друг от друга тоже не сильно отличается (в пределах 1-3% погрешности), но по факту видеокарты друг от друга отличаются.

Итак. ATI Radeon 9600PRO на 128 мегабайт и ATI Radeon 9600PRO на 256 мегабайт. Обе от вендора Sapphire.

Как должны были сойтись звезды, чтобы я с двух разных компьютеров привезенных с разных организации извлек видеокарты от одного вендора да еще и на одинаковом PCB.

Так же было большим удивлением, что родная система охлаждения, а именно вентиляторы находятся в исправном состоянии, нужно было только почистить.

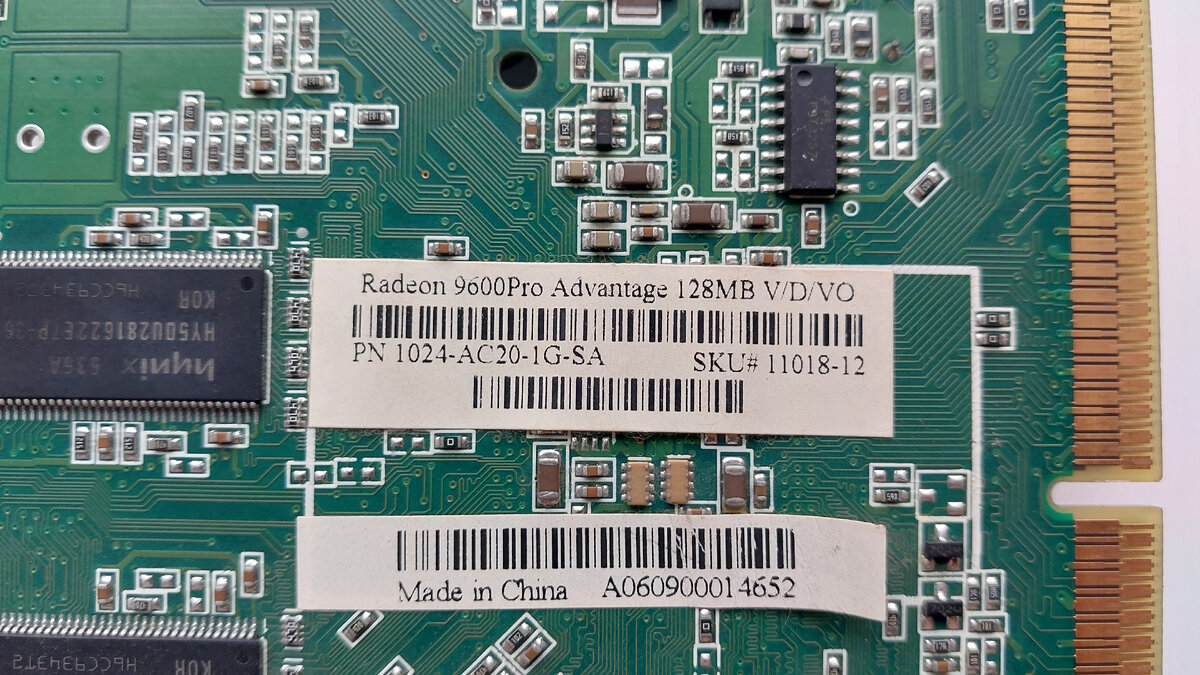

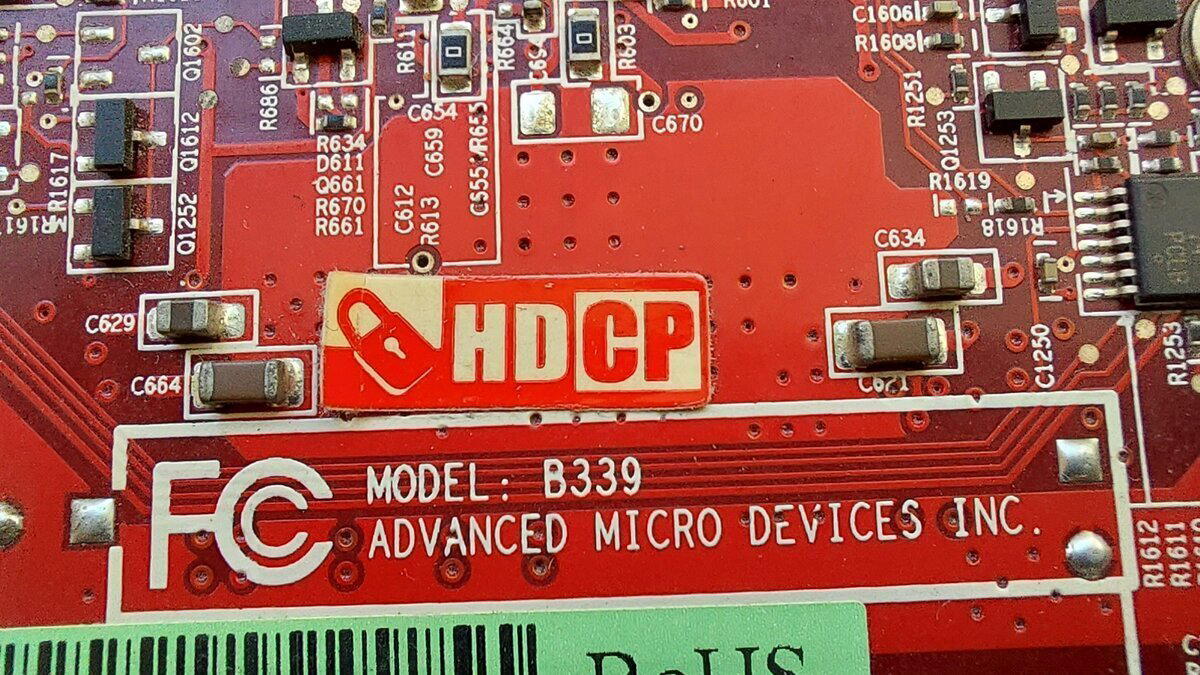

Неизвестно по каким причинам, но на видеокарте с объемом на 256 мегабайт нет информационной наклейке, об объеме я узнал уже во время ее проверки.

На первой видеокарте с объемом 128 мегабайт наклейка на месте. По ней мы можем узнать модель карты, объем памяти и сокращенно перечисленные видеовыходы.

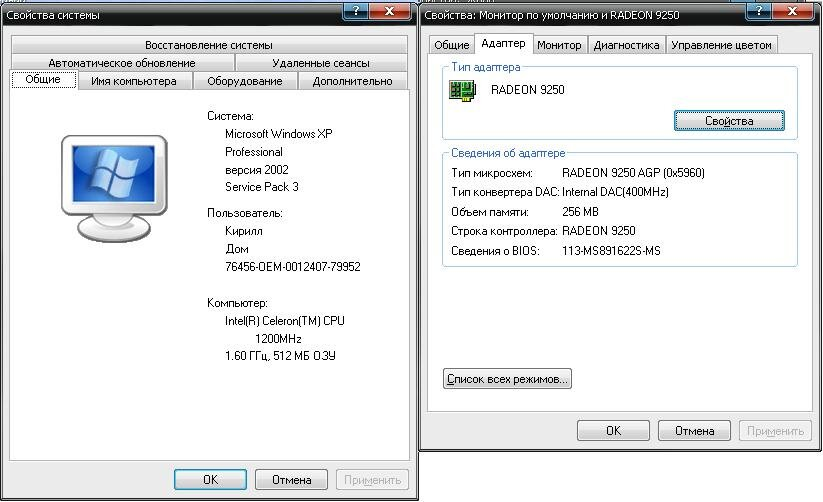

На моей памяти знакомство с Radeon под шину AGP началось в то время, когда о AGP уже мало кто вспоминал и на арену заходил AMD с серией процессоров FX. Я был, конечно, ранее знаком с Radeon 9250, но не более. В один момент я стал обладателем видеокарт ATI Radeon 9500 64 Мб, ATI Radeon 9550 128 Мб, ATI Radeon 9600 256 Мб, ATI Radeon 9700 128 Мб и ATI Radeon 9800PRO на 256 Мб.

До сих помню то удивление, как ATI Radeon 9500 без проблем запустила Сталкер Тень Чернобыля с неплохой частотой кадров в секунду. Тестирование старших моделей поражало воображение мощности и скорости работы DirectX 9. Особенно в сравнений видеокарт GeForce FX.

Обе наши видеокарты имеют активную систему охлаждения с фирменной наклейкой Sapphire и тиснением на рамке.

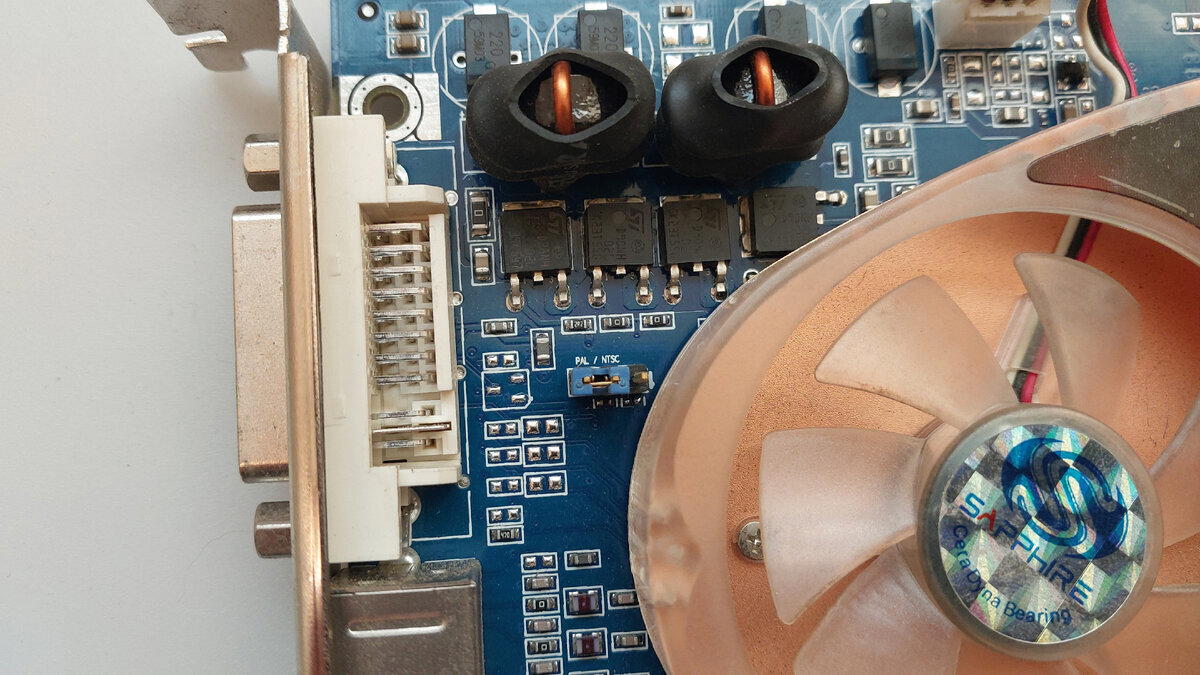

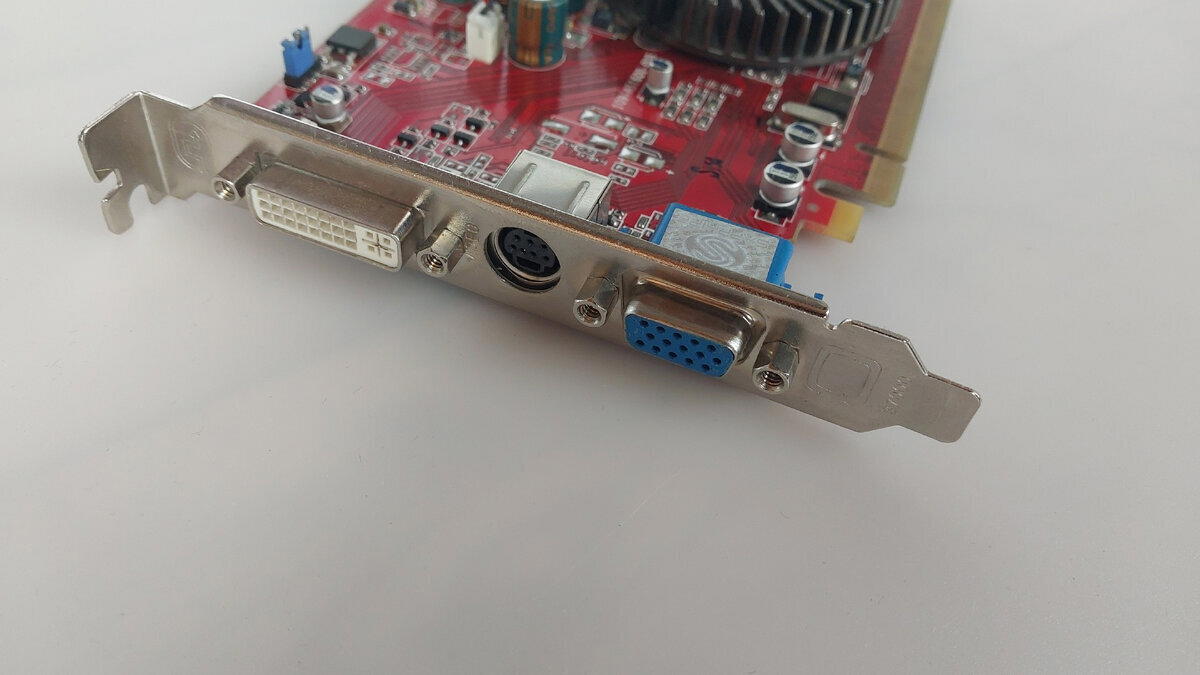

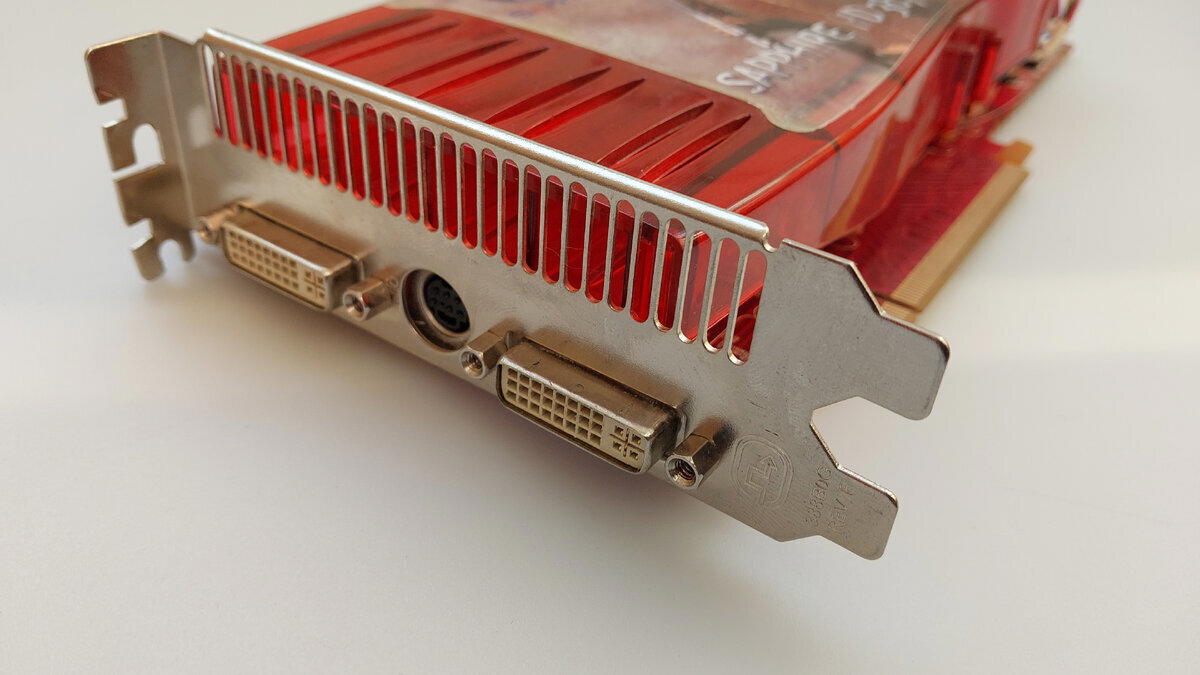

По видеовыходам у нас тут все стандартно для тех лет D-Sub(VGA), DVI, S-Video (Кстати, есть поддержка композитного выхода и компонентного, так же на плате есть джампер для переключения PAL или NTSC).

Не помню, говорил я или нет, но видеокарты ATI Radeon умеют выводить картинку на все видеовыходы, GeForce же это научилась делать только к 6хх серии видеокарт.

То есть технически к видеокарте ATI Radeon 9600 (да и почти к любой другой, где есть 3 видеовыхода) вы могли подключить два монитора и телевизор через тюльпан.

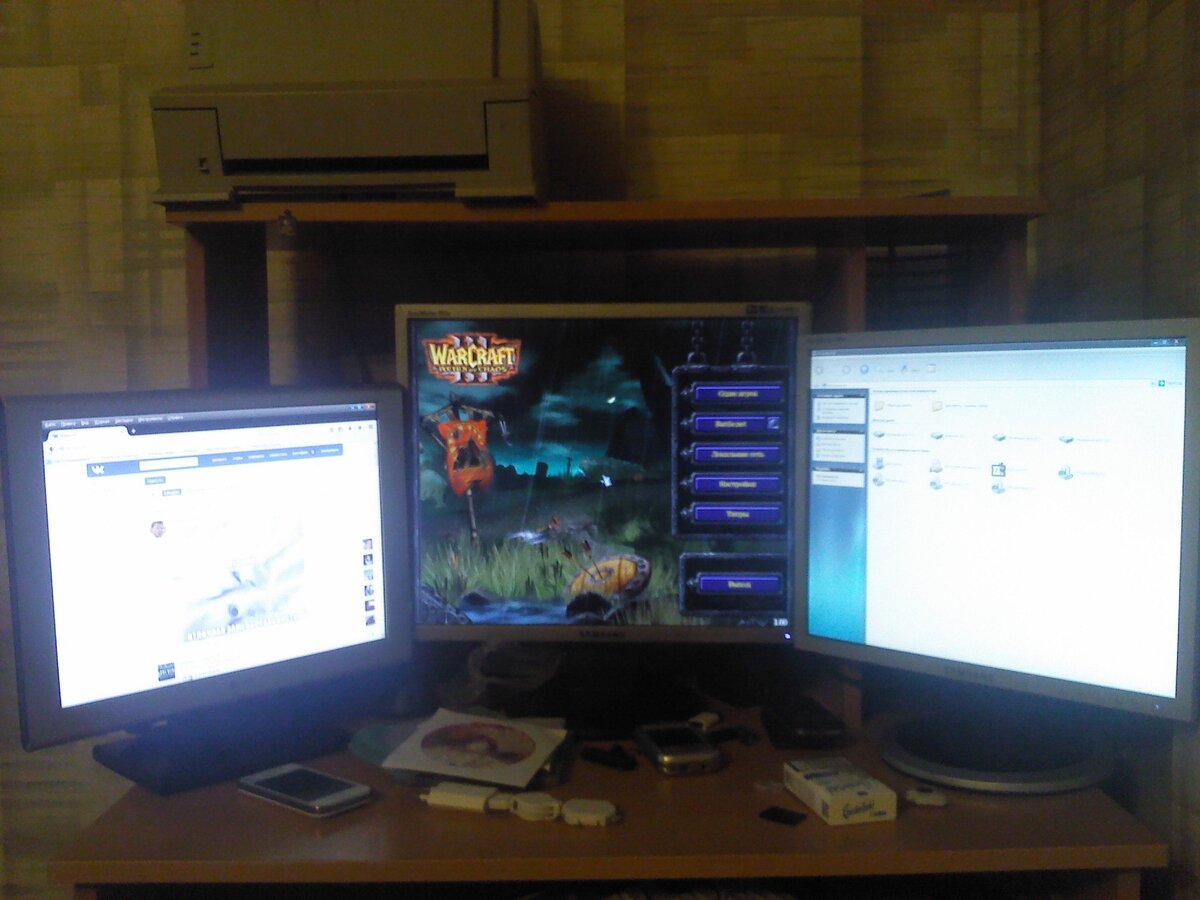

У меня даже сохранилась старая фотография где я к Radeon 9250 подключил 3 монитора (Один из мониторов был подключен через переходник BNC>VGA)

В целом этот трюк я могу провернуть и сегодня, но увы бардак в мастерской из за некоторых технических моментов не позволят сделать нормальное фото. (Нахожусь в стадии переезда). Но как будет возможность я дополню статью свежими кадрами.

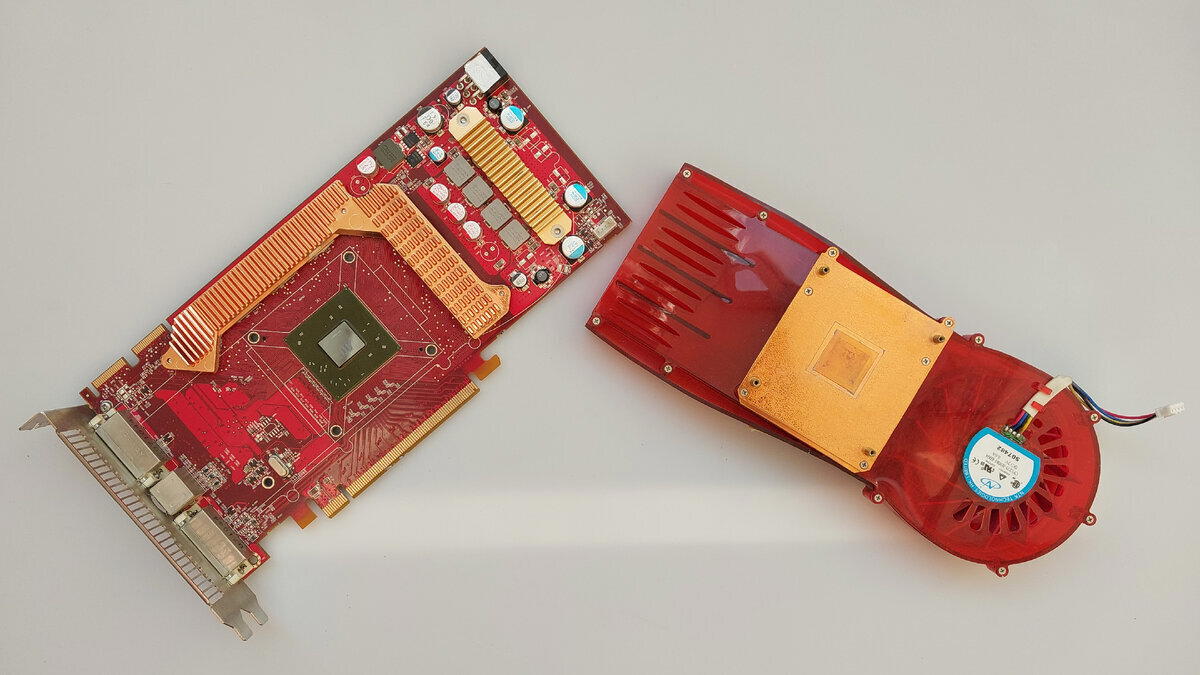

По традиции полезем под радиаторы.

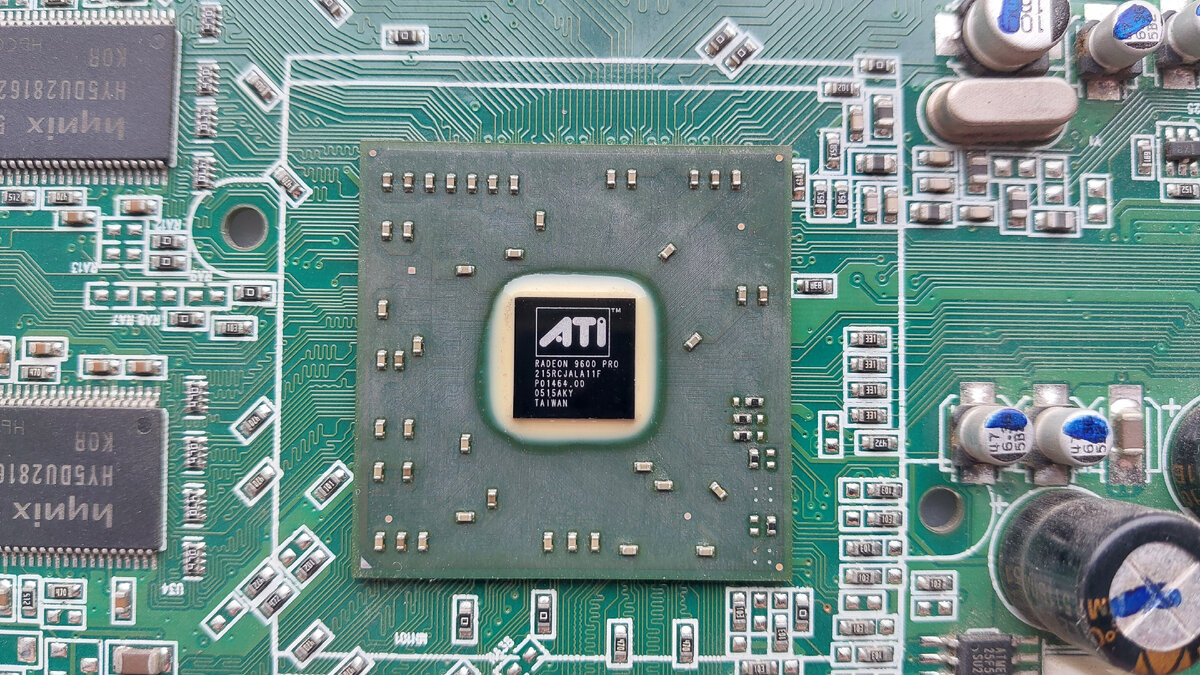

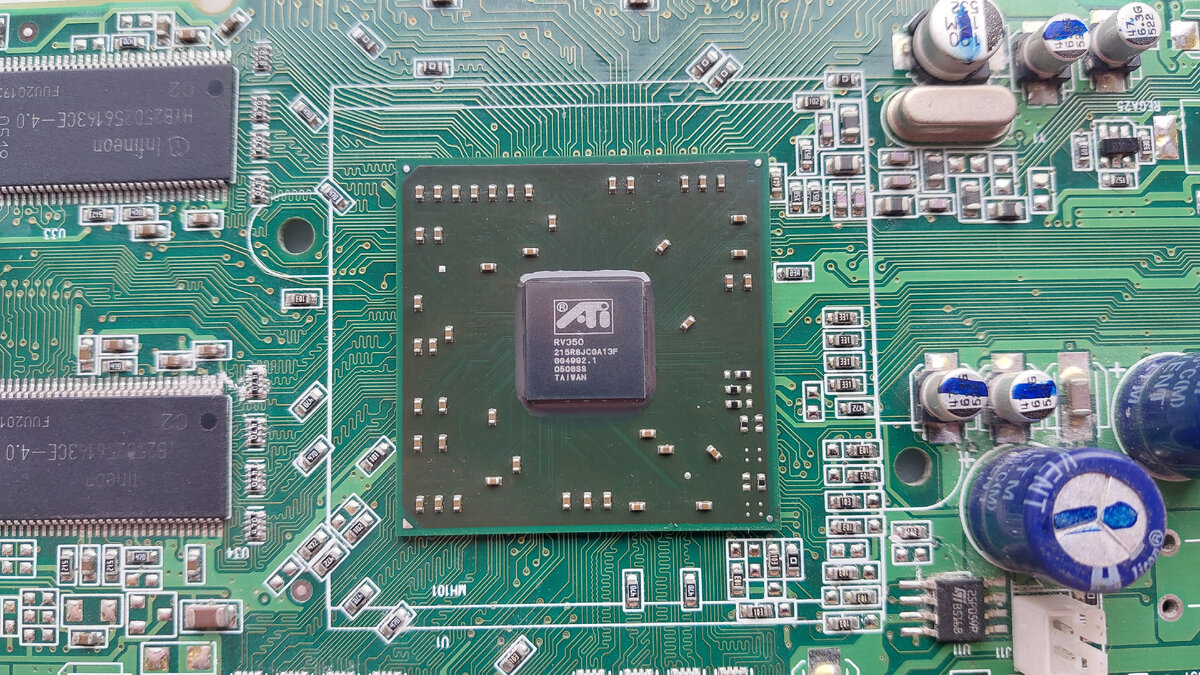

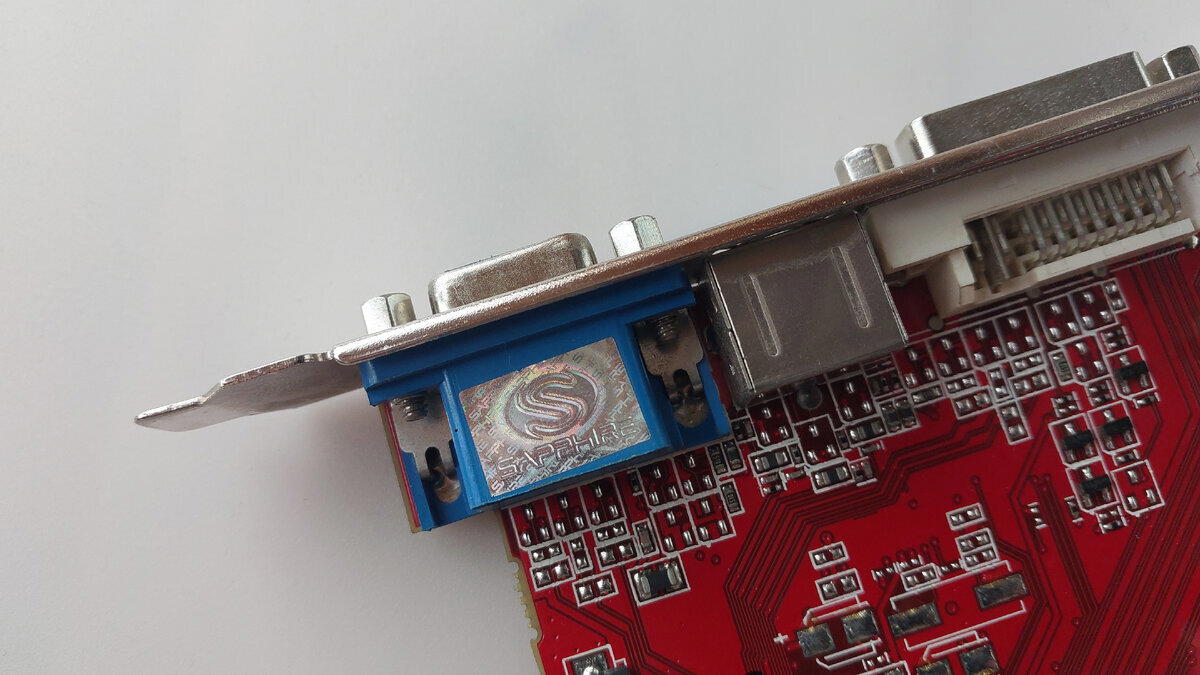

И тут у нас интересный момент. Видеокарта ATI Radeon 9600Pro на 128 мегабайт имеет золотистый кристалл на подложке с подписью Radeon 9600 PRO

То у второй карты на чипе нанесена маркировка ядра, а именно RV350.

Артикул у чипов тоже разный, но при этом характеристики у них одинаковые.

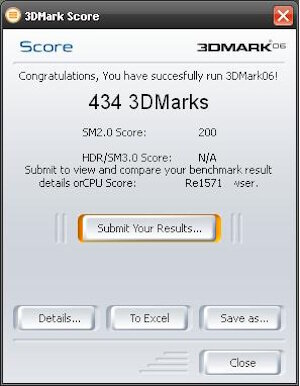

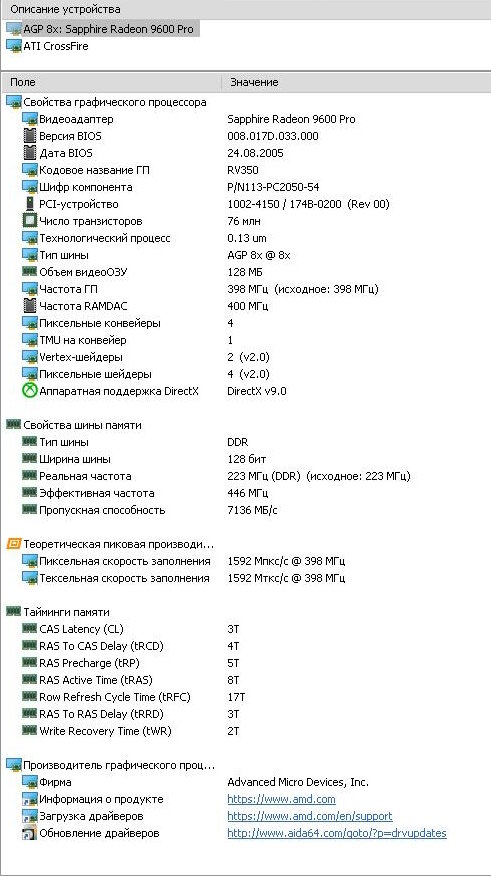

Немного сухих цифр.

Частота графического процессора: 398 МГц. Количество текстурных блоков: 4. Поддержка Shader Model: 2.0. Поддержка DirectX: 9.0. Поддержка OpenGL: 2.0. Шина: AGP 8x. Техпроцесс: 0.13 мкм.

Мне это что-то напоминает.… Ах, точно, мы с вами обозревали видеокарту ATI Radeon x600Pro, где кроме шины PCI-E характеристики идентичны. Я думаю в конце еще попугаев сравним.

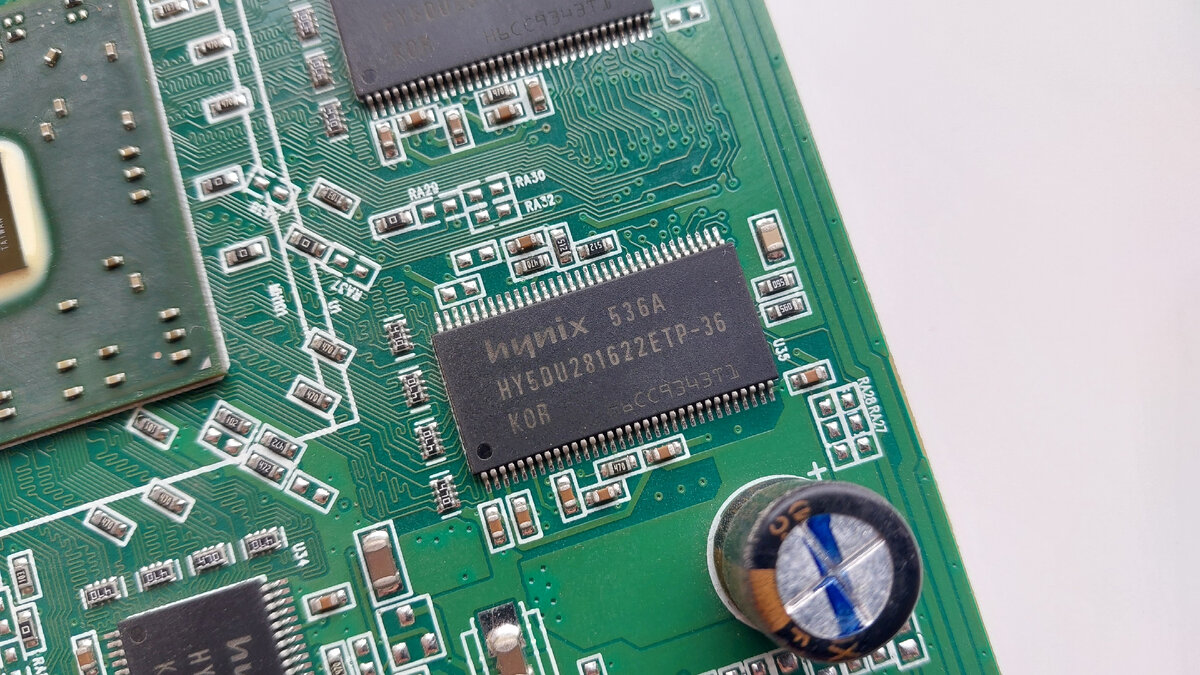

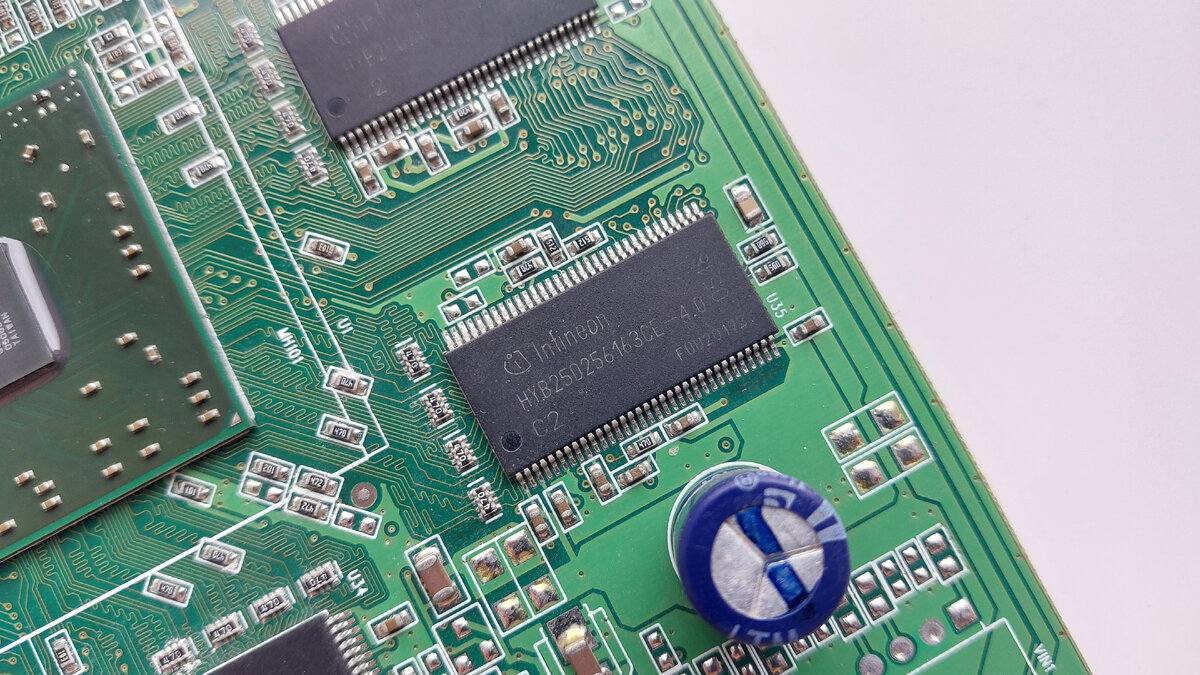

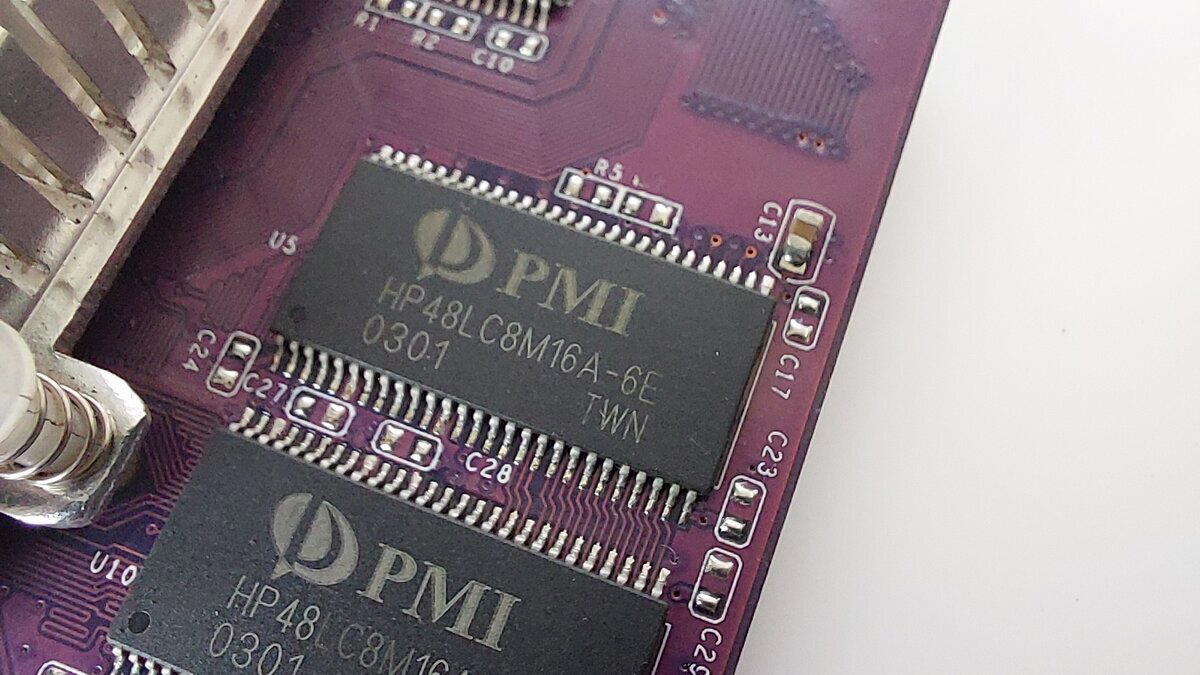

Память, как и графические процессоры, у наших карт разная как по объему, так и по производителю. У видеокарты ATI Radeon 9600Pro 128 Мб используется память Hynix тип GDDR, набрана она 8 чипами по 16 мегабайт. Частота памяти составляет 223 МГц (446 МГц) и ширина шины 128 бит. Судя по документации на чипы памяти, ее можно без ущерба немного разогнать (275МГц).

У второй карточки чипы памяти стоят от Infineon. Частота работы памяти, ширина шины и тип памяти точно такой же. Только память набрана из 8 чипов по 32 мегабайта. У этой памяти с разгоном хуже (250МГц).

Частота памяти и тип памяти у ATI Radeon x600Pro прилично отличается. Там используется GDDR2 память с частотой 500МГц. Следовательно, оценка бенчмарков у нее за счет этого будет выше.

Так. Ну, вроде покрутили, повертели, пора и к тестам приступать.

Напоминаю состав нашей тестовой платформы:

Intel Pentium D 935

Gigabyte GA-8i865GMK-775

DDR 3 Gb в двухканальном режиме

Windows XP

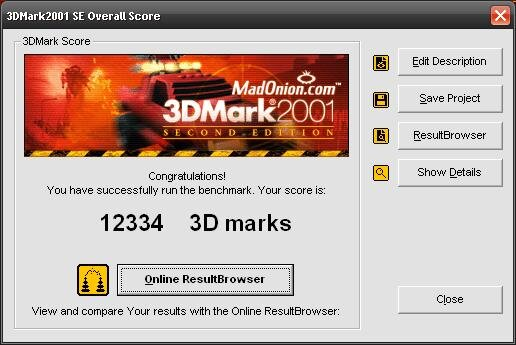

По традиции первый бенчмарк у нас 3D Mark 2001. В нем мы выбиваем 12334 (256 мегабайтная версия выбила 12009). Radeon x600 по неизвестным причинам выбил всего 9966.

ATI Radeon 9600Pro становится новым лидером среди ранее рассмотренных AGP видеокарт. Второе место занимает ATi Radeon 9100 и третье nVidia GeForce FX5200.

Radeon 9100, кстати, аппаратно держит только DirectX 8.1, при этом частоты памяти и графического процессора не сильно ниже чем у 9600. Из этого можно сделать вывод, что ATI Radeon 9100 идеально подходит для сборки игровых ретро компьютеров где не требуется поддержка DirectX 9.

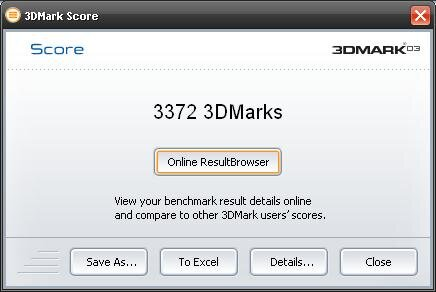

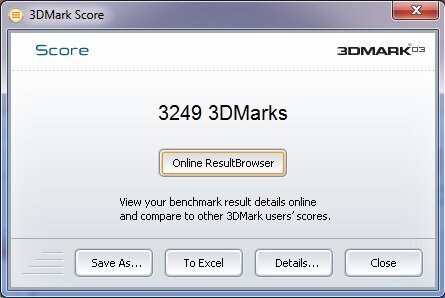

Следующий бенчмарк у нас 3DMark 2003. В нем обе видеокарты выбили 3372. Radeon X600Pro выбивал 3249.

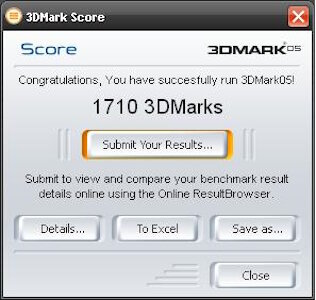

3DMark 2005 не вызвал проблем для наших гостей, 1710 выбила версия на 128 мегабайт, 1689 выбила версия на 256 мегабайт. Radeon x600Pro выбил 1731.

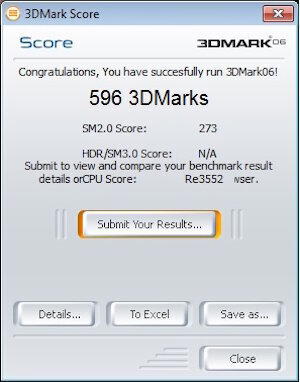

3DMark 2006. Впервые запускается для AGP видеокарт в наших статьях. Увы, из-за отсутствия поддержки Shader Model 3.0 оценка у нас не полная, но что есть, то есть. В нем мы набирает 434 за 128 мегабайтную и 427 за 256 мегабайтную версии. Radeon x600Pro, за счет более мощной платформы при тестировании, выбил 596.

Посмотрим на характеристики через AIDA64

В целом мне добавить больше не чего. Я лишь жалею о том, что в детстве избегал Radeon сидя только на известных мне GeForce и из-за этого, скорее всего, упустил часть игрового опыта.

Две эти видеокарты я оставлю себе, не буду продавать, есть у меня одна задумка. По этой же причине видеокарта Radeon 9100 по сей день остается у меня. Но о результатах моей задумки вы обязательно узнаете).

А сейчас я вынужден откланяться и попрощаться с вами. Спасибо вам за внимание и до новых встреч.

Здравствуйте мои дорогие читатели.

Сегодня у нас в гостях видеокарта, которую я держу в руках впервые. За это я должен сказать спасибо подписчику grenadiervint, именно он согласился отправить видеокарту в обмен на AMD Athlon x2 3800 для Socket 939.

После того как я видеокарту осмотрел, покрутил, узнал ее технические характеристики, немного поиграл и проверил в 3D тестах я решил написать статью.

Возможно, статья все-таки будет бедновата, так как в видеокарте нет ни чего примечательного.

Итак, начнем.

Сегодня у нас достаточно качественно сделанная видеокарта Matrox Millenium MGI G550 HD на 32Mb. Приписка AGP в шапке не просто так, видеокарта существует под разъем PCI.

Видеокарта резко отличается от всего того что мы рассматривали ранее высоким качеством исполнения. В схеме используются только твердотельные конденсаторы, система охлаждения держится на металлических клипсах, видеовыход VGA (D-SUB) выполнен на дочерней плате с возможностью отключения и установки видеокарты в низкопрофильный корпус, качественно подобранные компоненты, качественная обработка самой платы и хорошая шелкография.

Система охлаждения на видеокарте установлена пассивная, возможность подключить вентилятор отсутствует, при этом она прекрасно справляется со своими задачами.

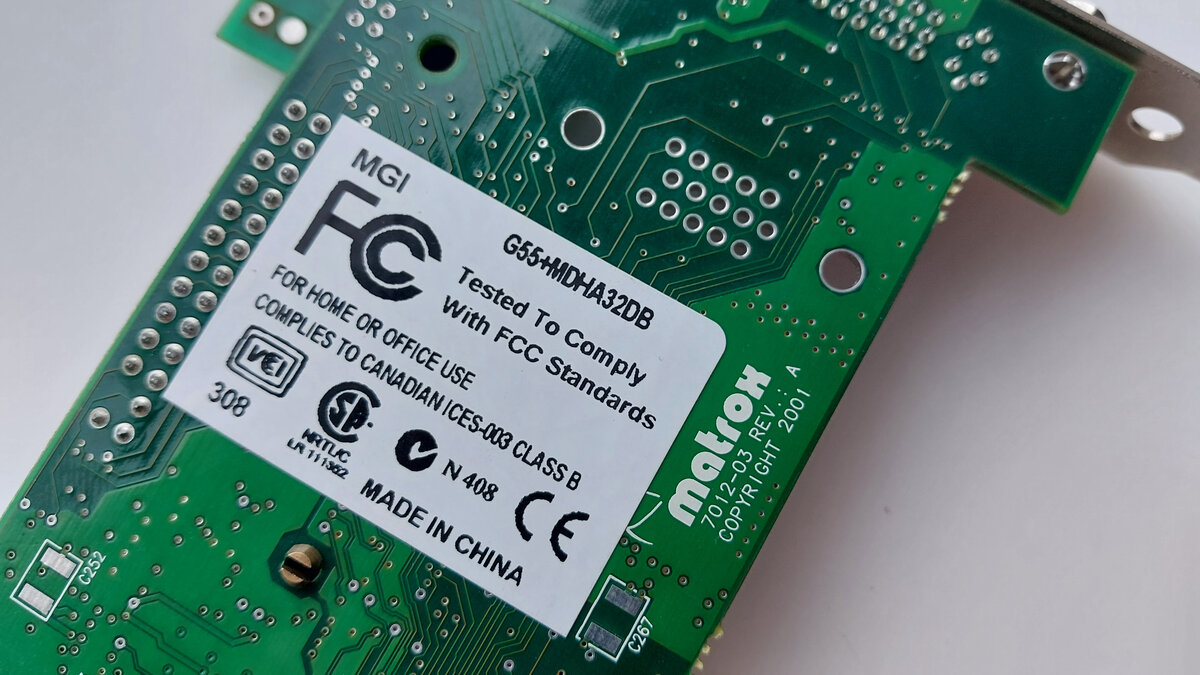

На обратной стороне карты мы можем обнаружить информационную наклейку, в которой еще надо разобраться.

Единственное что сходу можно понять, что чип у нас G550 и объем памяти 32 мегабайта, остальные буквы содержат неизвестную для меня информацию (кроме DH, это говорит о двух видеовыходах на видеокарте).

Некоторым из моих читателей видеокарта Matrox может вытащить кучу неприятных воспоминаний. Основное предназначение видеокарт данной фирмы это CAD или дизайнерские программы, либо для подключения нескольких мониторов(большинство видеокарт которые продавались в то время имели один VGA или VGA и S-Video), то есть была картой профессионального уровня и имела слабую производительность в играх.

В ранее написанных статьях некоторые комментаторы вспоминали видеокарты Matrox не очень добрым словом.

Пора посмотреть на компоненты видеокарты поближе.

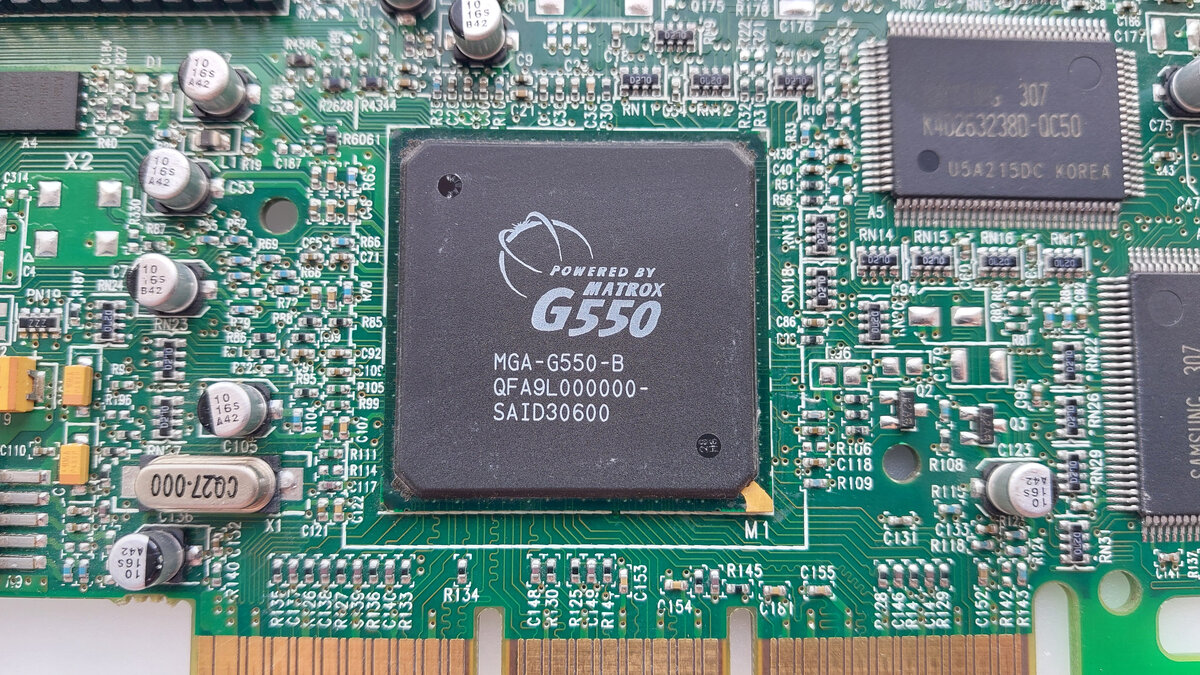

Под радиатором у нас скрывается графический процессор Matrox G550. Красивая гравировка.

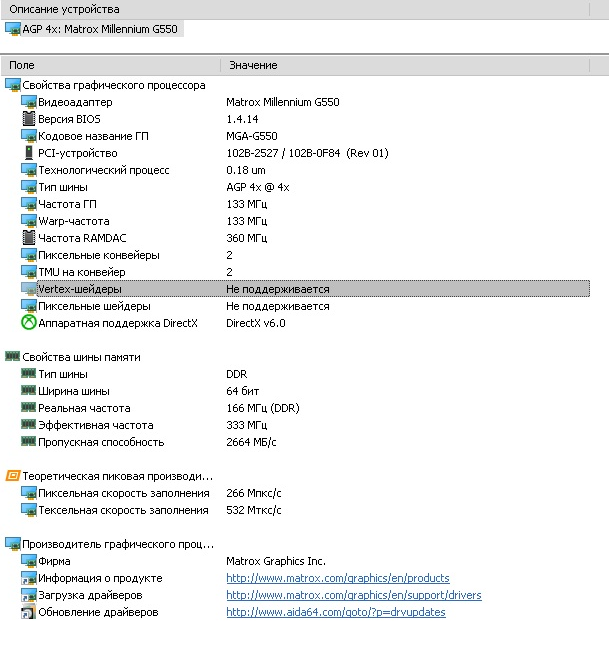

Графический процессор работает на частоте 133 МГц, имеет аппаратную поддержку DirectX 6.0, есть 2 пиксельных конвейера.

Чипы памяти установлены Samsung типа SDRAM с частотой 166 МГц. Память объемом в 32 мегабайта набрана всего 2 чипами по 16 мегабайт. Ширина шины при этом 64 бита.

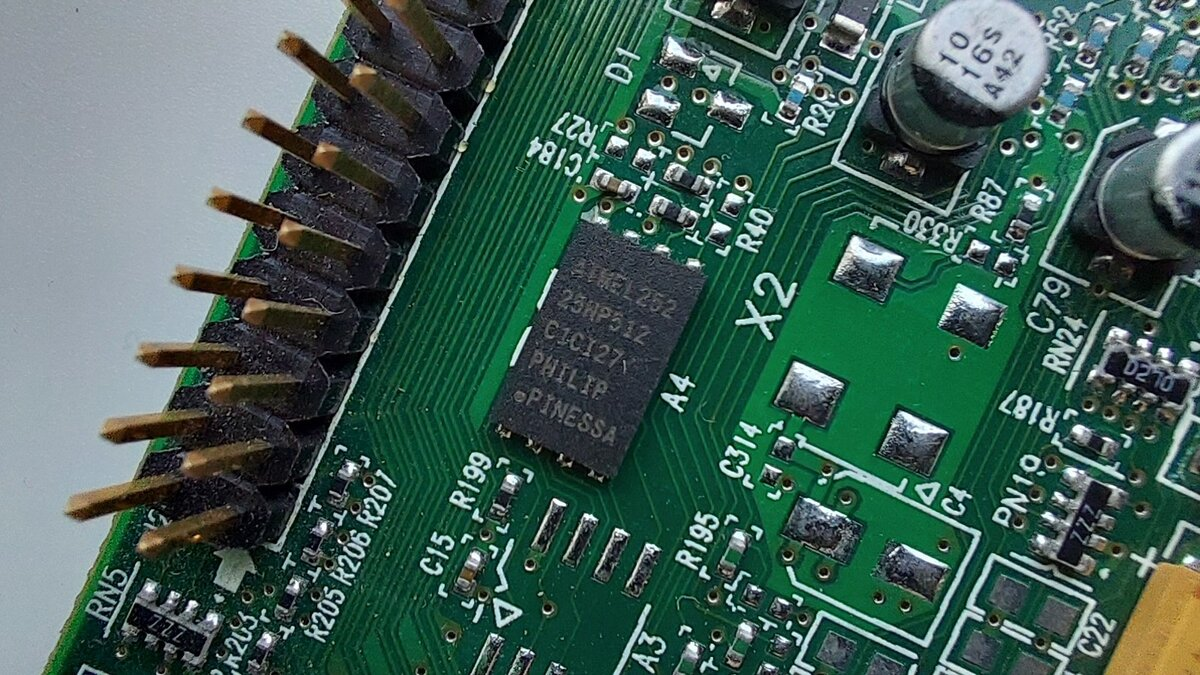

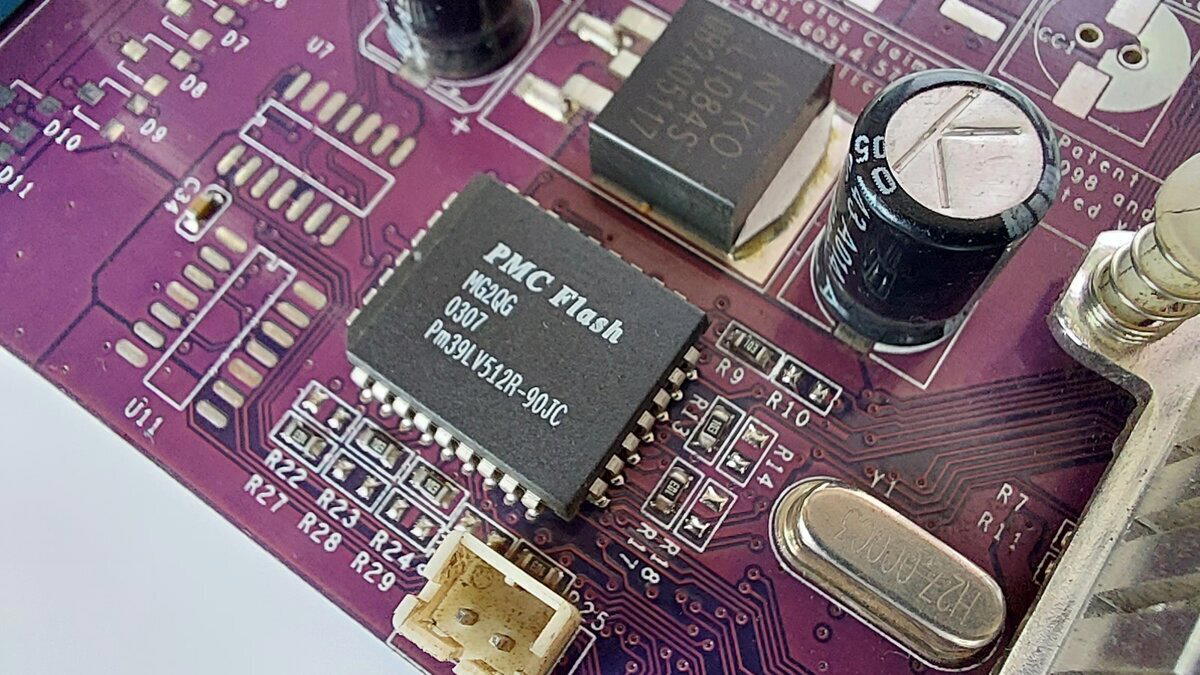

Из необычного для тех лет я еще увидел EEPROM, а точнее ее форм-фактор, в то время это не было так распространено. Зато сейчас, кстати, большинство БИОСов на материнских платах прошиты на SPI флешки подобного форм-фактора.

Сама видеокарта имеет разъем под шину AGP 4x.

Из видеовыходов, как было сказано ранее, у нас есть классический VGA (D-SUB) и DVI.

По техническим характеристикам видеокарта достаточно близка к nVidia Riva TNT2 M64.

Предлагаю посмотреть, сколько Matrox набирает попугаев в графических тестах.

Так как у нас поддержка только DirectX 6 бенчмарк будет всего один, 3DMark 2001.

Наша тестовая платформа неизменна: Intel Pentium D 935, 3 Гб DDR, Gigabyte GA-8i865GMK-775, Windows XP.

Интересно получается. По бенчмарку мы набираем 1427 попугаев, почти столько же набрала и ранее рассмотренная ATI Radeon 7000 которая тоже не относится к игровому сегменту.

Лично я на данной видеокарте поиграл в такие игры как Half-Life и Quake 3, на что-то большее просто не хватило времени (работа отнимает большую часть времени) и не могу сказать, что она меня как то удивила. Либо для меня это все банально, либо я неправильно выбрал соперника для сравнения. Единственное отличие от соперников это наличие двух видеовыходов и реально неплохое 2D (Если берем в сравнение Riva TNT2 M64).

По нашему обычаю давайте посмотрим, что нам скажет AIDA64.

Ну, вот мы с вами и прикоснулись к еще одной частичке истории, особенно я, я ранее никогда не держал карты от Matrox, а только слышал о них.

На этом можно завершить статью

Всем спасибо и до новых встреч дорогие друзья.

Здравствуйте друзья.

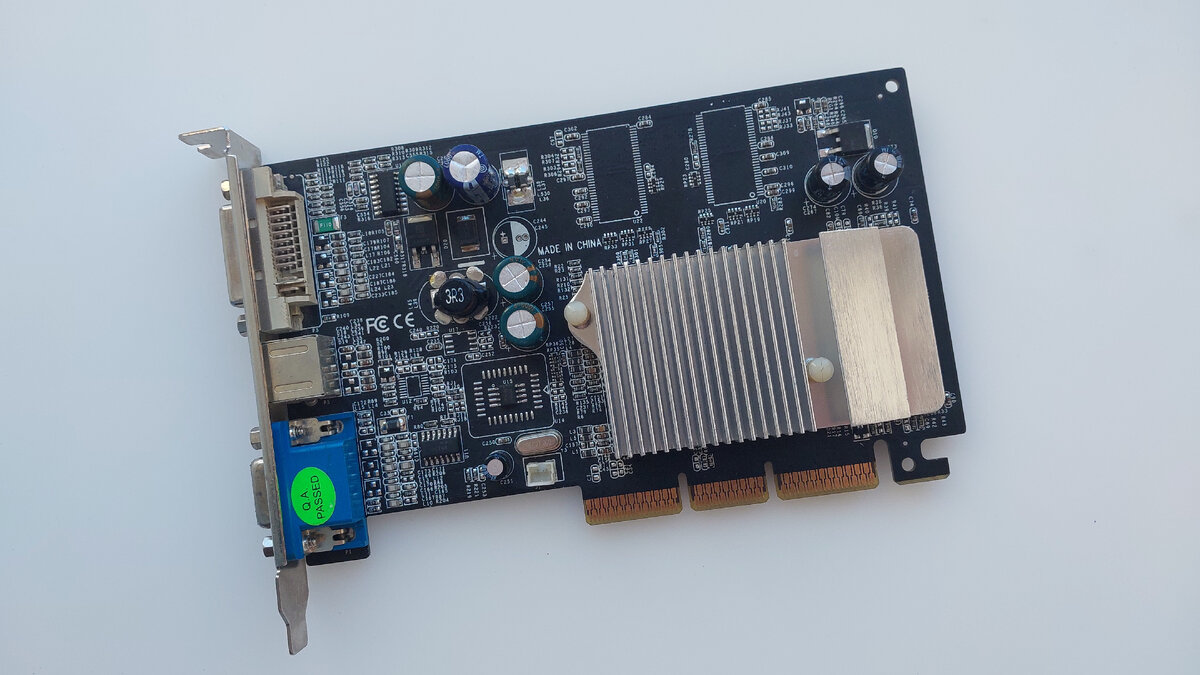

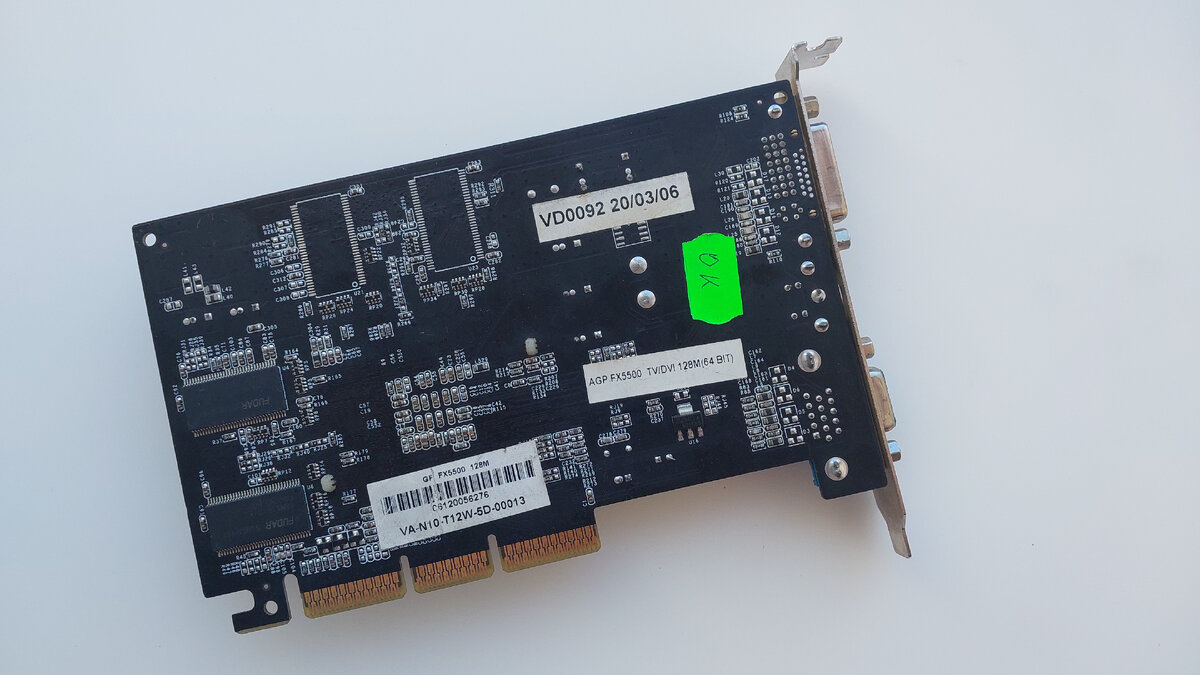

Сегодня у нас еще один представитель nVidia серии FX. На данный момент это последняя видеокарта от nVidia под шину AGP. Возможно, позже появятся другие карты. А вот о видеокартах от ATI еще есть в запасе, в скором времени напишу статью и про них.

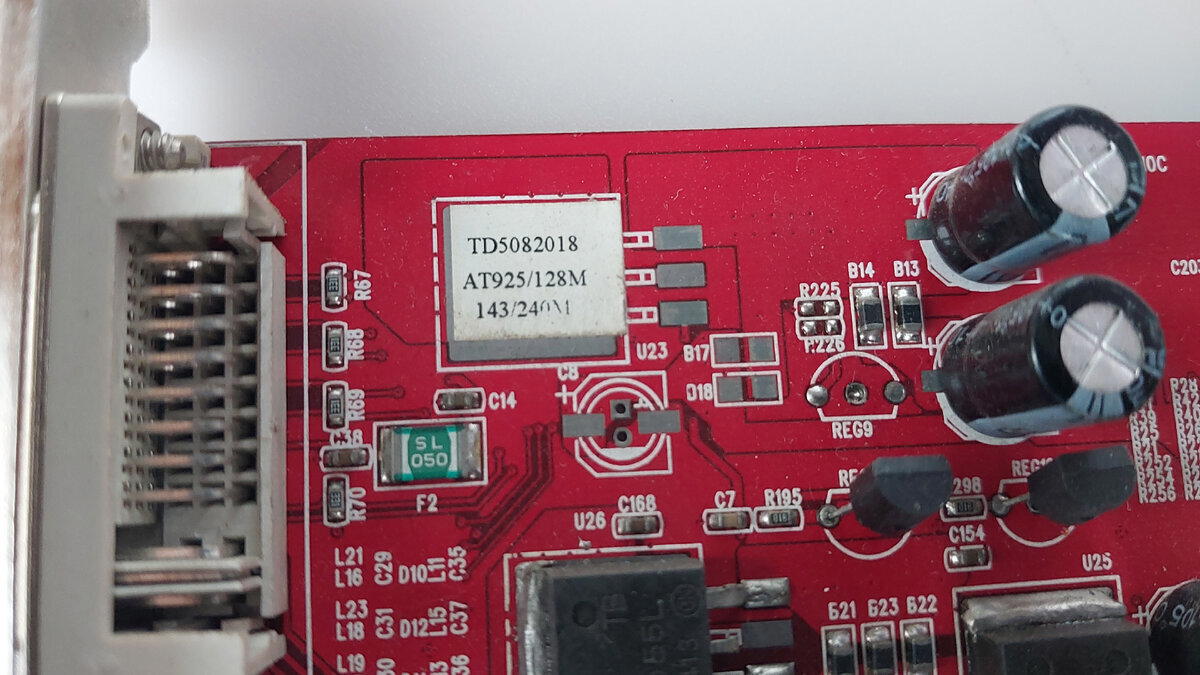

FX5500 не сильно отличается от той же FX5200, но при условии одинаковой ширине шины. В нашем же случае ранее обозреваемая FX5200 имеет 128 бит, а наш гость всего 64 битный.

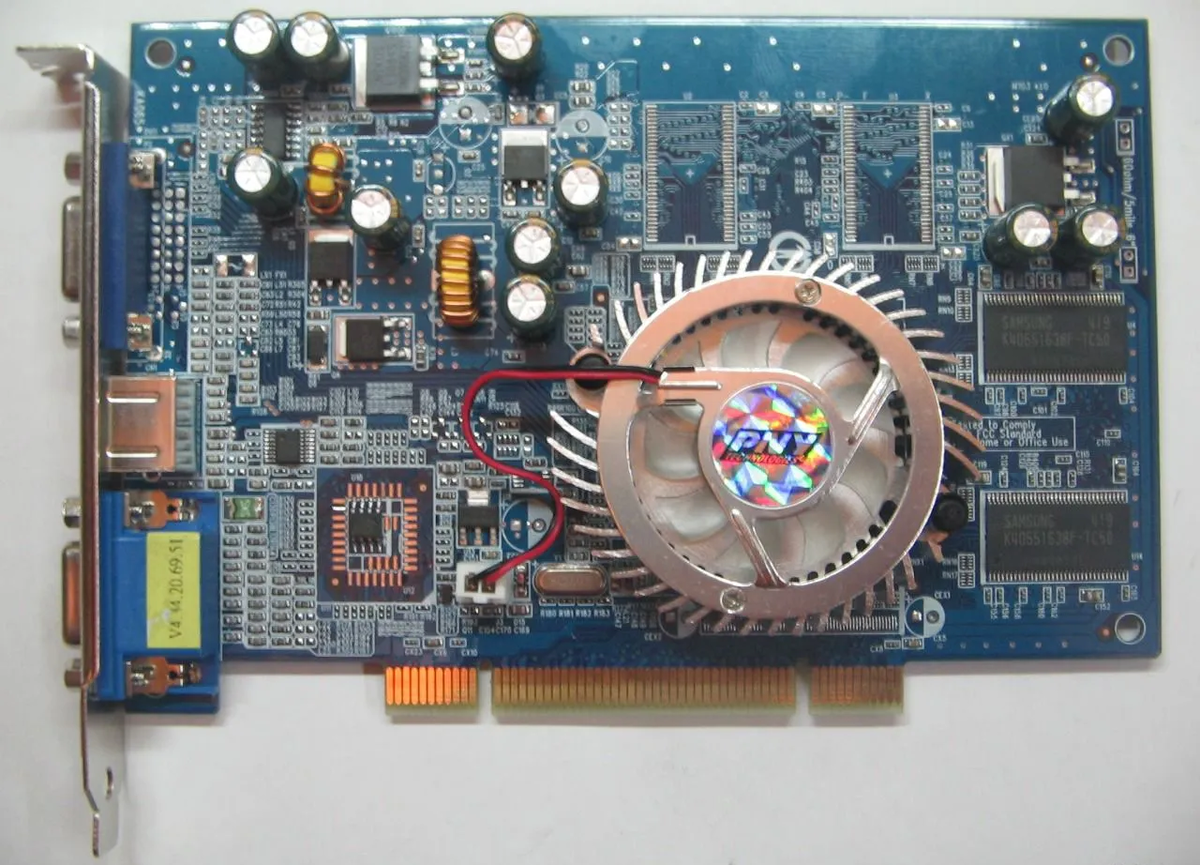

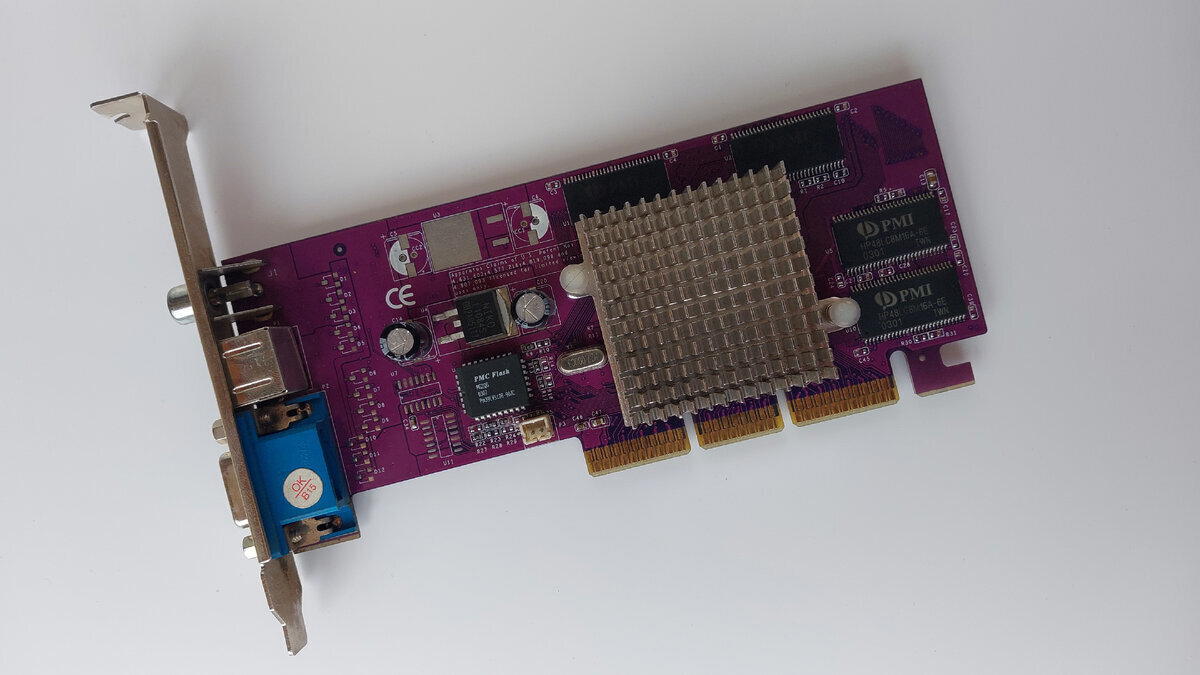

Вендора карты узнать не удалось, поэтому представляю вам ее простенько.

nVidia GeForce FX5500 128Mb

Особо тут не чего сказать, обычный пассивный радиатор, который, кстати, еще накрывает и оперативную память, хоть и не соприкасается с ней. Ну, еще можно выделить черный цвет текстолита, что изначально ее путает с эталонной FX5500 от вендора nVidia.

На обратной части тоже особо не чего интересного кроме двух информационных наклеек, которые говорят нам о модели карты, ее объеме, ширине шины и используемых видеовыходах.

Видеовыходы тут упомянуты не все. Помимо DVI и S-Video здесь так же имеется и D-Sub (VGA).

Так как снаружи больше ни чего интересного нет, заглянем под радиатор данной видеокарты.

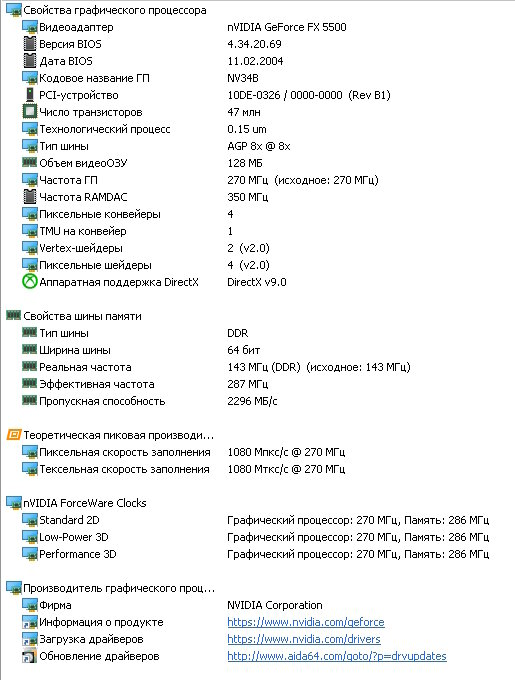

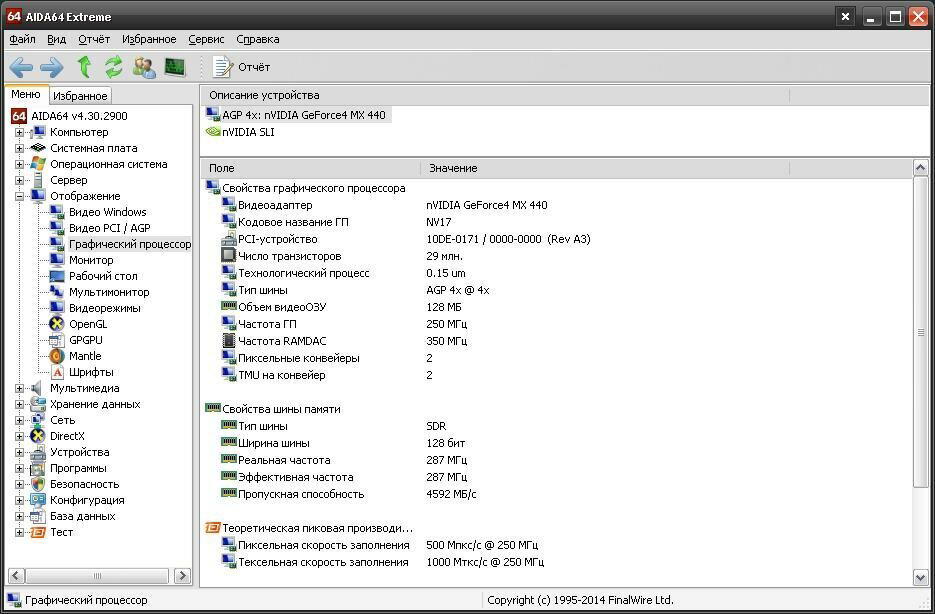

FX5500 построена на родственном FX5200 чипе, а именно NV34B. Разница на самом деле не большая, чуть более тонкий техпроцесс (0.14 против 0.15) и чуть выше частота графического процессора (270 против 250).

На самом графическом процессоре мы можем наблюдать модель 5500.

У FX5200 графический процессор выглядит как то красивее.

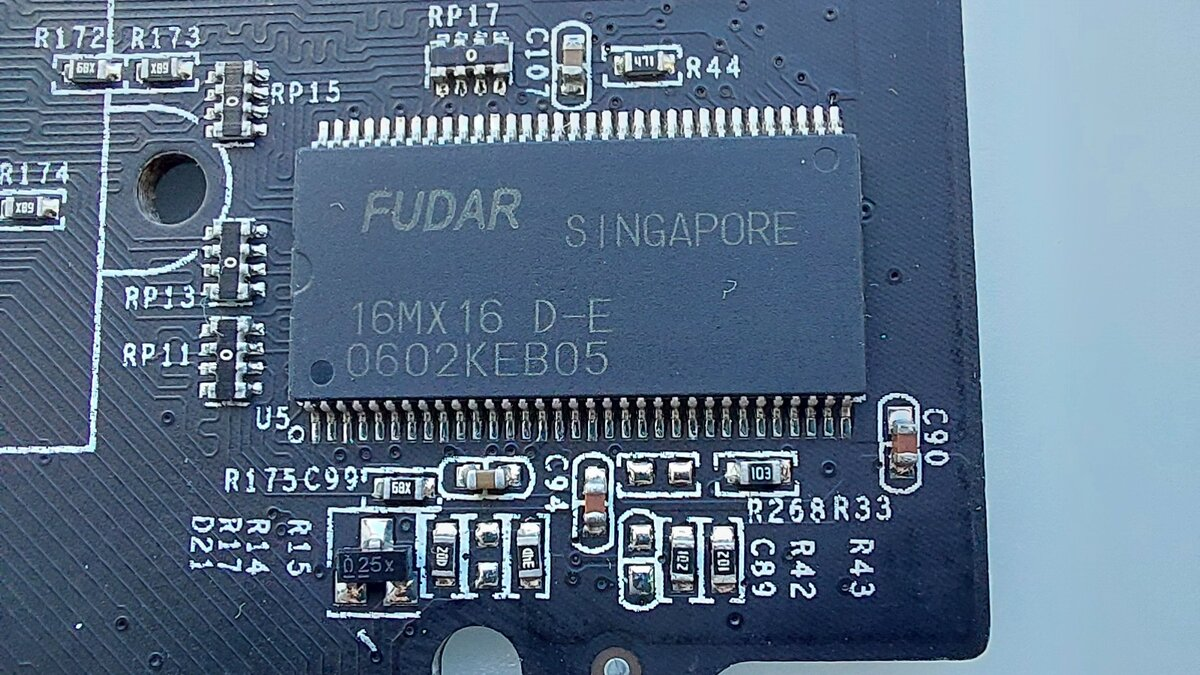

По официальным данным у карты мог быть только объем на 128 мегабайт с шириной шины 128 бит. Однако китайцы такие китайцы и сделали видеокарту с шириной шины 64 бита, не распаяв дополнительные 4 микросхемы памяти и отключив два канала.

Что тут у нас по памяти… Память производства Fudar. Тип памяти DDR, набрана 4 микросхемами по 32 мегабайта. Память работает на частоте 143 МГц (эффективная 287 МГц).

Кстати найти даташит на данную микросхему памяти, чтобы узнать на какой частоте она реально можно работать у меня не вышло, я думаю до 166 МГц разогнать все-таки можно. Официально память должна работать (и быть установлена) на 200 МГц (эффективная 400 МГц)

Вот пишу я статью и понимаю, что она получится достаточно компактная. Оно в целом понятно, более конкретно мы разжевали в статье про FX5200, да и истории из детства с ней были. А вот FX5500 я держу в руках впервые, да еще плюс ее близкое родство с FX5200 не позволяет повторяться.

Переходим к тестам.

Так как интерфейс у нашей видеокарты AGP 8x нашей тестовой платформой неизменно выступает Intel Pentium D 935 с материнской платой Gigabyte GA-8i865GMK-775.

Первым у нас идет по классике всех видеокарт на обзорах 3DMark 2001. В нем мы набираем 4060 (Ti?) попугаев. Это кстати чуть меньше чем у Radeon 9250.

Ширина шины влияет очень сильно.FX5200 на моей памяти набирала около 7000 попугаев в 2001 Марке. Графический процессор нашего гостя работает в номинале: 270МГц о чем было сказано ранее.

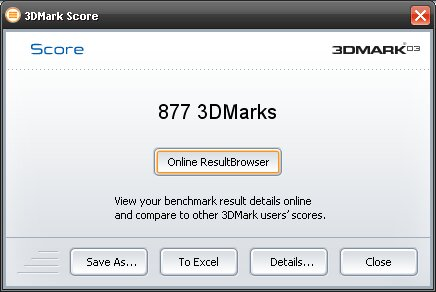

Идем далее. 3DMark 2003. Слезы, боль, страдание. 877 попугаев. Даже FX5200 с 64 битной шиной показывала результат куда больше.

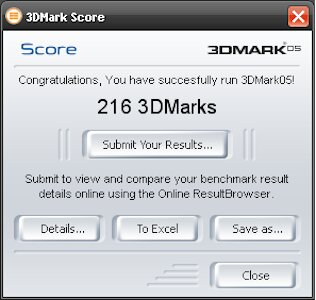

Ну и давайте напоследок 3DMark 2005. 216 попугаев.

Если предыдущий владелец покупал эту карту для игр, то его прям очень жаль.

Минутка информации.

К концу статьи я понял, что я вам соврал, была у меня в использовании FX5500 от вендора PNY. Зачастую он выпускает карты с интерфейсом PCI (Не PCI-E), соответственно у меня такая и была. Использовалась она в паре с AMD Athlon64 3800+ на 939 сокете с «полуотвальным» мостом.

Но на тот момент компьютер нужен был больше для работы, чем для игр. Из интересного, она была с двумя видеовыходами D-Sub и осматривая свои фотоархивы я нашел ее фотографию.

Сама же FX5500 позиционировалась как улучшенная версия FX5200 и совсем немного отставала по производительности от FX5600, если бы не большое количество подвальных видеокарт.

По традиции в конце статьи скриншот характеристик из AIDA64

На этом, пожалуй, все. Не думаю что данная видеокарта, как и статья, вызовет какие-то ностальгические чувства ввиду не сильной распространенности данной видеокарты, но я думаю, некоторым из вас было интересно узнать, что это за зверь (хотя у нас достаточно убогий пример).

Спасибо всем за внимание и до новых встреч.

Приветствую вас мои дорогие читатели.

Это моя первая статья в 2024 году.

Последняя статья была 5 декабря 2023 года, а статья про видеокарту HD3870, где было объявлено об этой статье, была написана аж полгода назад. Вся проблема в моей плавающей занятости, то свободен неделями, то работаю без сна.

Однако пришло время и пора уже выпустить эту статью и вернуть видеокарты подписчику. Надеюсь вам будет интересно.

Перед вами горячая широко известная мощь 2006 года от вендора XFX

Вообще 8 серия видеокарт GeForce еще печально известна своими "отвалами" не только в настольных компьютерах, но и в ноутбуках (К примеру, Acer Aspire 5520G). Наш экземпляр мало эксплуатировали, по этой причине он добрался до нас живым и здоровым и ни разу не тронутый паяльной станцией.

Дизайн видеокарты не отличается от дизайна эталонной nVidia, более того, мало кто отличался дизайном, максимум наносили свои наклейки на кожух.

Длина видеокарты составляет 29 сантиметров. Занимает сразу два слота. Напомню, что длина v составляла 22 сантиметра.

Начало статьи будет достаточно сухим, сразу скажу, самое интересное начнется чуть позже. На информационной наклейке у нас указана модель карты 8800GTX, частота графического процессора: 575 МГц, объем памяти: 768 мегабайт, тип памяти: DDR3 и какие видеовыходы установлены: 2 выхода DVI и S-Video.

Не помню точно, было ли это у 8800 GTX, но у GTX280 точно был индикатор рядом с видеовыходами. Он отображал работу видеокарты, красный – видеокарта не работает (сломана\перегрелась и ушла в защиту), зеленый – все в порядке.

Как я уже сказал ранее, почти все производители использовали эталонный вариант от nVidia, разве что мог отличаться цвет маски. Единственным отличием внешне это было нанесение своей наклейки на кожух системы охлаждения. Внутри же отличий могло быть больше, более высокие или низкие частоты графического процессора, другой производитель чипов памяти, другой график работы вентилятора.

Наш гость из всего вышеперечисленного имеет лишь плавный график работы вентилятора для сохранения тихой работы, но как результат мы имеем более высокие температуры ГП даже в покое.

Думаю с внешним осмотром карты можно закончить, можем лезть под «капот». Разбираем нашу видеокарточку.

Теперь можно начать подключать предыдущую статью про видеокарту Radeon HD3870, и начать делать какие либо сравнения.

Системы охлаждения видеокарт 8800 GTX и HD3870 разные. У HD3870 система питания и оперативная память охлаждалась отдельными радиаторами, а радиатор охлаждения центрального процессора можно было вытащить из кожуха, и представлял он из себя небольшой ребристый радиатор без тепловой трубки.

У 8800 GTX система охлаждения сделана единым целым. Охлаждение цепей питания и оперативной памяти осуществляется общей алюминиевой основой, в которой запрессована медная пластина охлаждения графического процессора. Вентилятор так же крепится на основу. Передача тепла от системы питания и чипов оперативной памяти осуществляется через термопрокладки.

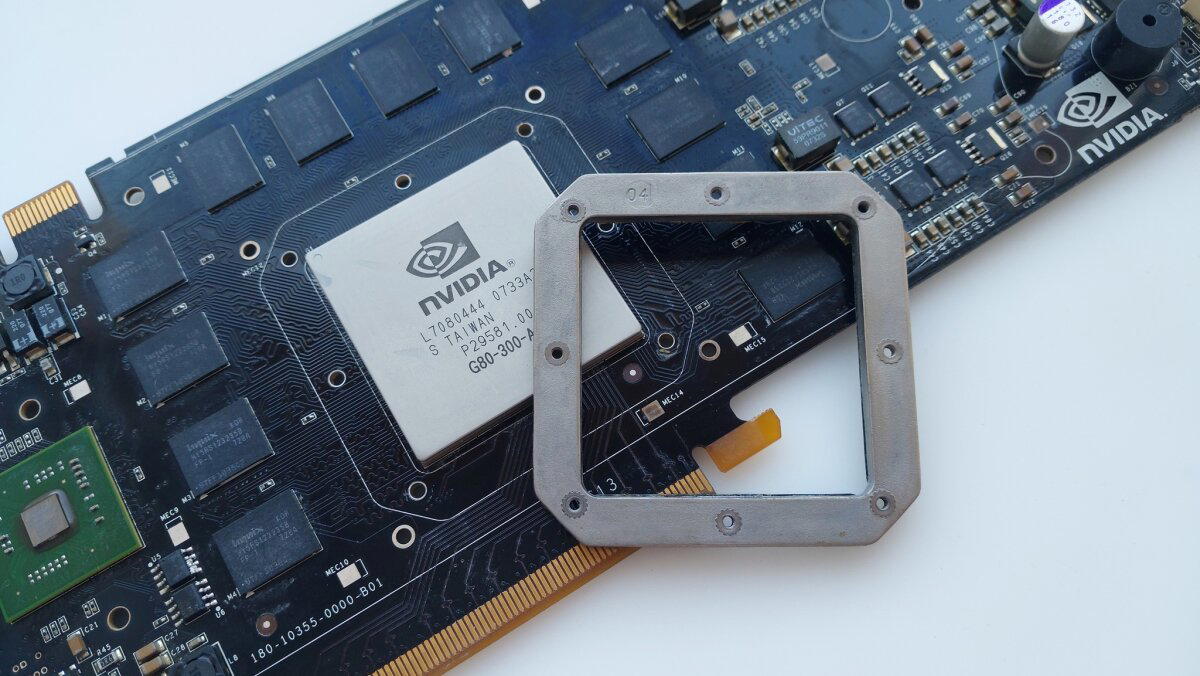

При разборе таких видеокарт как 8800 GT, 8800 GTX, GTX260, GTX280 я всегда замечал, что вокруг графического процессора есть металлическая окантовка. За свою практику я слышал разное мнение о функционале данной штуки, но мое мнение, что она предотвращает деформацию текстолита. Кстати ее так же можно открутить, более тщательно очистить чип от термопасты и ровным слоем нанести новую.

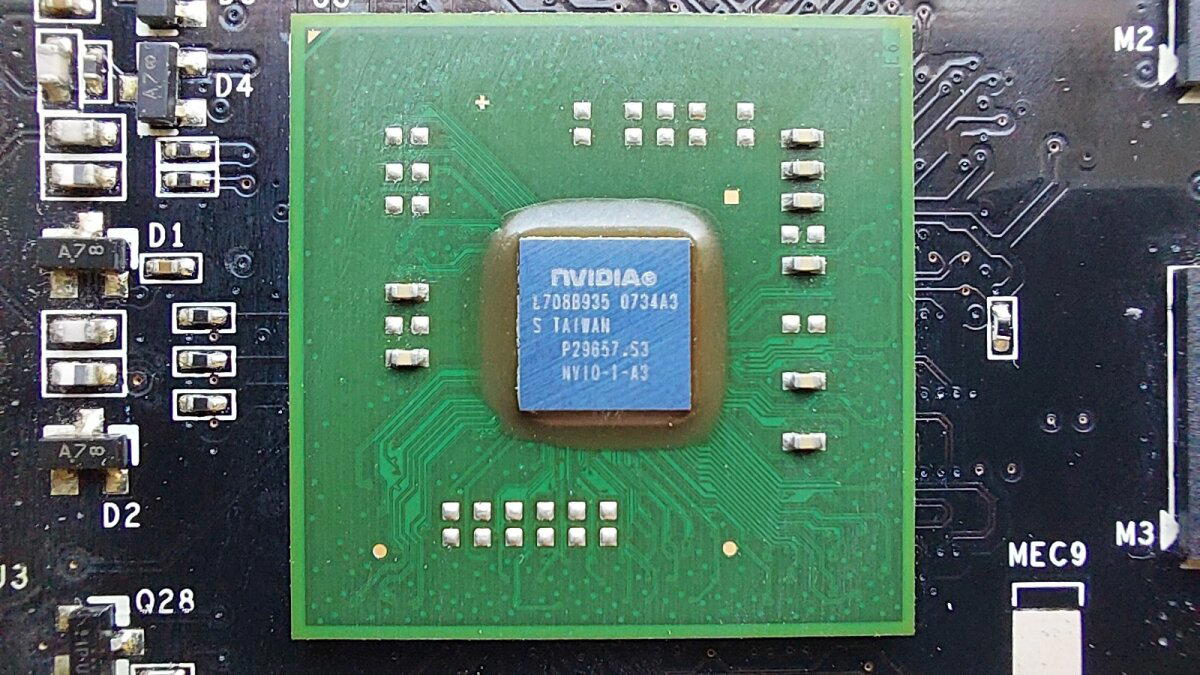

Медленно, но верно мы подбираемся к графическому процессору. Его величество чип G80. На тот момент это был самый крупный и самый сложный чип.

Из интернет источников

В начале ноября прошлого года в сфере потребительской трехмерной графики произошло важное событие – компания Nvidia анонсировала графический процессор нового поколения G80 с унифицированной архитектурой, поддержкой Shader Model 4.0 и DirectX следующего поколения. Новый чип получился чрезвычайно сложным; количество транзисторов в нем достигло невиданной ранее цифры 681 миллион, при этом, аналоговую часть и TMDS-трансмиттеры пришлось вынести в отдельную микросхему. Процессор G80 лег в основу нового семейства GeForce 8800, возглавленного видеоадаптером GeForce 8800 GTX.

Поскольку G80 имел 384-битную шину доступа к памяти и обладал высоким уровнем энергопотребления, новый флагман Nvidia также получился очень габаритным и массивным. Однако, как показало тестирование новинки, эти недостатки GeForce 8800 GTX были легко скомпенсированы выдающимся уровнем производительности в играх.

Частота графического процессора составляет: 575 МГц, частота шейдерного блока 1350МГц, поддержка DirectX 10.1, 32 текстурированных блоков, 24 конвейера растровых операций и 128 унифицированных шейдерных процессоров.

Чип закрыт тепло-распределительной крышкой. К слову "скальпирование" достаточно неплохо помогает.

У HD3870 частота графического процессора составляла 750 МГц, посмотрим, поможет ли это удержать «пальму» мощности среди осмотренных ранее видеокарт.

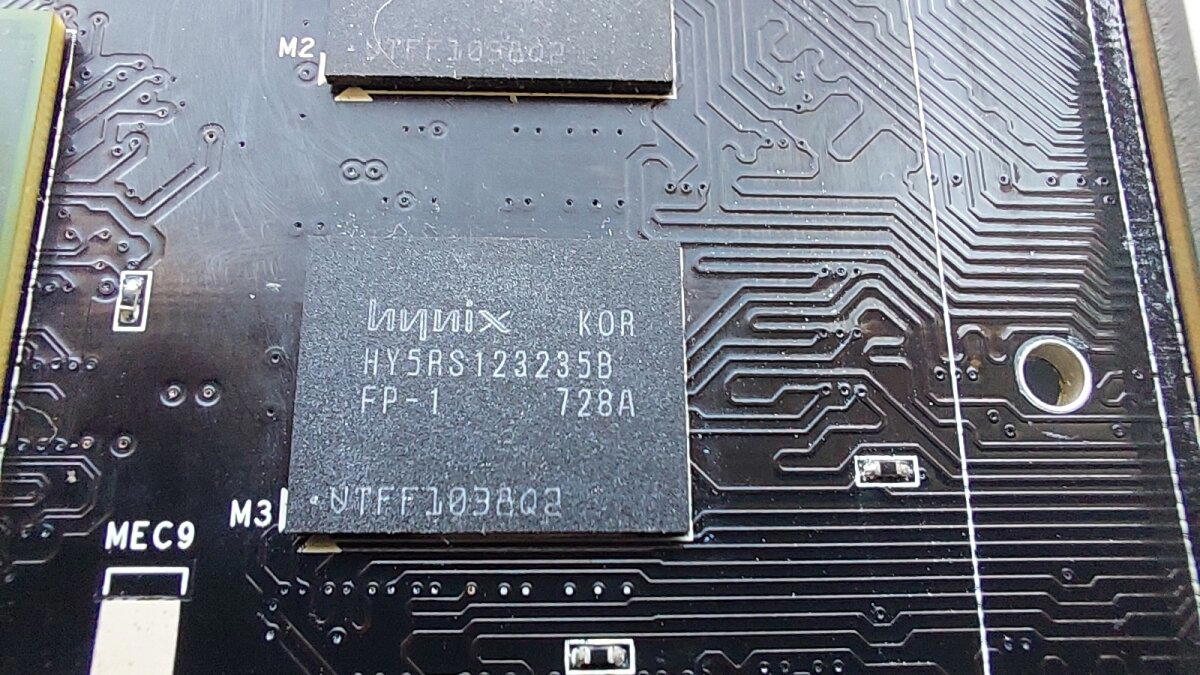

Оперативная память используется от производителя Hynix типа GDDR3. Память работает на частоте 1800 МГц. Объем одного чипа памяти 64 мегабайта, на видеокарте размещено 12 чипов памяти, что дает в сумме 768 мегабайт. Ширина шины: 384 бита.

У HD3870 использовалась память GDDR4 с частотой 2250 МГц. Но ширина шины там была всего 256 бит, но и объем памяти был 512 мегабайт.

Новый чип получился чрезвычайно сложным; количество транзисторов в нем достигло невиданной ранее цифры 681 миллион, при этом, аналоговую часть и TMDS-трансмиттеры пришлось вынести в отдельную микросхему.

Действительно, на плате имеется еще один чип с оголенным кристаллом, который, кстати, тоже охлаждается алюминиевой основной системы охлаждения через термопрокладку.

Данный чип как раз и отвечает за вывод изображения, и он тоже может «отваливаться».

Скорее всего, по этой причине 8800 GTX не может выводить звук на разъемы DVI, как это делает HD3870.

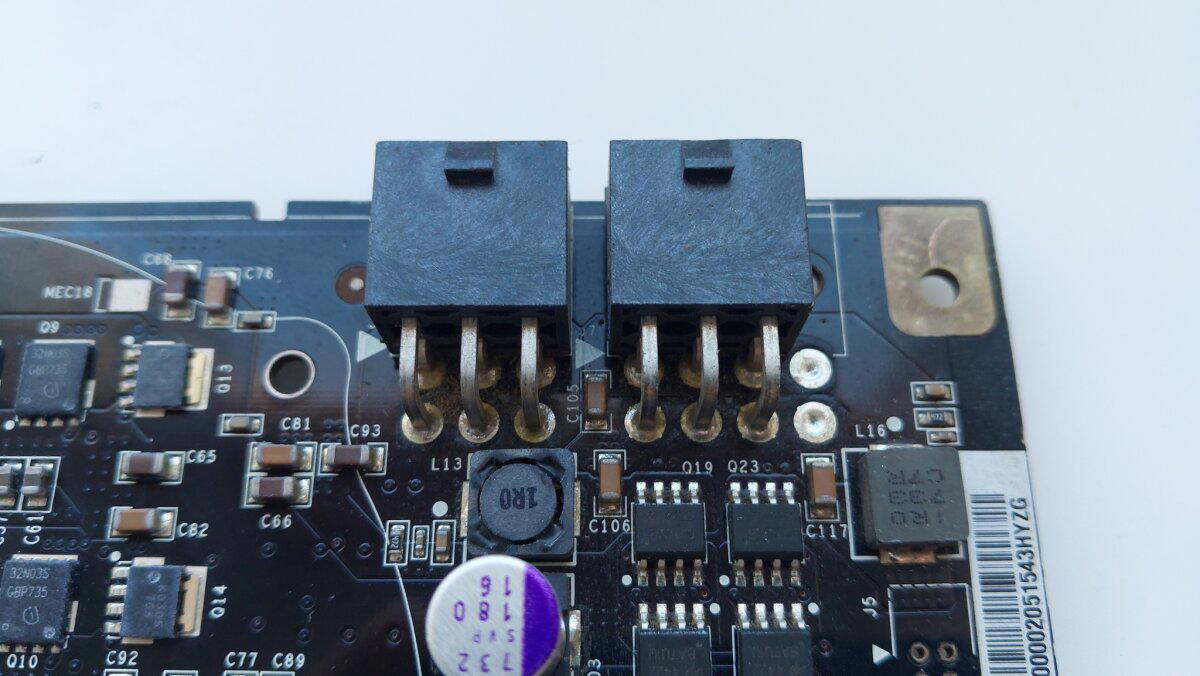

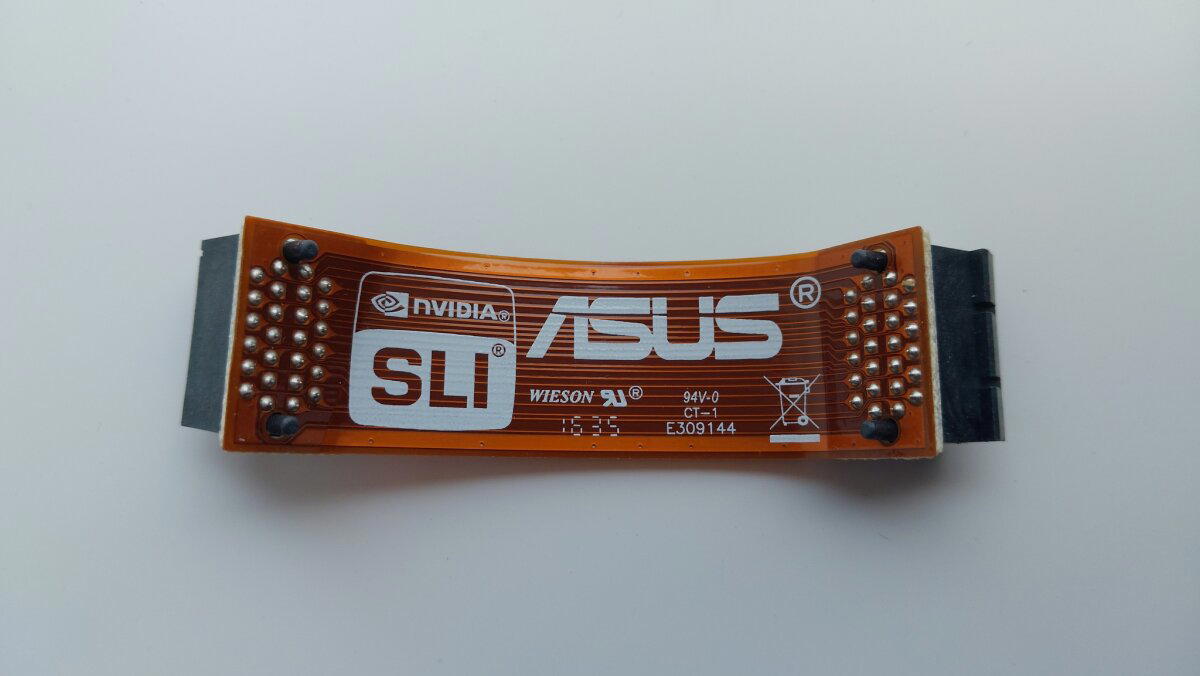

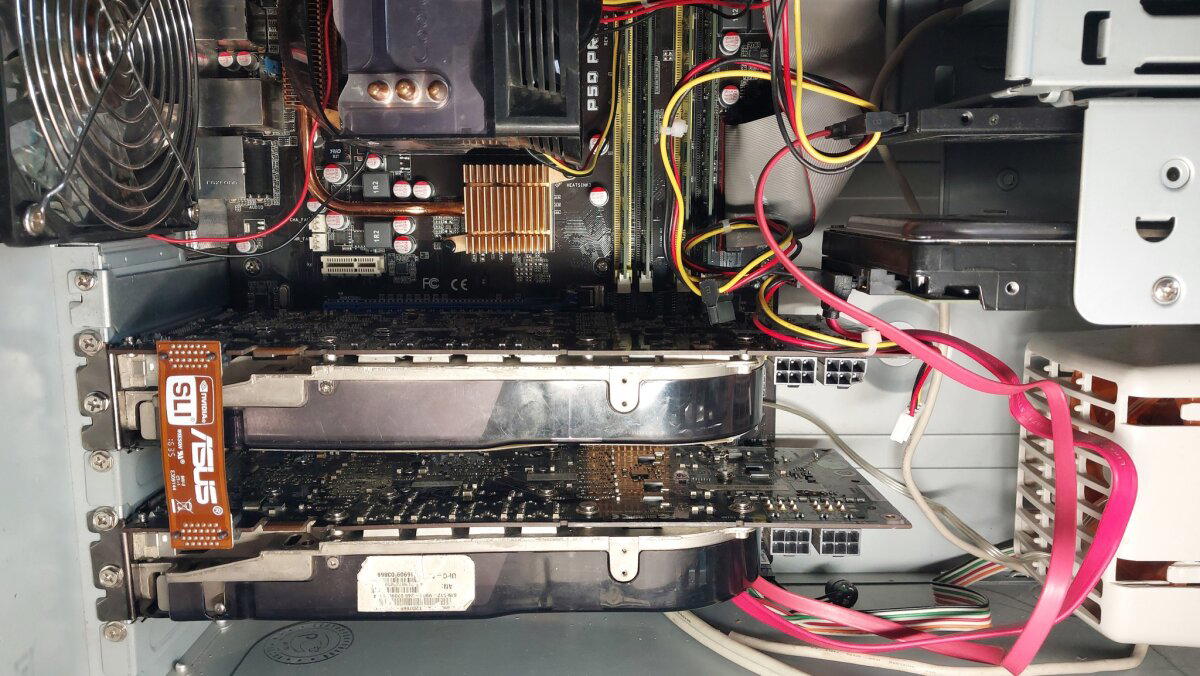

Видеокарта 8800 GTX поддерживает технологию SLI с возможностью подключения до 4 видеокарт (QuadSLI). Поэтому у нее предусмотрено два вывода для подключения SLI мостика.

HD3870 поддерживала такое же масштабирование по технологии CrossFire.

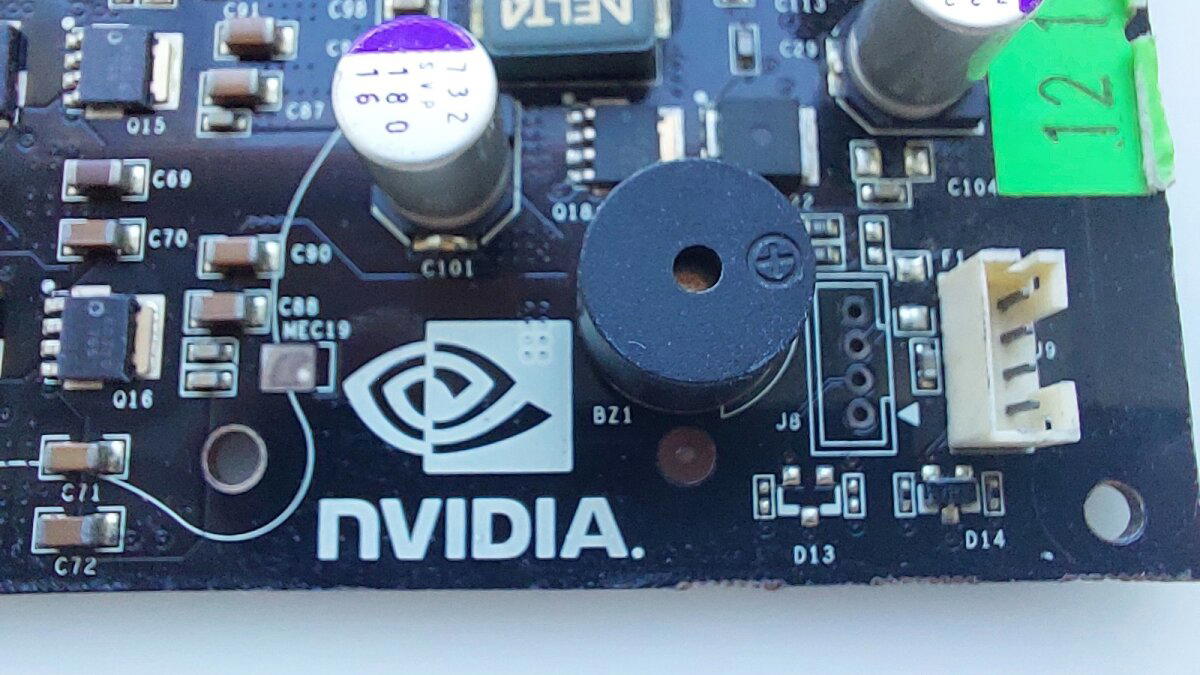

В углу видеокарты мы можем увидеть эталонный логотип NVIDIA и рядом спикер. Данный спикер очень громко пищит, если вы забудете подключить 6Pin питание к видеокарте.

GeForce 8800 GTX достаточно прожорливая видеокарта. В спецификации было указано, что минимум требуется блок питания на 450W, скорее всего не какой-нибудь подвальный «Китай». Для питания было необходимо два 6Pin коннектора. Зачастую в комплекте к 8800 GTX прикладывали переходник Molex>6Pin.

HD3870 так же требовала блок питания на 450W, но обходилась всего одним разъемом на 6Pin.

Видеокарты от nVidia объединялись в SLI систему специальными мостиками. Если мне не изменяет память данные мостики шли в комплекте с материнскими платами которые поддерживают технологию SLI (Типа Asus M2N-SLI Deluxe).

На самом деле для технологии SLI мостик не играет критически важную роль, он помогает лишь синхронизовать видеокарты с разными частотами графических процессоров. В моем видеоролике(Внимание! Ссылка ведет на Дзен, не является рекламой) SLI мостик не использовался.

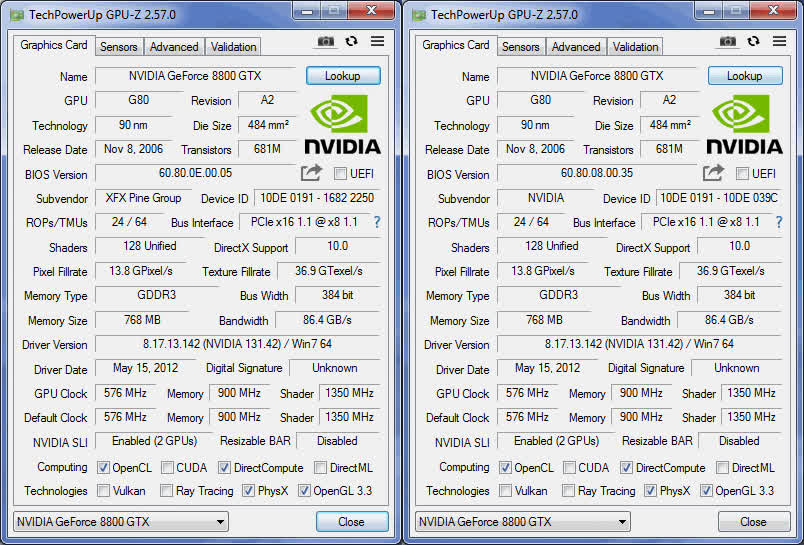

Самые внимательные, наверное, заметили что видеокарта, которая показывалась в начале статьи и видеокарта, которая участвовала в разборе это две разные карты. Так и есть, у нас в гостях две видеокарты. Вторая видеокарта от эталонного вендора nVidia. Увы, «отвал» ее догнал, и наклейка с кожуха не уцелела. У нее были выше частоты графического процессора и памяти, которые были снижены для синхронизации с видеокартой XFX и записью видеоролика с тестами в играх.

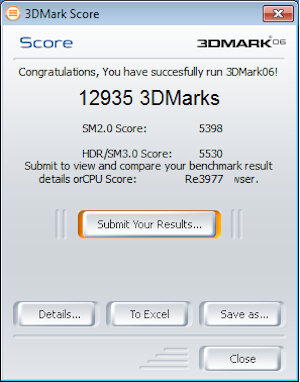

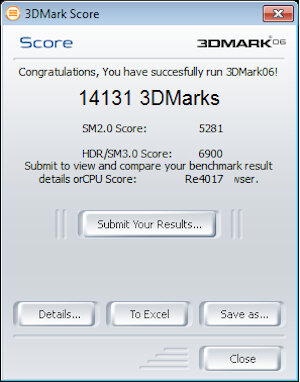

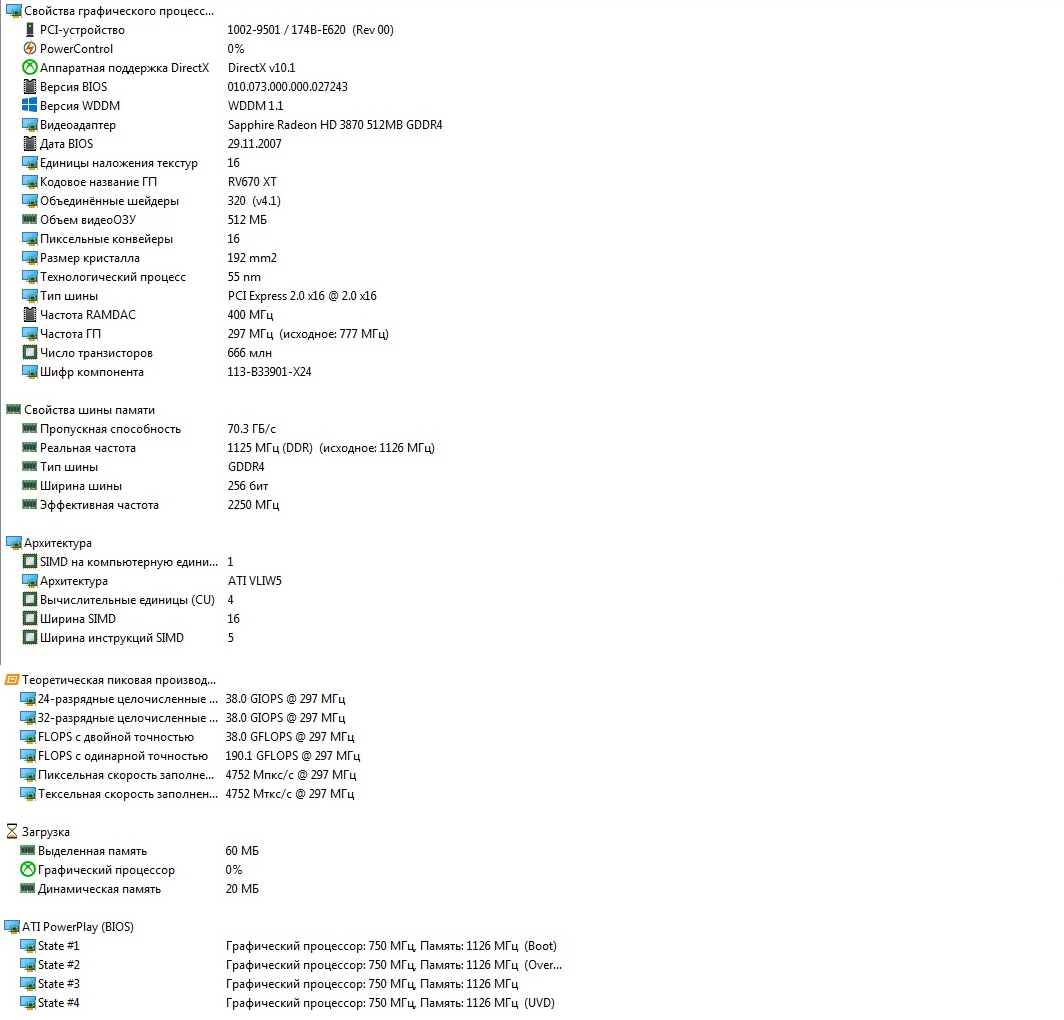

Пора переходить к тестам. Сегодня у нас все по классике 3DMark 2001\2003\2005\2006. Количество попугаев будем сравнивать с ранее упомянутой HD3870. Для начала ознакомимся техническими характеристиками не на словах, а на скринах.

Тестовая платформа у нас следующая: Intel Core 2 Quad Q9550, DDRII – 8Gb, Windows 7 x64, Материнская плата Asus P5Q PRO P35 чипсет. Пресеты настроек бенчмарков: по умолчанию, разрешение 1024х768х32.

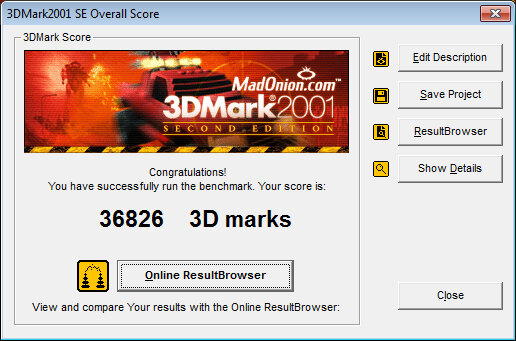

3DMark 2001 является достаточно старым бенчмарком, но именно с него начинаются тесты всех графических ускорителей у меня на канале.

Итак. HD3870 в 2001 марке набирала 33963 попугая. Смотрим результат 8800 GTX.

Несмотря на более высокие частоты графического чипа и памяти HD3870 теряет свои лидерские качества уже в самом начале.

Идем далее. 3DMark 2003. HD3870 показала результат в 34915 попугаев. 8800 GTX, ваш выход.

И снова проигрыш. Вообще HD3870 является аналогом 8800 GT.

Кстати вот вам и прямой пример, когда более высокая частота не является показателем более высокой производительности. А если вы останетесь на моем канале я вам это докажу еще на центральных процессорах.

3DMark 2005. Про поддержку SLI данного бенчмарка информация разная, то держит, то не держит. В общем, проверяем только одну карту. HD3870 показала результат в 16915 попугаев. Смотрим сколько у нашего гостя.

Чем ближе к годам выпуска видеокарт тем меньше разрыв. В данном случае можно это посчитать за погрешность, но не будем

А вообще HD3870 вышла в 2007 году, спустя почти год после выхода 8800 GTX.

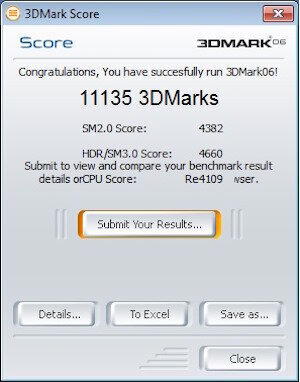

3DMark 2006 должен, наконец-то поставить точку кто сегодня займет «пальму» самой мощной видеокарты моего канала. HD3870показала результат 11135 попугаев. Что покажет 8800 GTX?

nVidia GeForce 8800 GTX в сухую победила HD3870, не дав ей не единого шанса.

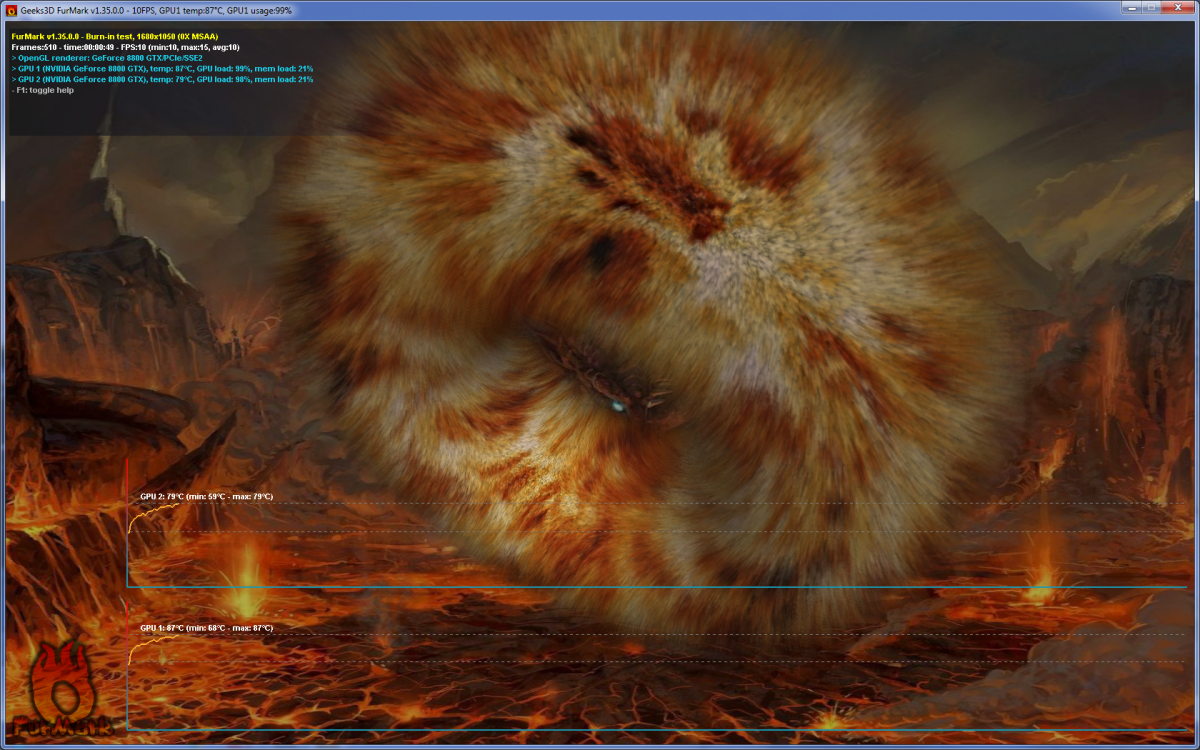

А теперь короночка. 3DMark 2006 с 8800 GTX в режиме SLI.

Разница в окончательных баллах увы не такая какую мы ожидали от двух видеокарт, но это все из-за того что тест 3DMark комплексный, а не делающий упор только на графику.

Мне кажется, я уже вижу, как ваши ручки тянутся написать «Как ты запустил режим SLI на плате, которая его не поддерживает?» Действительно, материнская плата не поддерживает SLI, но умными головами (а изначально вообще патч был придуман ребятами в AsRock) был выпущен патч не только для активации SLI режима там где это не предусмотрено, но еще и объединять разные по сериям видеокарты.

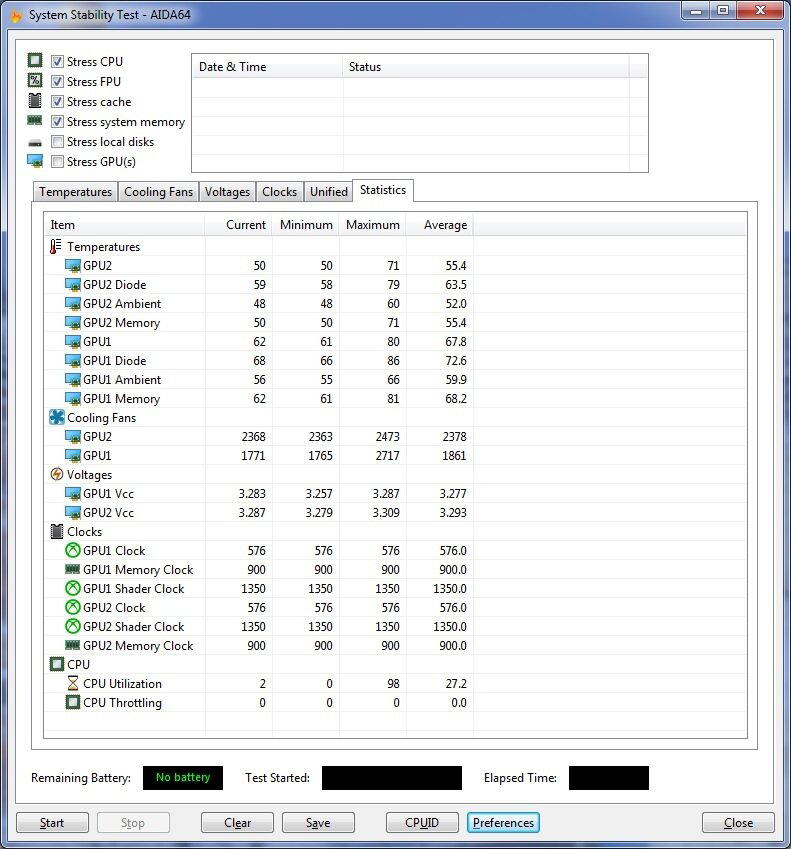

8800 ПЕЧ GTX достаточно горячие видеокарты. Особенно когда они еще греют друг друга в режиме SLI.

Как я и говорил, у XFX видеокарты вентилятор работает медленнее, что можно заметить в статистике. Лишь только при превышении 80 градусов происходит резкий скачок оборотов, когда вторая видеокарта с более высокими оборотами просто не дошла до этих температурных значений.

Ну и под конец фотография установки этих двух монстров в один системный блок. Даже в 2024 году это до сих пор выглядит прикольно.

Моя статья подошла к концу. Спасибо всем за внимание и до новых встреч.

Выражаю благодарность подписчику grenadiervint за предоставление видеокарт для статьи.

Если вам было интересно вы так же можете почитать другие статьи о видеокартах, подборка откроется по этой ссылке.

Под спойлером не является чем то обязательным.

Так же при желании вы можете поддержать мое творчество и отправить донаты по этой ссылке. Донаты принимаются от 2 рублей. Так же подключена монетизация и от самого Pikabu.

NVIDIA объявила о старте международных продаж видеокарты GeForce RTX 4070 Ti Super по рекомендованной цене $799. Этот же уровень стоимости был установлен на модели RTX 4070 Ti, снятой с производства и замененной новинкой.

В России новая карта уже доступна благодаря параллельному импорту, но, как ожидалось, её цена у российских ретейлеров значительно выше.

Так к примеру магазин ситилинк продаёт карты по 107 000 руб, что на 50 процентов выше заявленной цены, с учётом современного курса.

Графический процессор AD103-275 с 8448 ядрами CUDA является основой GeForce RTX 4070 Ti Super, что на 768 ядер CUDA больше, чем в чипе GeForce RTX 4070 Ti. Новая карта оснащена GPU, который включает 66 SM-блоков, 96 блоков растеризации, по 264 тензорных и текстурных блока, 66 RT-ядер и 48 Мбайт кеш-памяти L2. Базовая и Boost-частота GPU у нового GeForce RTX 4070 Ti Super составляют 2340 и 2610 МГц соответственно. В сравнении, у обычной RTX 4070 Ti заявлены частоты 2310 и 2610 МГц.

В результате тестов стандартных характеристик GeForce RTX 4070 Ti Super, новинка показала лишь до 7 % большую скорость по сравнению с оригинальной моделью RTX 4070 Ti. Кроме того, в играх без трассировки лучей она оказалась медленнее более доступной Radeon RX 7900 XT со стоимостью $710.

#без_пяти_минут_как_актуально

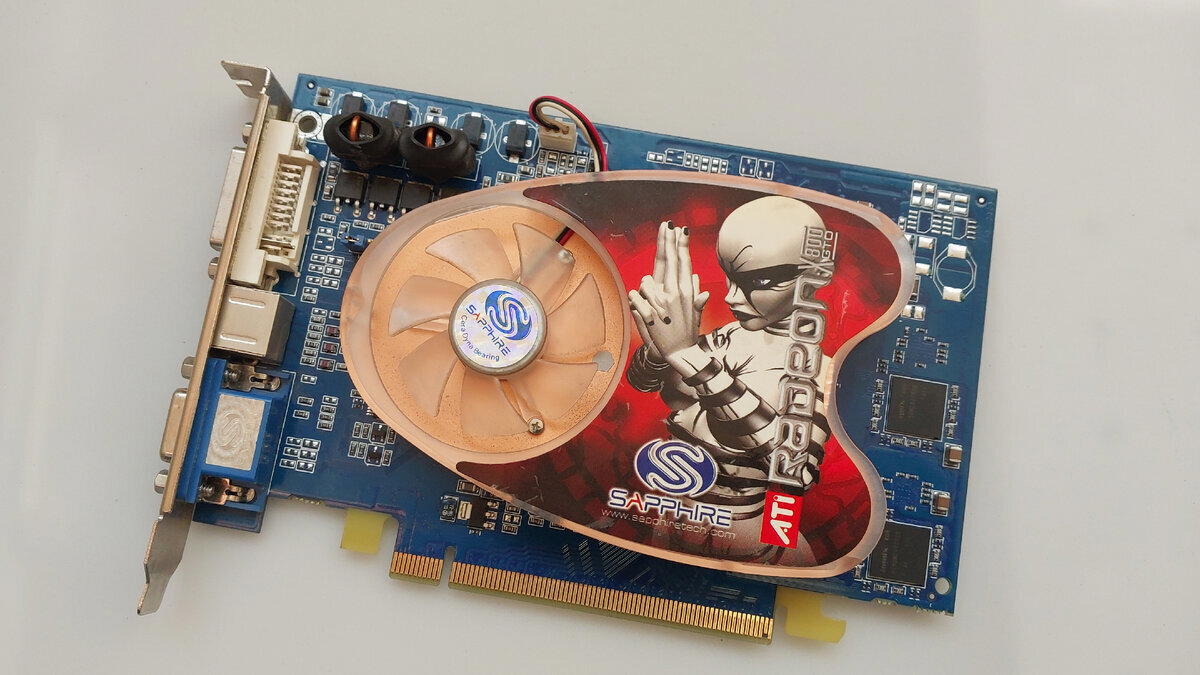

Здравствуйте дорогие читатели.

Сегодня у нас еще одна статья подряд про «красные» видеокарты. В гостях ATI Radeon x800 GTO, которая в свое время позиционировалась как игровая видеокарта.

На лицевой части мы можем наблюдать наименование вендора Sapphire, а так же наклейку с игровым персонажем.

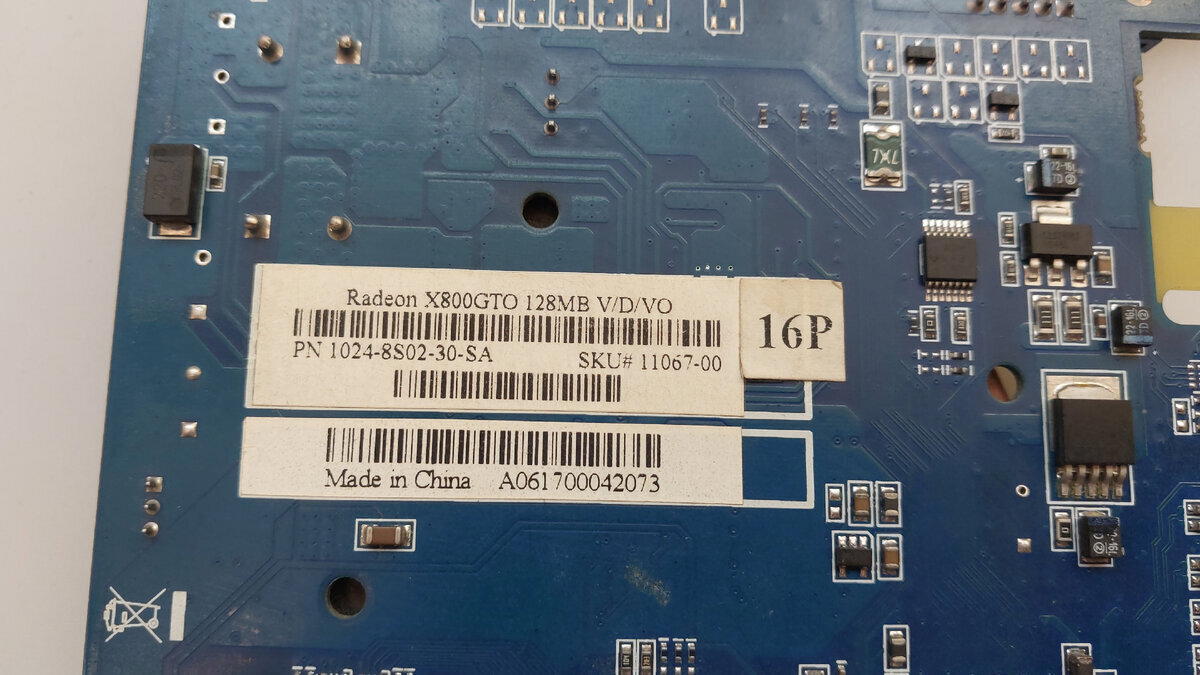

На обратной части видеокарты мы можем обнаружить наклейку с информацией о карте.

Самое интересное, что текстолит видеокарты в отличие от предыдущих x600 и HD3870 на вендоре Sapphire не красного оттенка, а синего.

На самой информационной наклейке указана стандартная информация: Серия карты, объем памяти и тип видеовыходов.

По коду SKU так же можно определить дополнительную информацию. Существует даже табличка с расшифровкой этих данных.

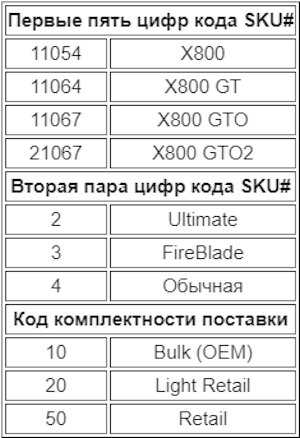

Набор видеовыходов стандартен: D-Sub(VGA), DVI и S-Video

На разъеме VGA можем узреть голографическую наклейку Sapphire.

При написании статьи про ATI Radeon x600 я забыл упомянуть один момент. На плате имеется джампик переключения видеостандартов PAL\NTSC. Он есть и на нашей плате x800 GTO.

По разъему S-Video поддерживается вывод композитного или компонентного видеосигнала.

Пора переходить к технической части видеокарты.

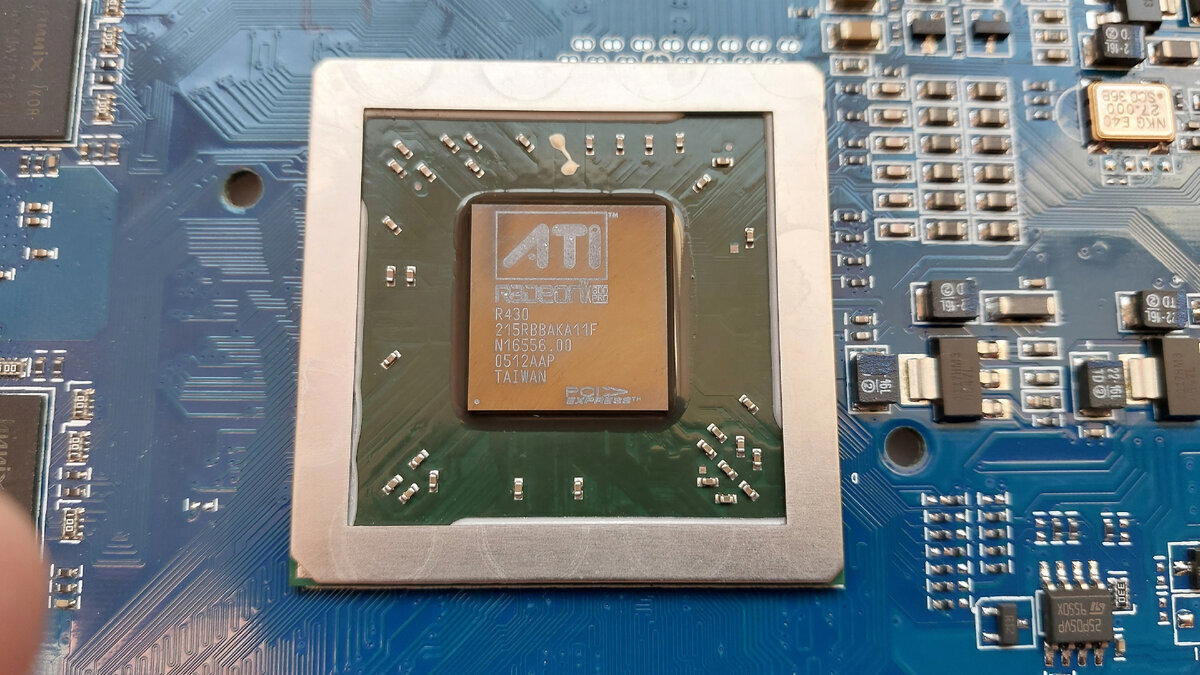

В отличие от предыдущей гостьи ATI Radeon x600, данная карта не имеет ни чего общего с Radeon 9600. Серия x800 была создана уже на новых чипах R420 для AGP и R423\R430\R480 для PCI-E x16.

Данная карта создана на графическом чипе R430 и имеет гравировку X800PRO. Частота графического процессора у нас 392МГц, имеет 16 Pixel и 6 Vertex шейдеров. Присутствует аппаратная поддержка DirectX 9.0 и Shader Model 2.0

Как можно заметить, у видеокарты разблокированы все пиксельные шейдеры, обычно их было включено всего 12.

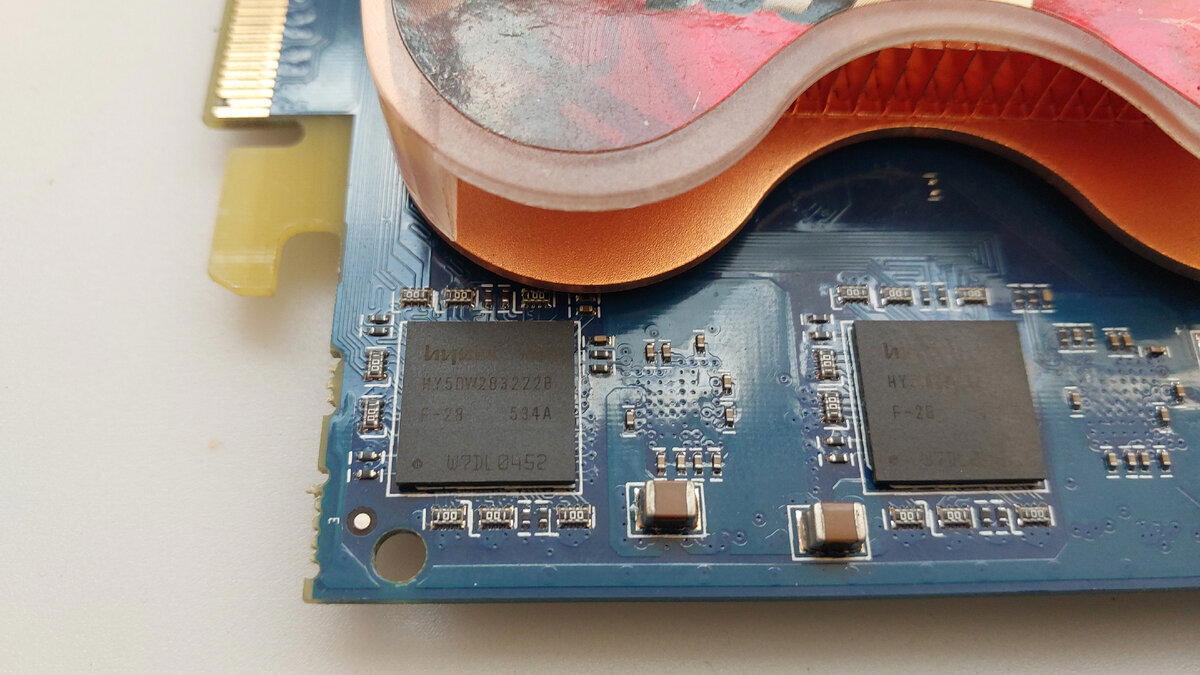

Оперативной памяти у нас тут немного, всего 128 мегабайт. Набрана память 8 микросхемами по 16 мегабайт производителя Hynix.

Оперативная память у нас типа GDDR в упаковке BGA. Частота памяти составляет 700МГц, ширина шины 256 Бит.

По отзывам в интернете у видеокарты достаточно неудачное сочетание GPU-ОЗУ. Однако версии на 256 Мб повезло больше, там устанавливается GDDR3.

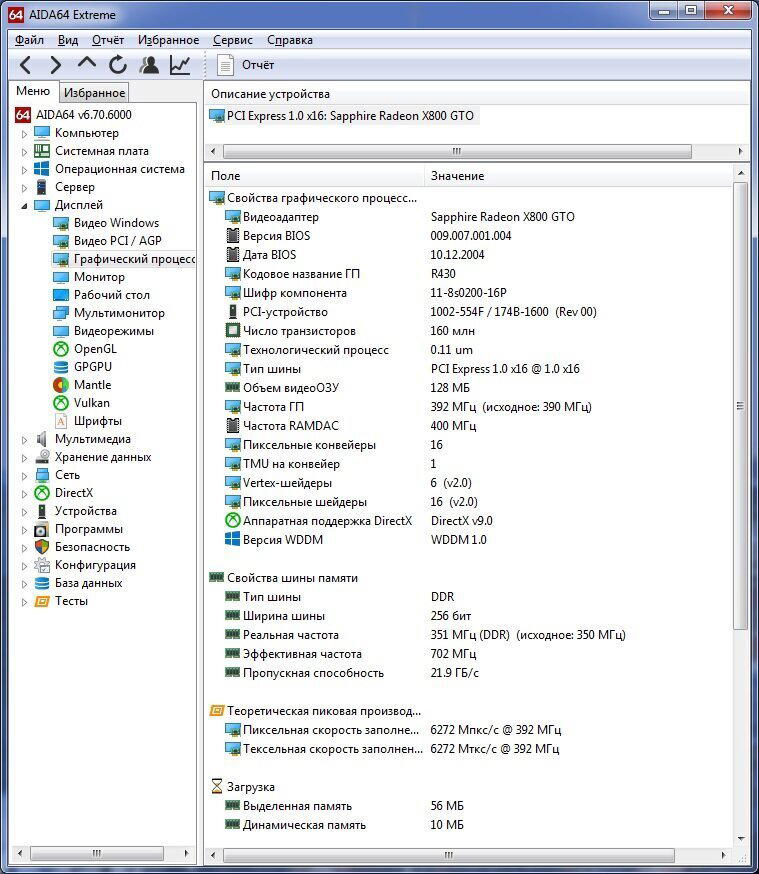

Подкрепляем все технические характеристики скриншотом из AIDA64.

Система охлаждения видеокарты состоит из большого медного радиатора с пластиковой накладкой для создания воздуховода. Воздух прогоняется через ребра радиатора, которые скрыты от глаз наклейкой на пластиковом кожухе. Вентилятор 3Pin и регулируется по температуре видеочипа. Датчик температуры находится внутри графического чипа. Из-за схожести с турбинной системой охлаждения она имеет недостаток в виде собирающегося «валенка» пыли перед радиатором полностью перекрывая прохождение воздуха.

Обслуженная видеокарта в играх не набирает больше 54 градусов, шум вентилятора при этом невысок.

Интересное наблюдение.

Я не смог запустить графические тесты 3DMark любой серии вместе с мониторингом температуры, они просто зависали, как только начинались тесты. Без мониторинга температуры тесты проходили без зависаний. Однако если запустить мониторинг, в какой-нибудь игре (в моем случае это был S.T.A.L.K.E.R) то таких проблем не наблюдается.

Переходим к графическим тестам

Тестовая платформа осталась неизменной: Intel Core 2 Quad Q9550, DDRII – 8Gb, Windows 7 x64. Пресеты настроек бенчмарков: по умолчанию, разрешение 1024х768х32.

Первым у нас идет 3DMark 2001. Опять же его запуск был только ради традиции. В нем мы выбиваем невероятные 23043 попугая. Хочу напомнить, что HD3870 выбивала 33963, правда она тестировалась с i5.

Для чего я упомянул HD3870? Просто показать разницу в производительности между ними в старых играх. Дальнейшее сравнение будет бесполезным.

А вообще x800 GTO является аналогом nVidia GeForce 6800, однако учитывая, что и «зеленые» и «красные» любили выпускать под одной серией карты с разными чипами и типами памяти проще будет сравнить всю линейку x800 со всей линейкой 6600, не вдаваясь в мелкие расхождения в разных моделях. Увы под рукой не осталось ни одной живой карты 6 серии GeForce.

Идем далее. 3DMark 2003. Немного немало 11358 попугаев. Недурно. Такие игры как Half-Life 2, DOOM3, F.E.A.R и S.T.A.L.K.E.R порадуют производительностью и качеством графики. Правда с разрешением 1024х768. И с Q9550.

Идем дальше. 3DMark 2005 нам показывает результат в 4720 попугаев. Если мне не изменяет память, моя 6600GT показывала похожий результат, только не помню какой у меня тогда был процессор.

Запуск 3DMark 2006 я считал глупой шуткой, как и с Radeon x600, но результат меня удивил. Да бенчмарк пропустил тесты связанные с Shader Model 3 так как карта их не поддерживает, но тем не менее мы набрали 1195 попугая.

Вообще отсутствие Shader Model 3 большая беда данной видеокарты. На ней невозможно запустить Mafia 2, COD 4 MW и многие другие игры, которые скорее всего, она без проблем «потянула». Но увы и ах. Shader Model 3 появились только в моделях x1xxx, помню, специально себе покупал x1250, чтобы пройти COD 4 MW 2. Однако у серии x1xxx есть другая проблема, которая на моей памяти проявляется в игре Mafia 2, однако это уже будет в другой статье.

Забыл сказать еще об одном нюансе связанный с этой видеокартой и видеокартой X600.

Был определенный момент в моей жизни, когда я поставил себе Radeon x800 GTO в личный компьютер. Ввиду того что у меня не нашлось свободного переходника DVI>VGA я взял цифровой переходник DVI>VGA (как на картинке).

Какое же у меня было недоумение, когда при нагрузке на монитор (быстрая динамическая картинка) он начинал моргать, периодически выкидывая табличку «Нет Сигнала». Проблема оказалась в слабом питании на разъеме DVI, соответственно использовать такие переходники на данных видеокартах нормально не получится (да и зачем).

Моя статья подошла к концу.

Спасибо вам за внимание и до новых встреч.

Если вам было интересно вы так же можете почитать другие статьи о видеокартах, подборка откроется по этой ссылке.

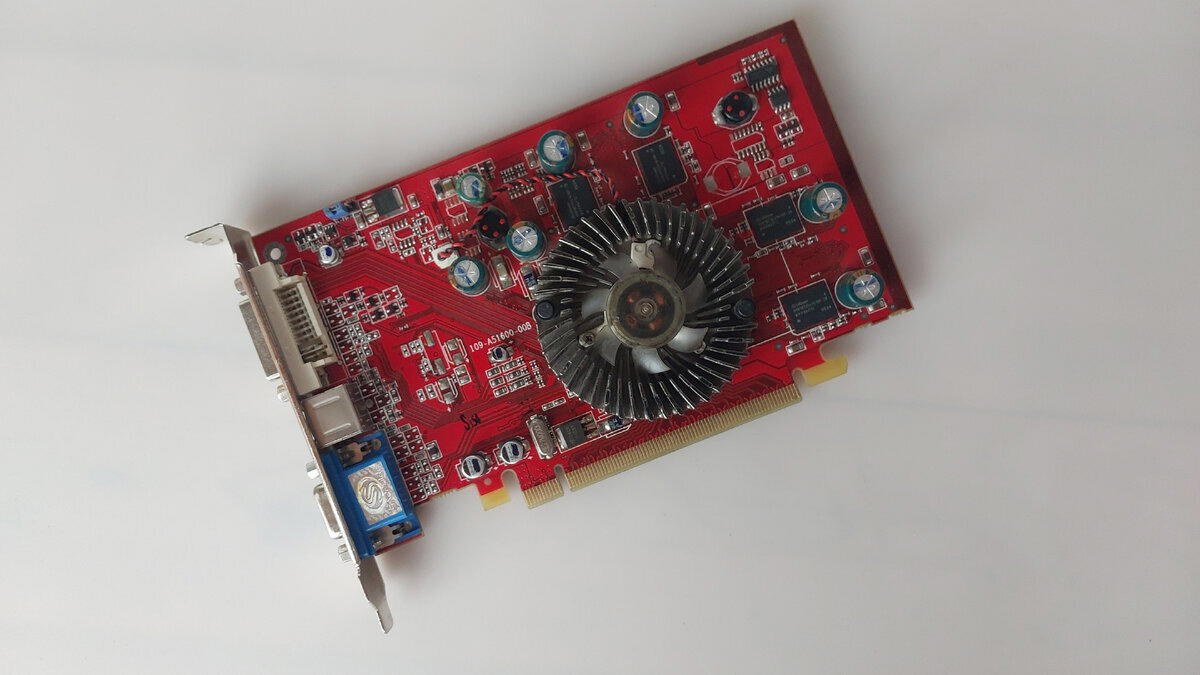

Рад вас приветствовать на моей очередной статье про видеокарты.

Как я и обещал в статье про системный блок AMD Athlon64 3500+(К сожалению, статья временно недоступна для пользователей Pikabu из-за кривого копирования, скоро все исправлю и выложу снова) сегодня у нас в гостях ATI Radeon X600Pro на 256 мегабайт от вендора Sapphire.

В самой системе видеокарта определяется как Radeon x550\x600.

Сама видеокарта выглядит простенько, видна ее бюджетность. Однако при написании статьи пришлось долго читать и готовить материал. Ведь тупо написать что «я считаю, что это тоже самое что Radeon 9600» будет неправильно, не от души.

Вообще из предыдущих моих статьей можно давно сделать вывод, что компания ATI выпускала с каждый разом старый продукт под видом нового, я не буду здесь конкретно повторятся про какие видеокарты идет речь, но я оставлю ссылки на эти статьи для прочтения.

Итак, что же есть Radeon x600Pro? По описанию большинства сайтов обзорщиков она имеет схожие характеристики с x550 и x300.

У нас получается следующая карта развития.

Radeon 9550(RV350)<Radeon9600(RV350)>Radeon x300\x550\x600(RV370)

Чип RV370 хоть и является новым, но по факту это тот же RV350 с нативной поддержкой PCI-E.

Первое время Radeon x600Pro базировались на чипах RV380, которые повторяли чип RV360 от видеокарт 9600 XT, но это продолжалось недолго, и позднее x600Pro собиралась только на чипах RV370.

Интересный факт

А вы знали, что видеокарты Radeon x300\x550\x600 не существовали под разъем AGP. Как минимум первое упоминание X серии в AGP идет x800, которая создана на RV420 чипе. А видеокарта x700 на AGP являлась неофициальной.

Вообще это было достаточно интересное время, переход с AGP на PCI-E. Началось все это в 2004 году. Мы с вами поговорим не про сам переход на PCI-E шину видеокарт, а то какими техническими решениями пользовались компании, чтобы продолжать выпуск новых видеокарт под еще актуальную шину AGP. Компания nVidia создала так называемый чип переходник HIS, который, кстати, работал в обе стороны. Благодаря его двухсторонней работе была придумана плата переходник AGP>PCI-E, позволявшая устанавливать видеокарты AGP в PCI-E шину. Но работала эта плата только с nVidia, и то не со всеми. Вопрос лишь был ли смысл делать эту плату переходник, когда видеокарты серии GeForce4 MX и GeForce FX официально вышли на PCI-E.

У ATI был свой вариант переходника, который именовался Rialto. Он был односторонним. Выпуск Radeon x700 на AGP шину был только благодаря этому переходнику. Однако видеокарты x800 и x850, которые были официально на AGP, чипа переходника не имели. У них была нативная поддержка AGP шины.

У nVidia тоже были видеокарты 6 серии с нативной поддержкой поддержкой AGP (хотя есть подозрение что его упаковали в графический чип), это были nVidia GeForce 6200 (NV44) и nVidia GeForce 6800 (NV40)(Описаны общие модели).

Что-то мы отвлеклись. Что у нас там дальше? Наклейка с характеристиками.

По видеовыходам видеокарта привычные нам: VGA(D-Sub), DVI и S-Video с возможностью вывода компонентного и композитного сигнала.

На разъеме VGA есть голографическая наклейка с названием вендора Sapphire

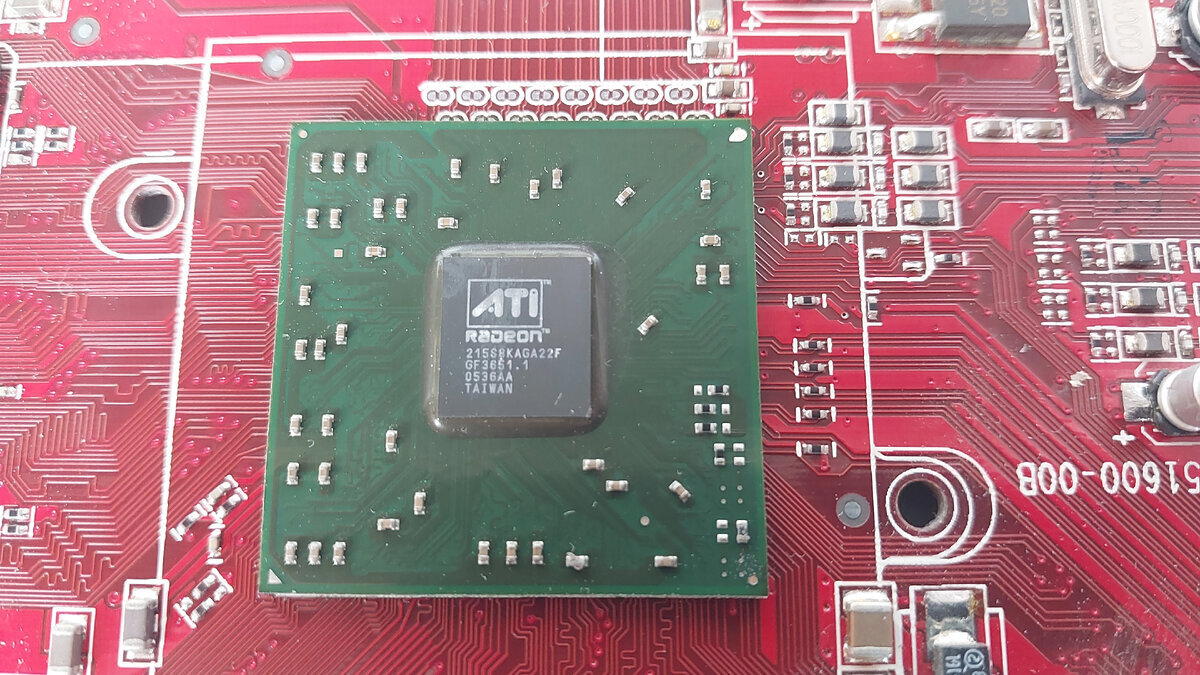

Плавно переходим к техническим характеристикам. Наша видеокарта основана на чипе RV380, что скорее всего даст возможность разгона до x600 XT.

Частота графического чипа 398МГц, присутствует поддержка DirectX 9.0, Shader Model 2.0, 4 пиксельных шейдера и 2 Vertex шейдера. Шина PCI-E x16 1.0.

Оперативной памяти у нас 256 мегабайт, набрана 8 чипами по 32 мегабайта производства Infineion. Тип памяти GDDR2 в упаковке BGA. Частота памяти 500МГц. Ширина шины памяти 128 бит.

Судя по DataSheet на чипы памяти, их максимальная частота составляет 700МГц. Значит, у этой карты есть неплохой разгонный потенциал.

Пора переходить к графическим тестам.

Тестовая платформа, на которой производилось тестирование: Intel Core 2 Quad Q9550, DDRII – 8Gb, Windows 7 x64. Пресеты настроек бенчмарков: по умолчанию, разрешение 1024х768х32.

Первым у нас идет 3DMark 2001. Там карта выбивает 9955 попугаев.

Потом обязательно сравним с Radeon 9600.

Далее у нас 3DMark 2003. Кстати у меня у единственного первый тест с самолетами вызывает желание поиграть в ИЛ2 Штурмовик? В 3DMark 2003 выбивает 3249 попугая.

Оценка 3DMark 2005 меня немного удивила. Более того видеокарта достаточно неплохо тянет S.T.A.L.K.E.R. В 3DMark 2005 набирает 1731 попугай.

3DMark 2006 был запущен больше ради интереса. Пресет настроек был снижен до 1024х768. В нем получилось 596 попугай.

Ну и в конце по традиции скрин из AIDA64

Windows 7 дает этой видеокарте оценку 3.7.

Видеокарты серии x300\x550\x600\x700\x800\x850 вообще мне не попадались во время моей юности. Первая видеокарта серии x которую я купил, была X1350 AGP на которой я прошел Call Of Duty MW2. Поэтому в этой статье не было никаких воспоминаний. Впервые подобные карты стали попадать ко мне в руки в году 2015 года пошло массовое списание старых офисных компьютеров с моей первой обслуживаемой конторы. В основном это были системники на Intel 915 и Intel 945 чипсетах без встроенной видеокарты с такими «затычками».

Из за низких частот работа видеокарт типа x300 под Windows 7 с включенным Aero вызывало торможение интерфейса, разрыв картинки при прокрутке Word или какого либо сайта. X600 в этом плане ведет себя конечно получше, но все равно она для меня так и остается «затычкой»

На этой ноте моя статья подходит к концу.

Надеюсь, вам понравилось. Спасибо за внимание и до новых встреч.

Приветствую дорогие подписчики.

Уточнение в заголовке, что речь пойдет о видеокарте с разъемом PCI-E x16 не просто так. Такая видеокарта существовала в варианте AGP, но найти такую вариант призрачный.

Так же хочу сделать уточнение про «Молодость», мои статьи читают люди разных возрастов, и для кого-то S3Trio является детством\юностью, а для кого-то GeForce 8800GTX. Поэтому данных заголовок всего лишь является просто визитной карточкой моих статей, хотя возможно кто-то и начнет перенимать мой стиль (да хотя кто я такой))).

Вернемся к теме статьи. Сегодня у нас в гостях «горячий» представитель «красных» ATI Radeon HD3870 PCI-E x16 на целых 512Mb.

Как красочно выглядели видеокарты того периода, практически на всех топовых и предтоповых были игровые наклейки с серией видеокарты.

Перед нами референсная видеокарта. Ее длинна составляет 22 сантиметра (2.2 дециметра, помните еще такое значение?) и занимает сразу два слота в корпусе.

На обратной части нас не ждет не чего необычного. В данных картах еще не использовался бекплейт и, кстати, они не страдали прогибом. Возможно из-за идеальной развесовки.

В свете солнечной погоды видеокарта выглядит сочно красной.

На обратной стороне карты нас встречает наклейка со спецификациями видеокарты.

Тут мы можем увидеть серию видеокарты, объем памяти, тип памяти, тип разъема и какие разъемы для вывода изображения.

Данная видеокарта достаточно мощная для своего времени (но мне кажется не сильно мощнее HD2900) и у нее предусмотрен один разъем питания 6Pin. Видеокарта требует минимального блока питания на 450W, вероятно не китайского производства.

По традиции снова погрузимся в воспоминания.

Это уже была даже не юность, мне было 25 лет. Мне перепало сразу две видеокарты от Sapphire. Это были HD2900 на 512Mb и вот эта HD3870 на 512Mb. Обе были рабочие. Оба этих кирпича я держал в руках впервые и начал свои эксперименты с HD2900. Шум турбины у нее конечно славный, цифры температурных датчиков тоже пугали, но для нее это было нормой. Тогда я еще был сильно увлечен игрой в PB (Point Blank) и я решил в первую очередь посмотреть на эту игру на максимальных настройках. Картинка меня тогда сильно поразила, на картах с динозавром появилось очень много растительности (которая мешала видеть людей, которые спасаются), плавность картинки и цветовая гамма, в общем, впечатления приятные. Далее я тестировал на Mafia 2 (GTA 5 кстати еще не вышла), где она меня тоже поразила своей мощностью. Турбина ревела, конечно, знатно. HD3870 после HD2900 показалась, какой-то пресной, менее горячей, более тихой и менее производительной в тех же самых играх. Возможно, вся сила заключена в ширине шины. HD2900 использовала память GDDR3 на 512 мегабайт с шириной шины 512 бит и частотой 2000 МГц, а HD3870 хоть и использует более свежую GDDR4 с частотой 2250 МГц, но имеет шину в 256 бит.

Увы, провести реальную битву с цифрами в 3D бенчмарках мы не сможем, HD2900 была мной продана в 2018 году.

Как я уже ранее сказал, видеокарта занимает два слота в корпусе компьютера, то есть имеет двухслотовую турбинную систему охлаждения с выбросом горячего воздуха за пределы корпуса. Тут же у нас располагаются два разъема DVI-I и S-Video с возможностью вывода компонентного и композитного сигнала.

Кстати на обратной стороне карточки так же есть маленькая наклейка с оповещением поддержки HDCP. Так же в комплекте с видеокартой шел переходник DVI-HDMI, видеокарта умеет передачу звука.

И снова вернемся немного в прошлое. Видеокарта HD2900 тоже умела передачу звука по HDMI через переходник DVI-HDMI, но только через один разъем который был подкрашен желтым цветом. На HD3870 вывод звука возможен с любого из DVI. Хотя возможно моя память немного искажена и я путаю с другой видеокартой так как я не нашел в интернете фотографии которые могут подтвердить мое высказывание.

К слову аналог HD3870 у «зеленых» - это GeForce 8800, которая, хоть и тоже умела передачу звука по таким переходникам, но требовала подключения к разъему SPDIF на материнской плате. Без этого шнурка звук из GeForce стало возможно получать только с серии GT 2xx, и то не со всех (к примеру, GT 210 имела звуковой кодек в чипе, а GTX 260 нет).

Все же помнят, что аббревиатура GTX на русской раскладке пишется как ПЕЧ. А ATI Radeon называли Утюгами. Спустя 15-20 минут игры видеокарту можно было вытащить и погладить рубашку, правда это все-таки больше касается HD2900, чем HD3870.

Компания ATI провела очень хорошую работу со снижением тепловыделения и электропотребления чипа RV670. Об этом свидетельствует выпуск видеокарт HD3870 с однослотовом варианте, в варианте AGP и даже в варианте HD3870 x2 (два видеочипа на одной плате, грубо говоря, две видеокарты в одной объединенные по технологии CrossFire).

На нашей видеокарте так же есть наклейка, предупреждающая, что радиатор сильно нагревается, но хорошо обслуженная видеокарта не набирает больше 70 градусов. HD 2900 такие показатели могут только снится.

К слову 8800GTX тоже можно добиться низких показателей температур. Но кроме хорошего обслуживания ей надо немного изменить график оборотов вентилятора, да карта станет шумнее, но продолжительность жизни вырастет. Благодаря этим изменениям я скоро выпущу статью про 8800GTX 768Мб, которую ни разу не касался отвал.

Система охлаждения состоит из нескольких элементов. Кожух с вентилятором и медным радиатором, крашенная алюминиевая пластина охлаждения чипов памяти, крашенная алюминиевая пластина охлаждения фаз питания.

Как я уже ранее говорил система охлаждения турбинного типа, в меру шумная, но по мере засорения видеокарты она начнет очень сильно выть. В стандартной прошивке прописаны максимальные обороты вентилятора при достижении 80 градусов.

Пора переходить к техническим характеристикам

На борту у нас графический процессор RV670 XT с частотой 777 МГц по заводу, но в момент корректировки графика работы вентилятора (на заводской прошивке график сделан, так что в температуре покоя обороты вентилятора скачут, что очень раздражает, график был смещен на 5 градусов и чуть были подняты обороты), я прописал частоту в 750 МГц. Благодаря этому видеокарта до сих пор живая и не сильно греется.

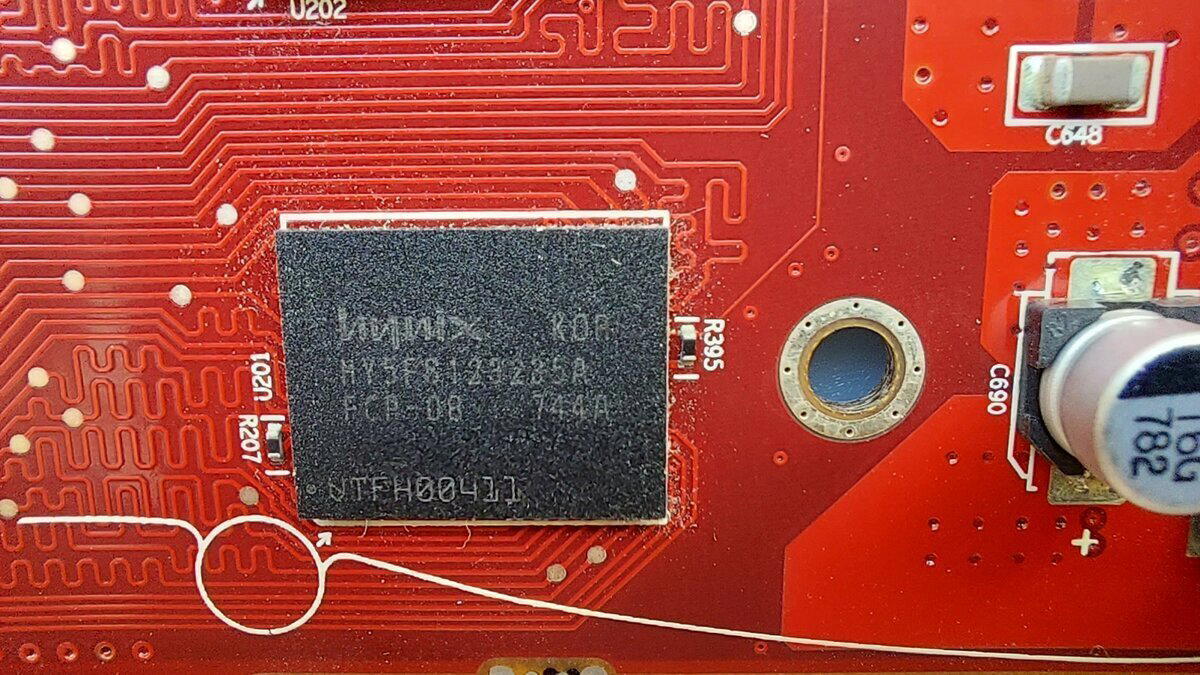

Оперативная память у нас типа GDDR4 производства Hynix. Объем 512 мегабайт, набранный 8 микросхемами по 64 мегабайта. Ширина шины 256 Бит, частота памяти 2250 МГц.

Память охлаждается крашенным алюминиевым радиатором через термопрокладки.

Как было сказано у видеокарты разъем PCI-E 2.0 x16, присутствует аппаратная поддержка DirectX 10.1, OpenGL 3.x, есть поддержка CrossFire, Число универсальных процессоров: 320, Число текстурных процессоров: 16 .

Пора переходить к графическим тестам. Сегодня у нас их 4 штуки.

Тестовая платформа, на которой производилось тестирование: Intel Core i5-2400, DDRIII – 16Gb, Windows 7 x64. Пресеты настроек бенчмарков: по умолчанию, разрешение 1024х768х32.

И первым в нашем списке традиционно 3DMark 2001. Большинство из тестов показывали более 600 FPS. Тут мы выбиваем 33963 попугая.

Понимаю что 3DMark 2001 только пощекотит видеокарту не показав ее реальных возможностей.

Поэтому следом мы запускаем 3DMark 2003. По каким-то невероятным причинам мы набираем 34915 попугаев, что почти на 1000 больше чем в 2001. Скорее всего эти причины заключаются в поддержке DirectX 9 бенчмарком.

3DMark 2003 тоже не может серьезно нагрузить видеокарту, поэтому запускаем 3DMark 2005

И вот тут уже в некоторых тестах конечная оценка будет зависеть еще от производительности процессора.

В 3DMark 2005 мы с вами набираем 16915 попугаев.

Забыл рассказать про комплект поставки видеокарты. Кроме переходников DVI-VGA и DVI-HDMI в комплекте с картой есть композитный S-Video кабель, переходник питания Molex>6Pin, наклейка на корпус, инструкция, диск с Half-Life Episode One и диск с 3Dmark 2006. Вот его мы и запустим.

Сам 3Dmark 2006 в отличии от других запускался с другими настройками, это единственный бенчмарк с разрешением 1280х1024х32 по умолчанию. В нем мы набираем 11135 попугаев.

За все время тестирования бенчмарками видеокарта не набрала более 67 градусов.

Добавить про видеокарту в целом больше не чего, единственное у вас, наверное, возникнет вопрос, почему произошел такой резкий скачок со старых AGP видеокарт к более современным PCI-E да еще и к такой. Отвечаю, данная видеокарта скоро отправляется своему новому владельцу, который попросил ее показать со всех сторон и выслать результаты тестов. Вот я и подумал, что пока моя память и фото свежи лучше написать сейчас, чем потом сидеть и не понимать что происходит.

Спасибо вам за внимание, надеюсь, вам понравилась данная статья. По просьбам комментаторов я, кстати, немного изменил оформление статьи. Были жалобы, что я неправильно размещаю фотографии и описание к ним. Сейчас должно быть лучше.

До скорых встреч.

Если вам было интересно вы так же можете почитать другие статьи о видеокартах, подборка откроется по этой ссылке.

Под спойлером не является чем то обязательным.

Так же при желании вы можете поддержать мое творчество и отправить донаты по этой ссылке. Донаты принимаются от 2 рублей. Так же подключена монетизация и от самого Pikabu.

Всем привет друзья.

Это будет очень длинная статья, запасайтесь чем-нибудь вкусным и мы начинаем.

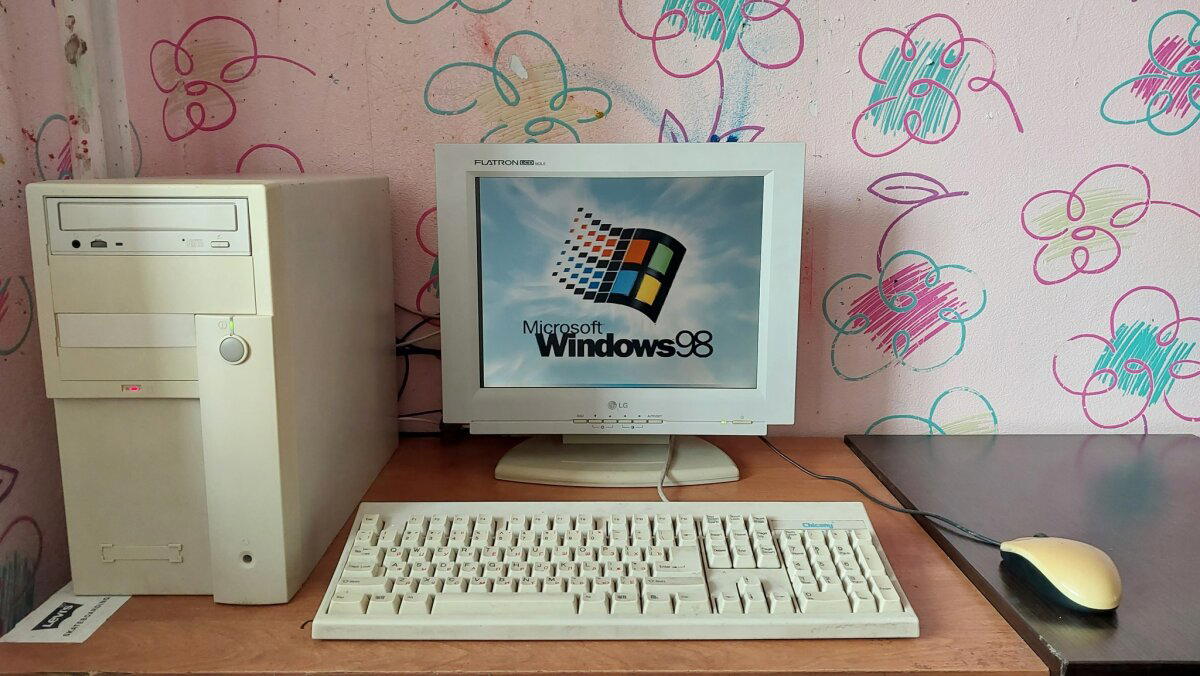

Сразу хочется окунуться в свои воспоминания. Мой первый компьютер у меня появился в году так 1996-1997, не помню точно. Помню, только что это был 286 и на этом все. Из игр там был любимый F-19 (до сих пор руки помнят, как играть), Поле чудес с Якубовичем, Цветные линии, ShortLine, SupaPlex и Sea War. Что с ним стало потом, я уже не помню, на его замену пришел моноблок Compaq на 486 процессоре, там список игр был больше.

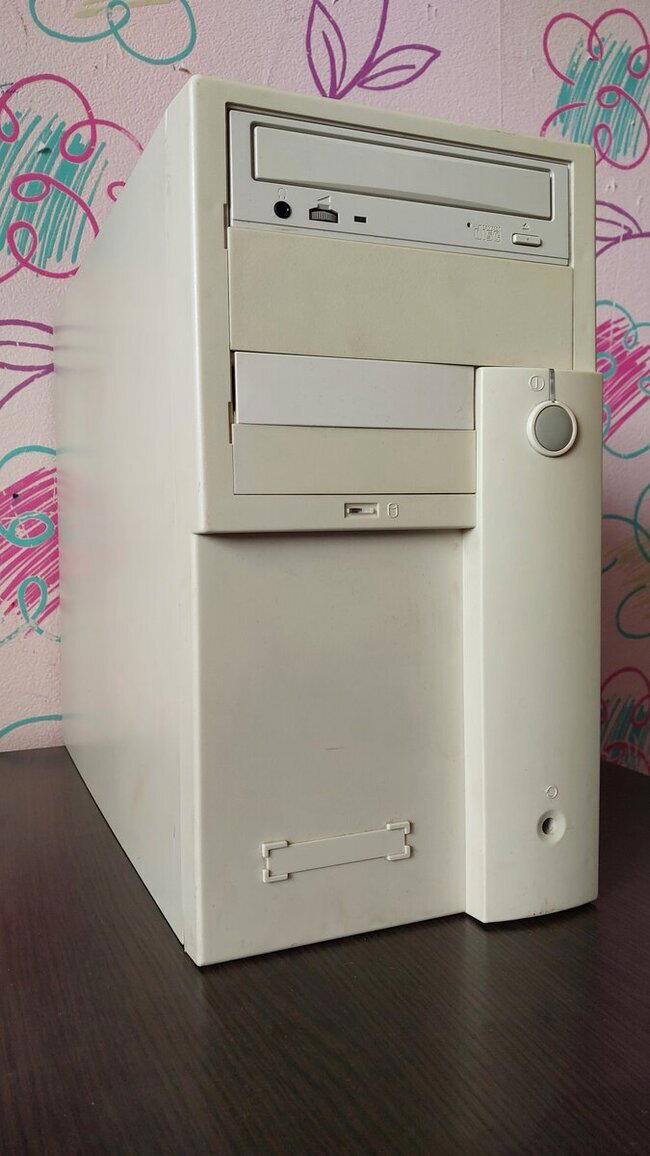

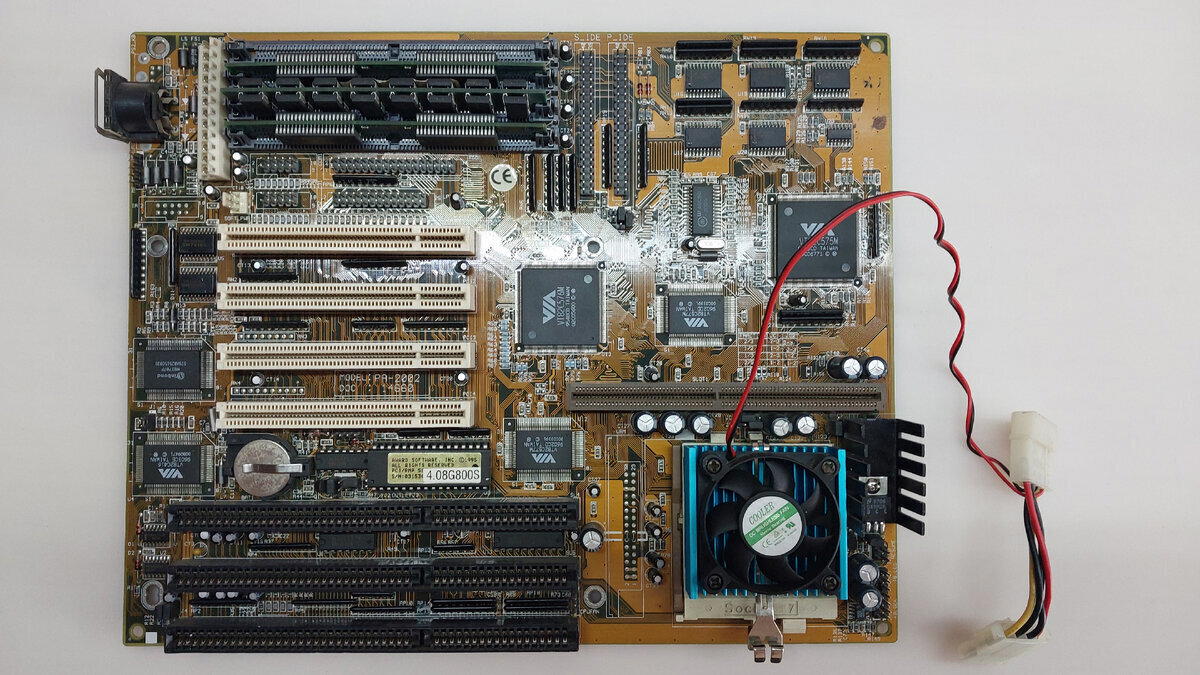

Наш гость сегодня на 70% собран из деталей 1996-1997 года. Судя по некоторым гарантийным пломбам, он до меня добрался почти в полном составе с момента сборки.

Данный компьютер относится к форм-фактору AT. Корпуса в то время отличались в основном только передней декоративной панелью, либо расположением на столе (стоя\лежа). Так же стандарт AT предусматривал разъем DIN-5 для клавиатуры и механическую кнопку включения\выключения компьютера. Именно поэтому мы видим знаменитую надпись «Теперь питания компьютера можно отключить»

Задняя панель богата на разъемы. На моей памяти я не помню такого оснащения у своего компьютера или компьютера знакомых. У нас тут имеется COM9, COM25, LPT, PS\2 для мышки. Остальные разъемы мы рассмотрим чуть позднее, когда заглянет внутрь.

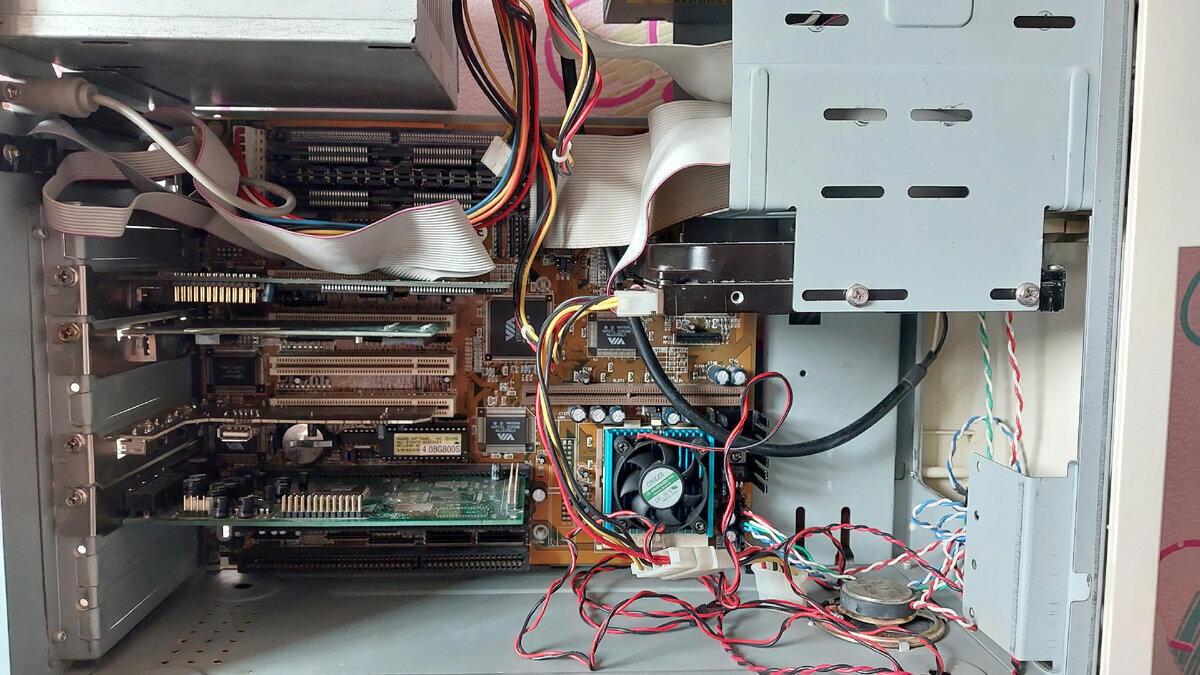

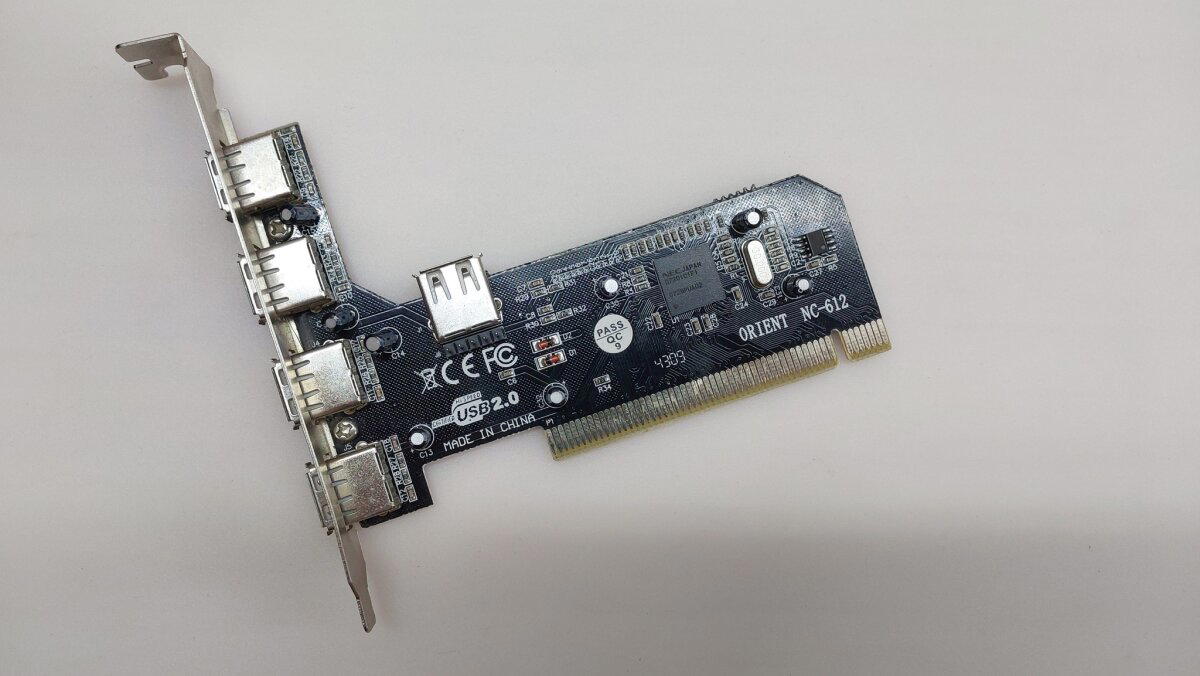

А вот и внутренности. Выглядит классически для того времени. Единственное что выбивается из общей картины это USB контроллер и отсутствие Floppy дисковода.

Материнская плата форм-фактора Baby-AT. На плате установлен Socket 7, имеется 4 слота оперативной памяти типа SIMM на 72 контакта, 4 разъема PCI и 3 разъема ISA. Так же имеется 2 разъема IDE, FDD, 2 разъема COM, LPT, PS\2. Рядом с процессором находится слот для КЭШа второго уровня. Питание платы обеспечивают разъемы AT P8 & P9. Разъем DIN-5 предназначен для подключения клавиатуры.

Все 4 микросхемы VIA взаимосвязаны и описаны в общей документации как VIA Apollo Master.

Тут мы приостановим нон-стоп из фотографии. Дело в том, что для Intel Pentium требуется установка пары плашек памяти SIMM для работы в 64 битном режиме. Однако в нашем случае стоит чипсет VIA Apollo Master, который позволяет работать нечетному количеству планок. Если обратится к официальной документации, то там в описании к контроллеру памяти есть пункт, где указано возможность работы в 64 и 32 битном режиме памяти.

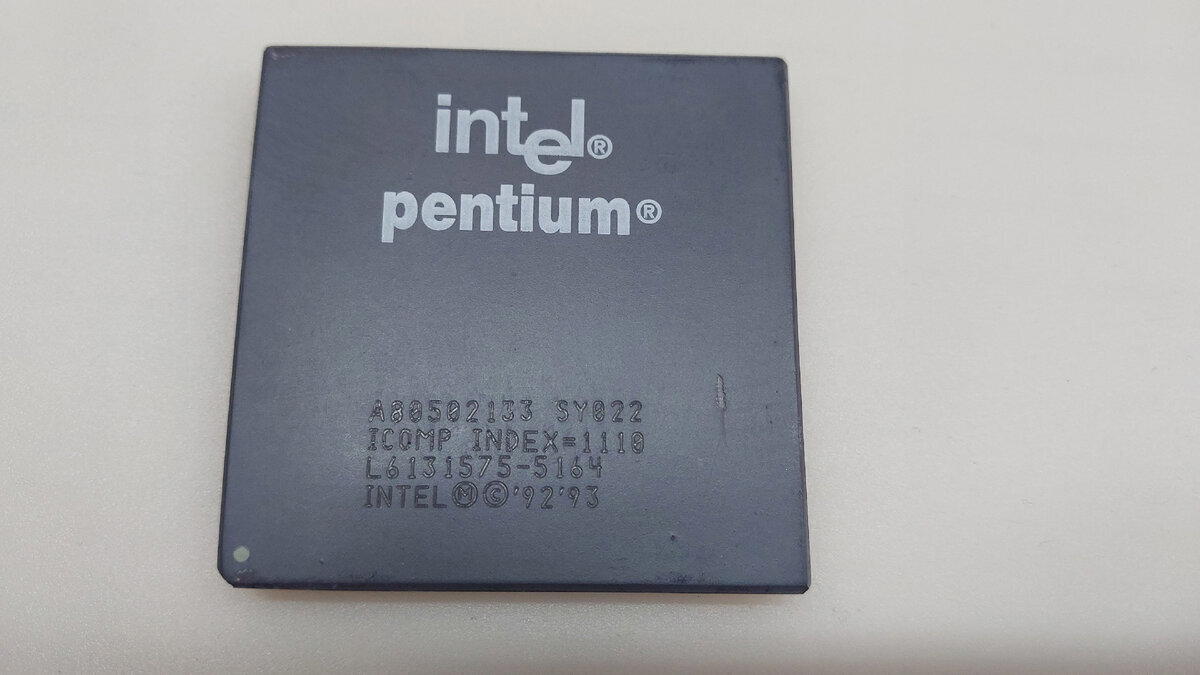

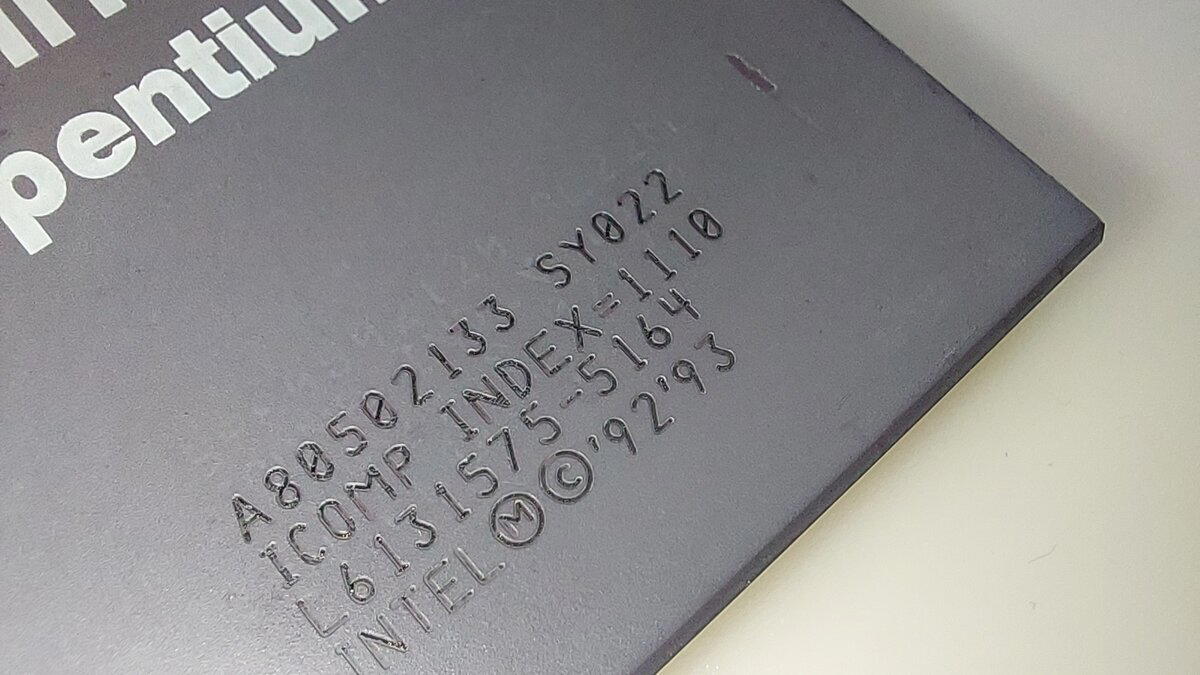

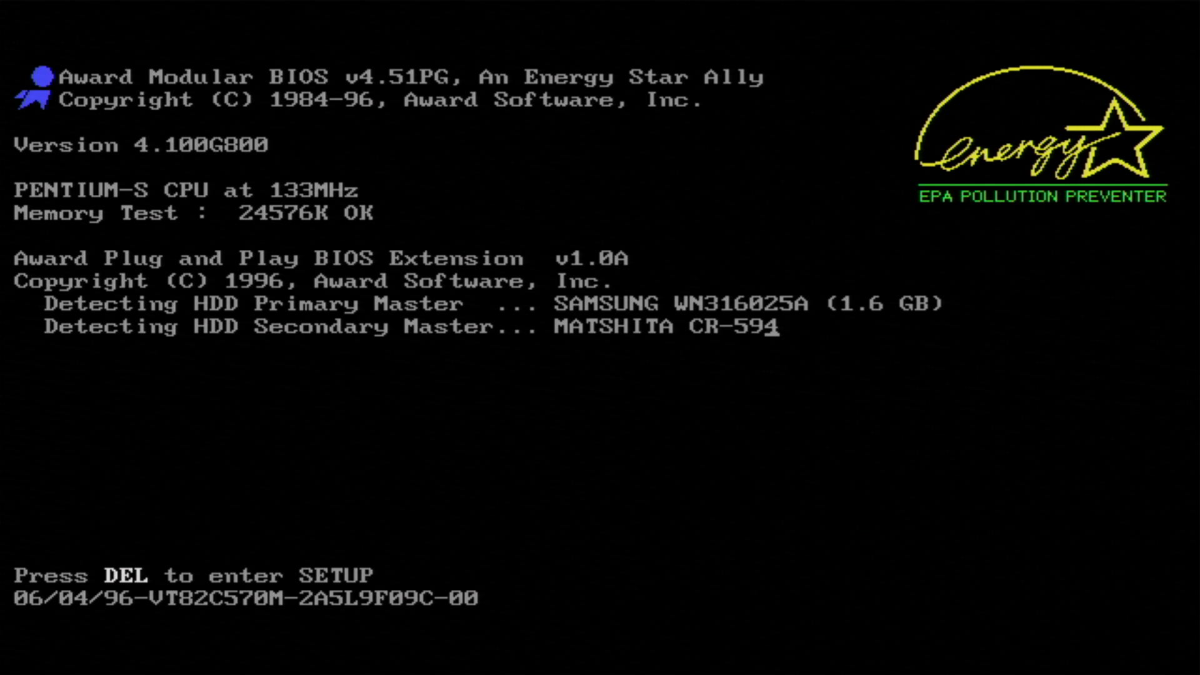

Процессор Intel® Pentium® 133MHz. По гарантийной наклейке можно судить о ноябре 1996 года.

Когда я фотографировал процессор, я заметил под углом двойную маркировку. Старая маркировка соответствует процессору Intel Pentium 120MHz. На "пузе" процессора следов двойной маркировки не обнаружено.

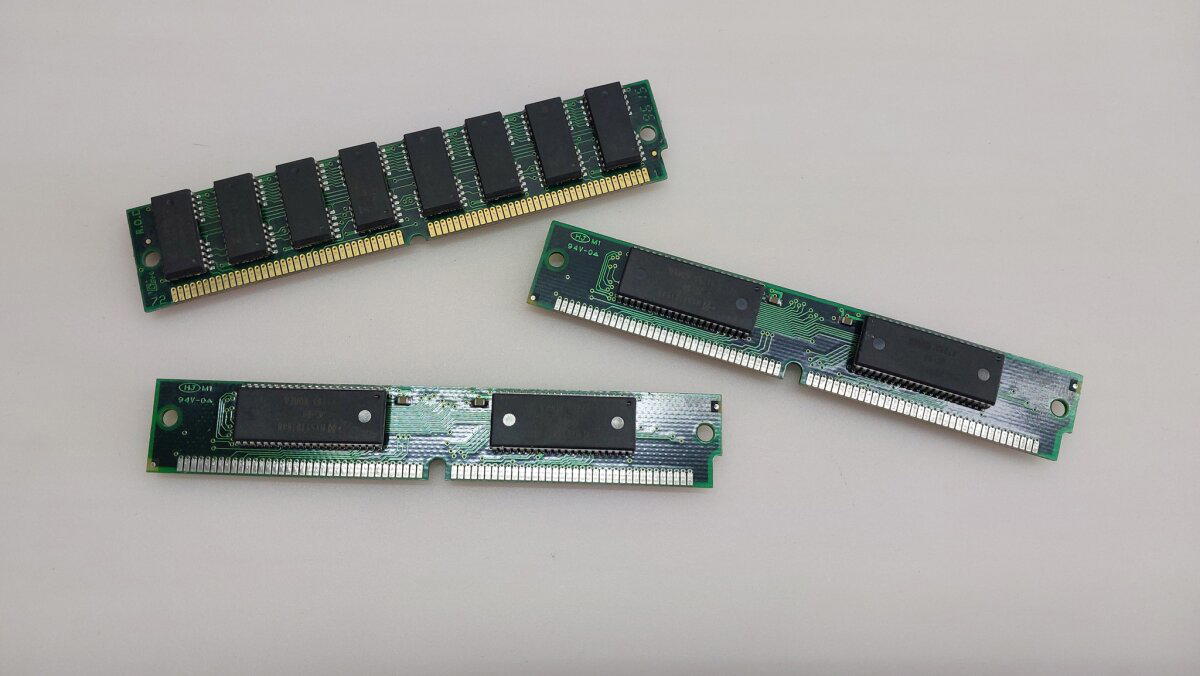

Планки оперативной памяти SIMM. 3 планки по 8 Мегабайт.

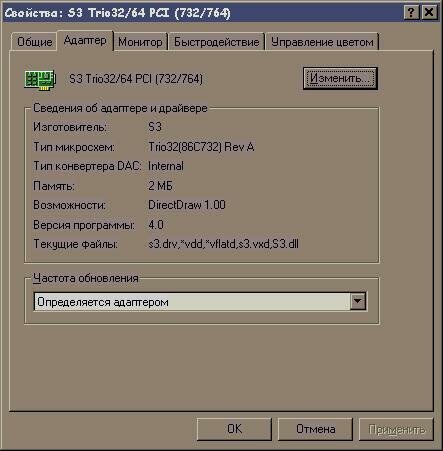

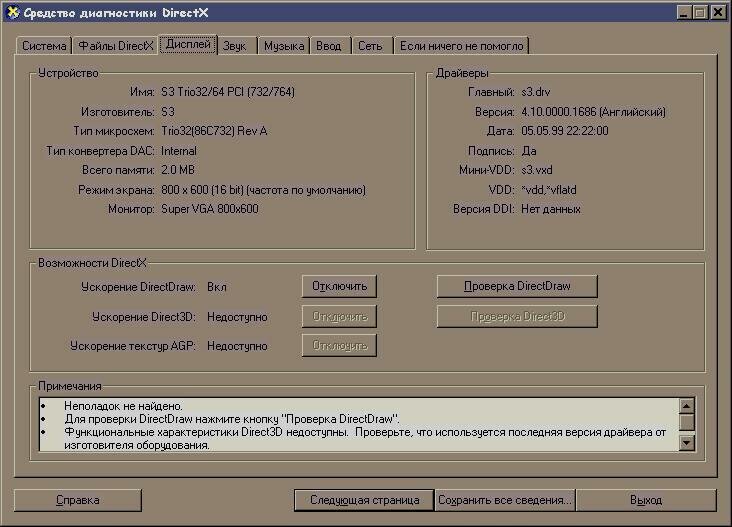

О данной видеокарте мы писали статью. Если вы хотите знать о ней побольше переходите по этой ссылке.

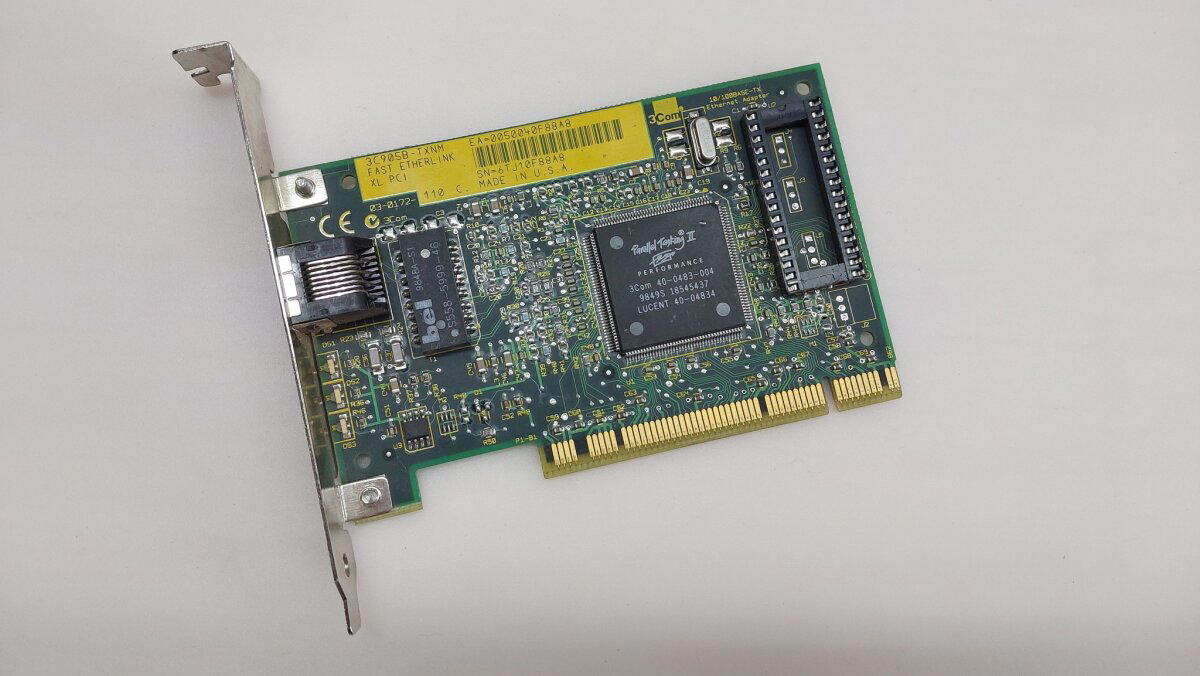

Хотел бы сделать небольшое отступление, связанное с сетевыми картами. В наше время это уже давно не важно, но раньше… Сетевые карты (как и модемы) делятся на два типа: Аппаратные и программные. Программные сетевые карты (по факту они называются сетевым адаптером) загружают процессор при обработке каких либо данных. Если для Core 2 Duo или AMD Athlon эта нагрузка не существенна, то для Pentium 3 скорость скачивания в 7 мегабит может полностью загрузить процессор. В аппаратных сетевых картах обработка данных происходит без участия процессора, поэтому при ее использовании на компьютер не накладывается дополнительная нагрузка. Именно сетевая карта 3Com 905B которая используется в этом компьютере аппаратная, следовательно, она не нагружает процессор при работе с сетью.

Звуковая карта ESS ES1868F имеет 16 битный разъем ISA. Данная звуковая карта могла идти с распаянным контроллером IDE, но не в нашем случае. На звуковой карте предустановлен усилитель TEA2025B.

Кстати данные звуковые карты с трудом, но можно запустить на Windows XP.

На наклейке накопителя можно увидеть дату май 1997 года. А что за дата указана маркером мне неизвестно. По данному диску я написал отдельную статью.

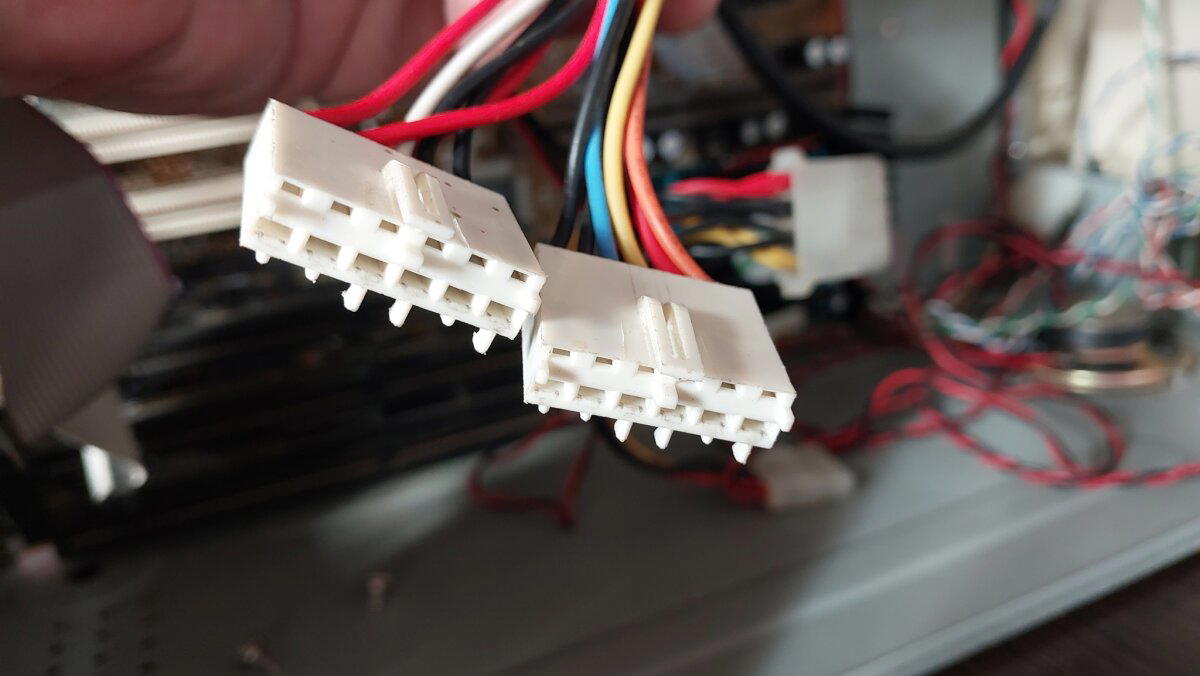

При подключении материнской платы к блоку питания разъемы можно легко перепутать и подключить неправильно. Я за всю свою практику запомнил одно, подключать эти разъемы черными проводами друг к другу.

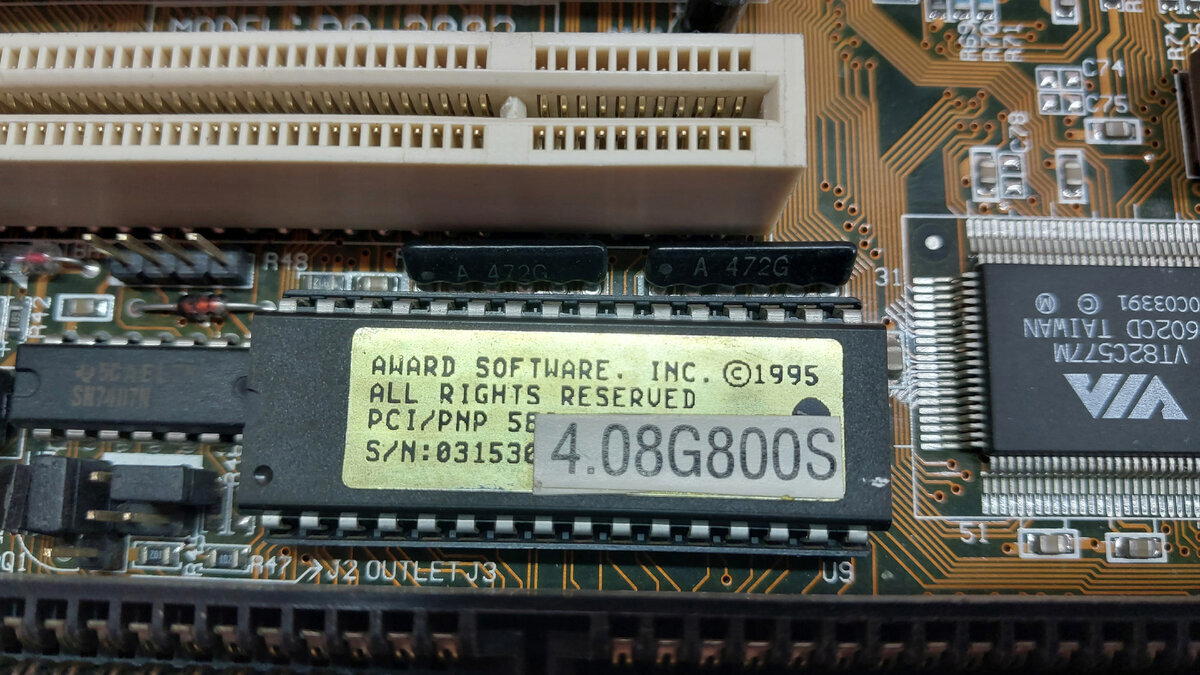

Как вы можете заметить, версия BIOS не соответствует той, что была указана на наклейке микросхемы BIOS. Все верно, BIOS на этой плате я обновлял, причем прошивал через программатор.

Начальный экран выглядит достаточно привычно для многих из вас. Пока не появились полноценные логотипы и загрузочные картинки (AsRock N68 передает привет), Award BIOS выглядел так много лет. Как вы можете заметить вместо 4 строчек опрашиваемых устройств, показывается всего две, другие каналы были отключены для более быстрой загрузки, но все равно компьютер загружает чуть больше 3 минут.

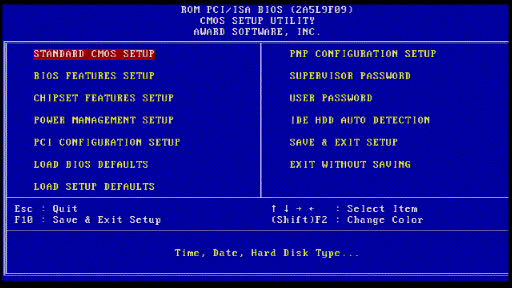

Сам BIOS выглядит классическим, два столбца с перечислением пунктов меню. До Pentium 4 Award BIOS имел несколько цветовых гамм которые переключаются комбинацией Shift+F2

Я записал ролик по запуску данного компьютера. На видео можно услышать с каким звуком работает жесткий диск, а так же услышать звук загрузки операционной системы.

Логотип загрузки Windows 98 по моему мнению самый красивый из всех.

Если честно, данной конфигурации мало для Windows 98. С момента нажатия на кнопку до полной прогрузки системы проходит чуть более трех минут. Хотя при этом мы даже вполне сносно можем посещать сайт OLD-DOS.ru с IE.

Компьютер я этот покупал для записей ретро игр для YouTube, но что-то пошло не так, канал не взлетел, и компьютер остался неудел. Когда я проводил предпродажную подготовку, были мысли установить Windows 95, но я понял, что это бы заняло еще около суток.

Я решил его полностью отснять для вас, поделиться какой либо информацией, которую вы не знали ну или просто вспомнить прошлое.

А на этой ноте я, пожалуй, закончу. Спасибо за внимание, особенно если осилили и дочитали до конца, хотя текста тут было не так много.

Обязательно будут еще статьи про компьютеры в сборе, но будет их не так много.

До новых встреч.

Приветствую дорогие господа и дамы.

По моим последним статьям уже можно составить статистику, по которой стало ясно, что ATI Radeon карты вызывает у вас наименьший интерес. Возможно, их использовали в играх намного меньше, а возможно их название просто не на слуху.

Ну да ладно, сегодня у нас все равно гость от nVidia и достаточно известный.

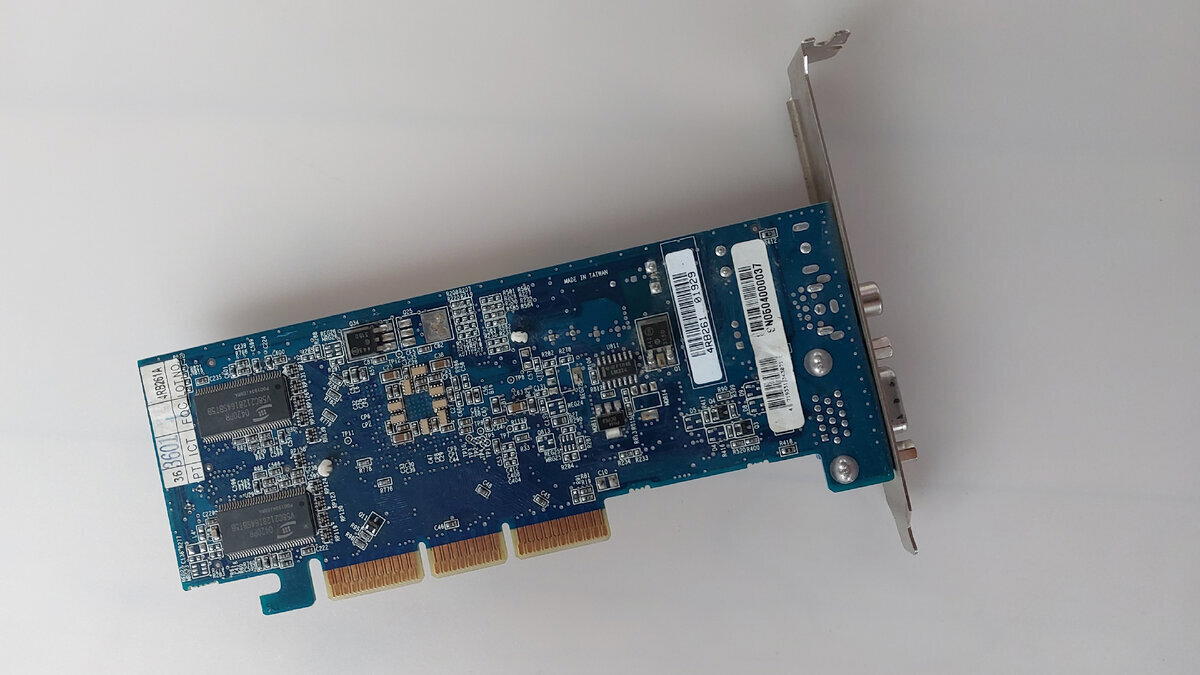

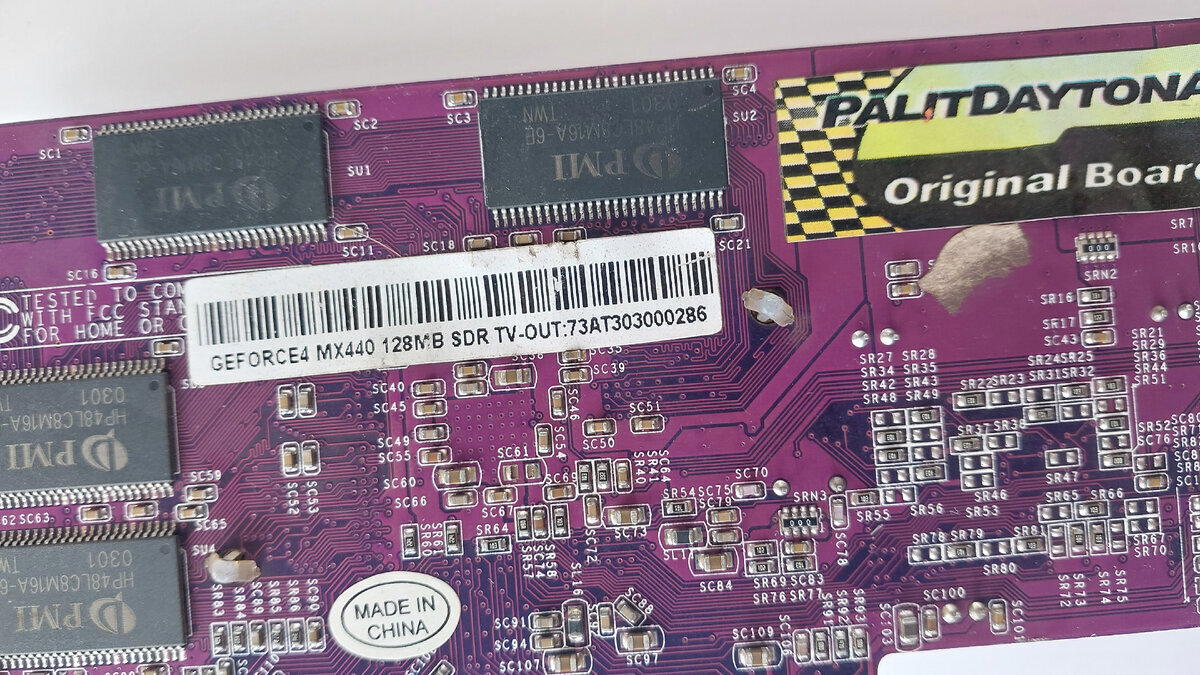

Производитель данной видеокарты Sparkle о чем нам уверенно сообщает наклейка со спецификацией и модель на PCB плате.

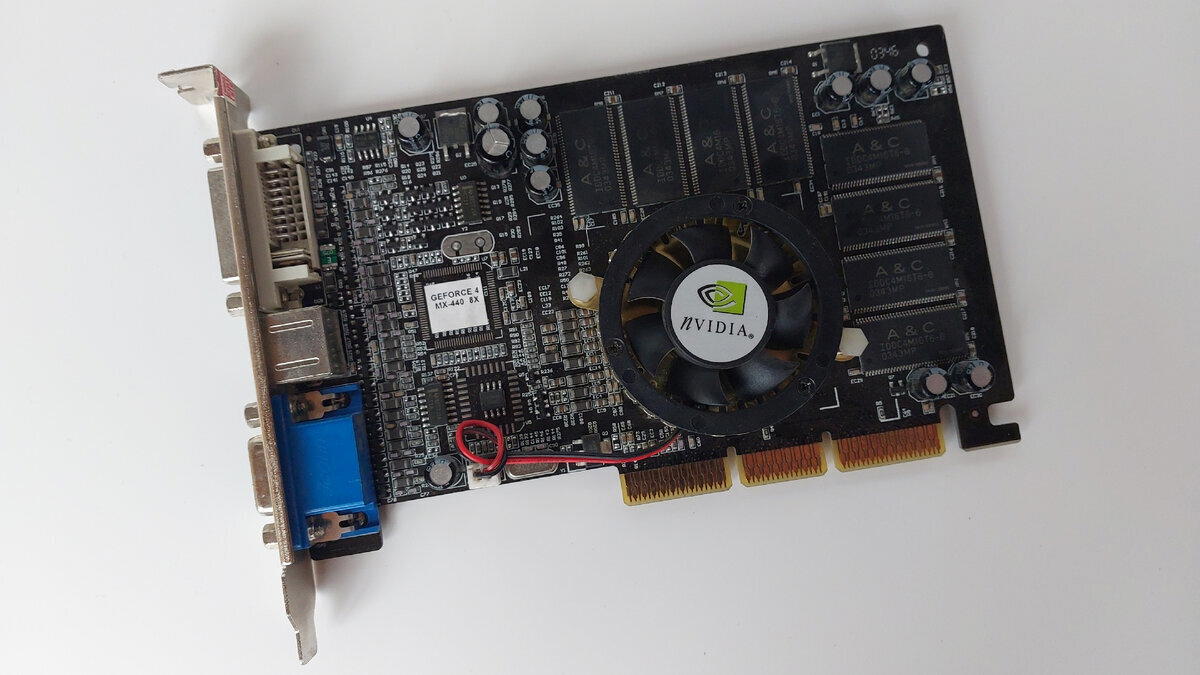

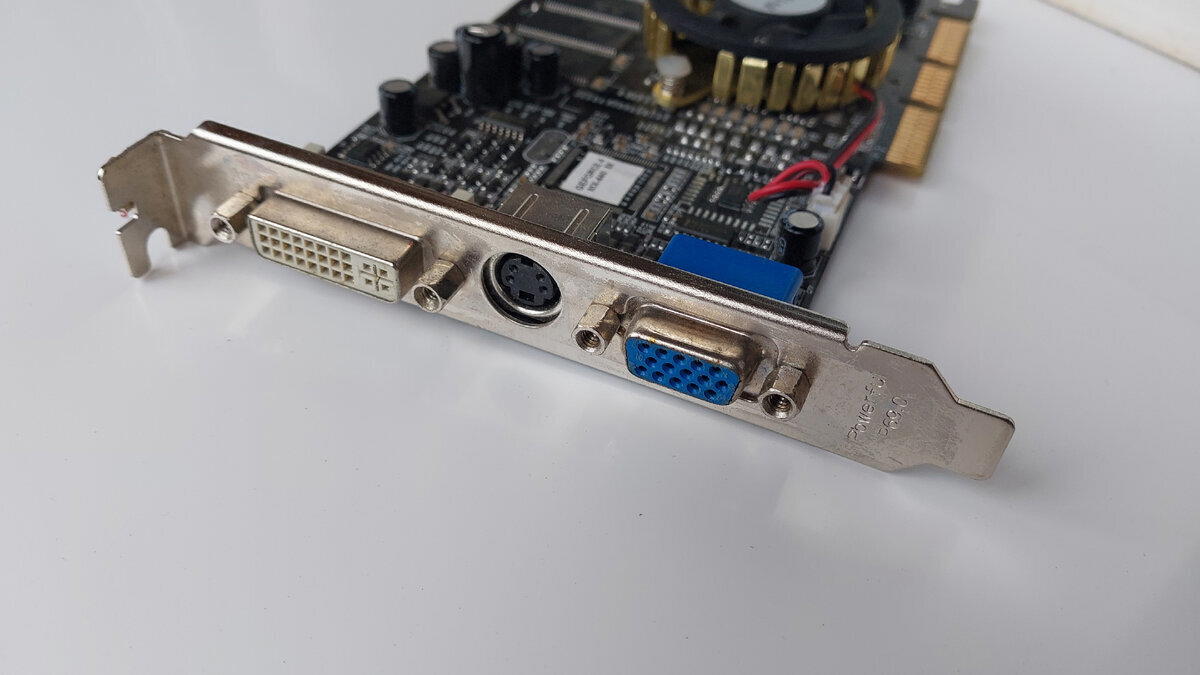

Видеокарта FX5200 относится к видеокартам начального уровня и должна была заменить видеокарты MX440.

По традиции история из моей юности.

Несмотря на то, что GeForce FX 5200 128Mb стоила дороже, чем MX440 на 128Mb и должна была заменить эту линейку карт, я очень сильно пожалел о данной модернизации. Я очень долго владел MX440, и меня удовлетворяла производительность моих любимых игры, это были такие игры как Half-Life, Half-Life 2, GTA Vice City, GTA San Andreas, Call Of Duty и Call Of Duty 2, а так же бесчисленное количество модов на выше перечисленные игры. Но мне не хватало качества картинки в той же Half-Life 2 и плюс хотелось попробовать такие игры как S.T.A.L.K.E.R и F.E.A.R. я принял решение сходить в любимую коммисионку и проконсультироваться с мастерами по этому поводу. Домой я уже возвращался с коробочкой FX5200 с активным охлаждением. Как я был сильно расстроен производительностью в моей любимой Half-Life 2, тормоза были даже на минимальных настройках графики. Тогда я даже не знал, что проблема была именно в DirectX 9 и игру надо запускать с командой –dx8. После того как я прошел интересующие меня игры я вернулся на MX440.

Рядом с наклеечкой со спецификацией есть гарантийная наклейка магазина Unit.

Из видеовыходов все стандартно на то время: D-Sub(VGA), DVI, S-Video.

Еще немного вернемся в мою юность.

Купленная FX5200 была в полной комплектации, в комплекте был переходник с S-Video на RCA, с помощью которого я подключил CRT телевизор, чтобы смотреть какие-нибудь фильмы на телевизоре. Помню еще был конверт с какой то игрой, но увы фотографии не нашел на своем компьютере.

Как я уже говорил ранее nVidia GeForce FX5200 это видеокарта начального уровня. Она основана на чипе NV34 и имеет частоту графического процессора в 250МГц.

Видеокарта поддерживает пиксель и Vertex шейдеры. Так же это первая на моей памяти видеокарта, поддерживающая 2D и 3D профили. При грамотном подходе можно настроить разные частоты работы видеокарты на каждом профиле, но в основном это фишка High-End видеокарт. Так же тут у нас аппаратная поддержка DirectX 9.0b и Shader Model 2.0a. А еще это одна из первых видеокарт GeForce в списке поддержки AERO Widnows Vista\7.

Оперативной памяти у видеокарты 128 Мегабайт, которая набрана 8 чипами по 16 мегабайт. Ширина шины 128 Бит. Эффективная частота памяти 400 МГц. Но зачастую используется 4 чипа по 32 мегабайта работающих на 64 битной шине.

Интерфейс у видеокарты AGP 8x.

Опять немного отступим от темы.

В скором времени я хочу провести эксперимент на одной из видеокарт. Есть видеокарта FX 5200 на 128 мегабайт 64 бит. Распаяно всего 4 из 8 микросхем памяти. В планах сначала сделать ее на 64 мегабайта 32 бита, а после, распаяв 8 микросхем памяти из обычной DDR планки, сделать на 256 мегабайт 128 бит. Но это я планирую делать в формате ролика.

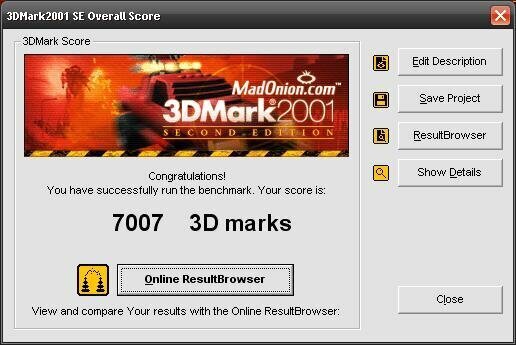

Что у нас по оценке производительности? Видеокарта была проверена тремя разными версиями 3DMark, это 2001, 2003 , 2005. Последний скорее был сделан для прикола. Напоминаю, что сердцем моей тестовой платформы является Intel Pentium D 935.

В 2001 марке мы выбиваем 7007 попугаев. Пока лидером остается Radeon 9100 со своими 8794 попугаями. Хочу заметить что основные частоты у них одинаковые, но аппаратная поддержка разная.

Впервые у нас появляется скрин из бенчмарка 3DMark 2003, в нем мы выбиваем 1560 попугаев. Этот тест как раз поддерживает DirectX 9 и пиксельные шейдеры.

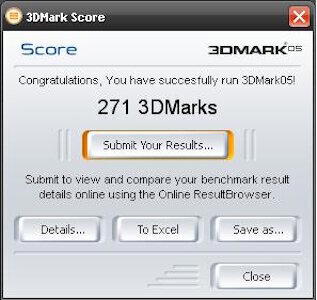

Тестирование в 3DMark 2005 было скорее приколом чем ошибкой. В нем мы выбиваем 271 попугай.

Ну и по традиции скриншот с AIDA64

Статья подошла к своему завершению. Но это еще не всё, обязательно с вами увидимся в скором времени.

Спасибо вам за внимание.

Если вам было интересно вы так же можете почитать другие статьи о видеокартах, подборка откроется по этой ссылке.

Под спойлером не является чем то обязательным.

Так же при желании вы можете поддержать мое творчество и отправить донаты по этой ссылке. Донаты принимаются от 2 рублей. Так же подключена монетизация и от самого Pikabu.

Категорически приветствую вас мои дорогие друзья.

После небольшого перерыва продолжаем с вами рассматривать старенькие AGP видеокарты. Сегодня у нас сразу две видеокарты одной модели, но с разным объемом памяти и от разных производителей.

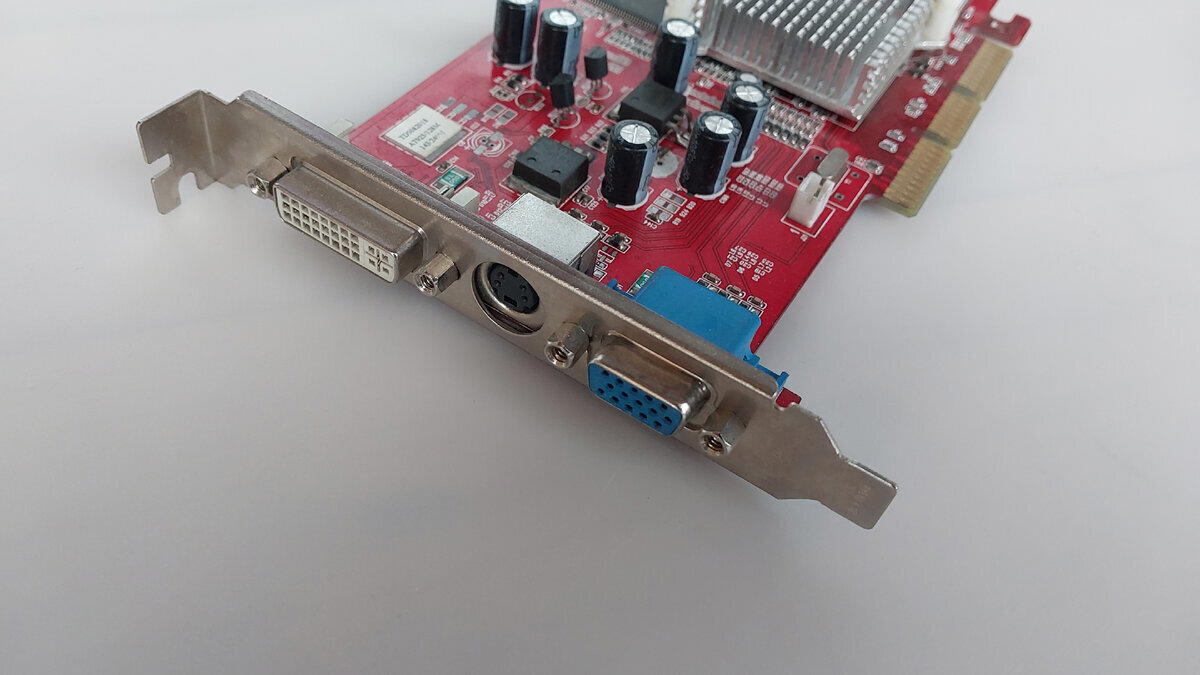

Видеокарты ATI Radeon 9250.

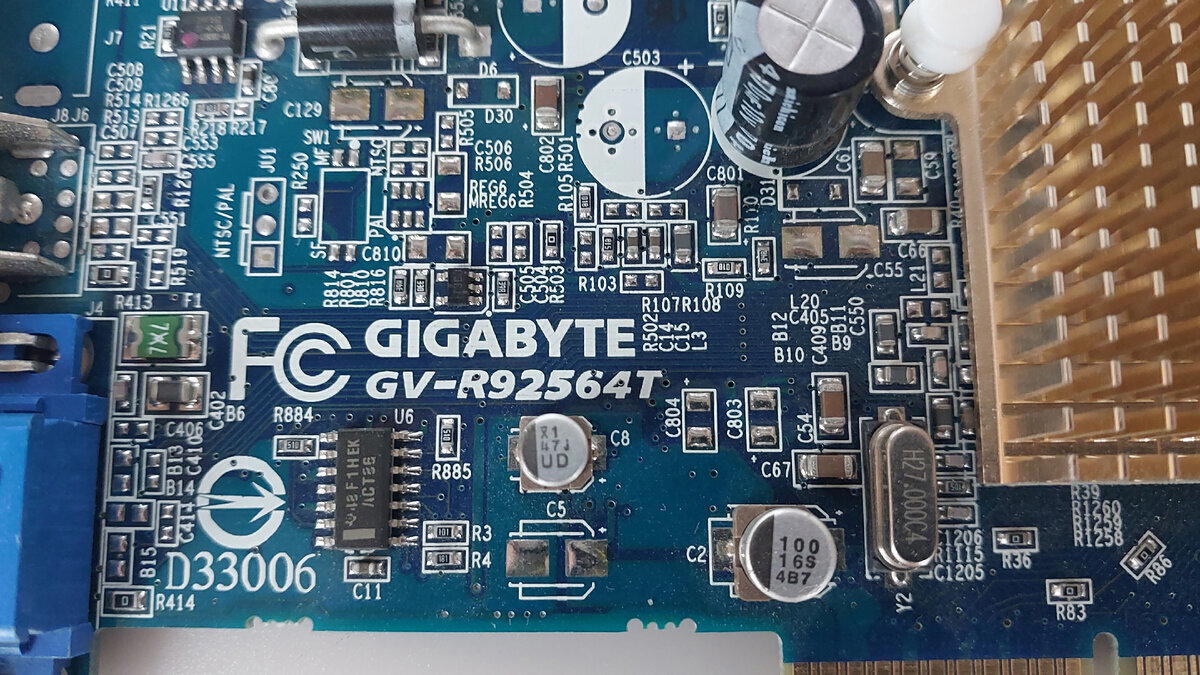

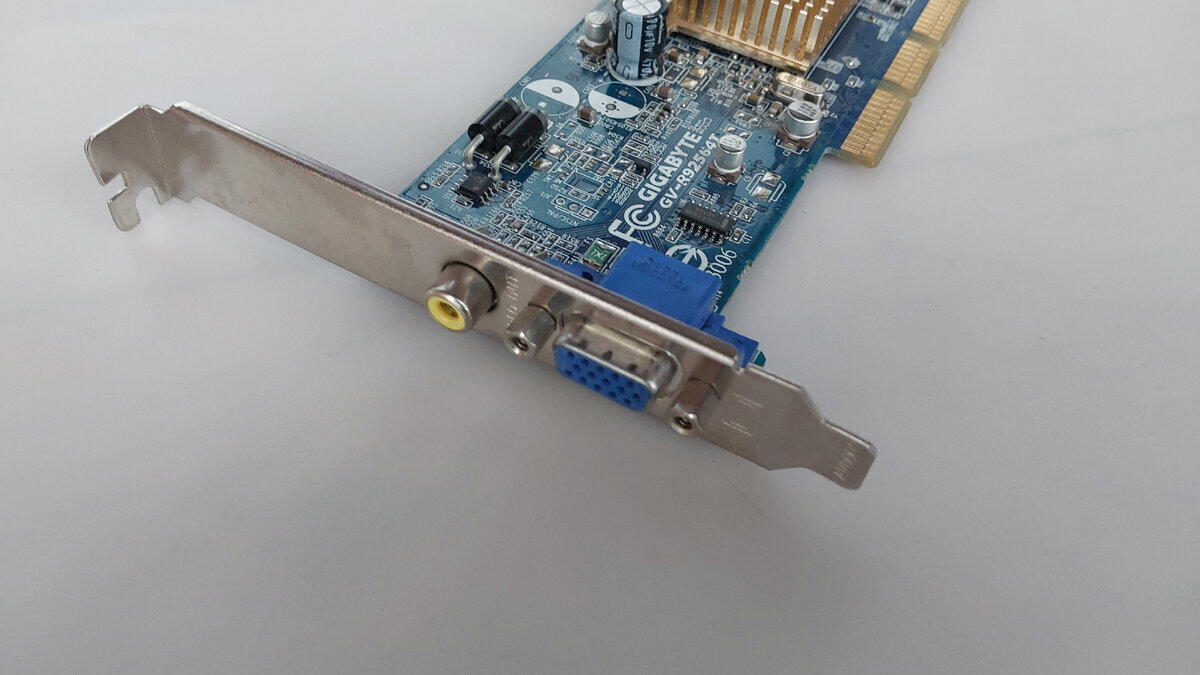

Итак, у нас в гостях ATI Radeon 9250, одна от производителя Gigabyte, со второй же не понятно, но очень похоже на Diamond.

Начнем рассматривать по порядку.

Gigabyte ATI Radeon 9250 64Mb. Лицевая сторона.

Diamond(возможно) ATI Radeon 9250 128Mb. Лицевая сторона.

Gigabyte ATI Radeon 9250 64Mb. Обратная сторона.

Diamond(возможно) ATI Radeon 9250 128Mb. Обратная сторона.

Компания ATI любила выпускать более медленные видеокарты с более высоким индексом. Если вы читали мои предыдущие статьи, то вы помните что ATI Radeon 9100 это перелицованная ATI Radeon 8500 с более низкими частотами, а Radeon 7500 являлась перелицованной Radeon VE, то я думаю, вы понимаете что данная серия карт тоже что-то перелицованное.

И на самом деле так и есть, Radeon 9250 это чуть замедленная версия Radeon 9200. Изменения в основном идут по частоте чипа, она была снижена на 10МГц, но не у всех вендоров это было соблюдено, и я вам даже приведу примеры.

Маркировка Giabyte ATI Radeon 9250 64Mb. Я думаю ее многие узнают.

Маркировка второй видеокарты.

Кстати как можно наблюдать на второй видеокарте с лицевой стороны написана модель карты, объем памяти, частота памяти и частота процессора, а на обратной стороне помимо модели и объема обозначен еще тип памяти и ширина шины, во как.

Несмотря на то что видеокарты одной серии они имеют отличие в видеоразъемах.

Видеокарта от Gigabyte имеет D-Sub(VGA) и RCA разъемы.

Видеокарта предположительно от Diamond имеет D-Sub(VGA), S-Video и DVI

Хотя помимо разъемов они еще отличаются и шириной шины, и объемом памяти, и высотой. Видеокарту от Gigabyte можно считать низкопрофильной.

Уйдем немного в личные воспоминания из моей юности. ATI Radeon 9250 от MSI было моим первым знакомством с «красными». Как я ее добыл, я уже не помню, но меня привлек большой объем памяти на тот момент, целых 256 мегабайт. Понимание тогда что объем памяти не равно быстродействию до меня дошло позднее. Я тогда очень долго не понимал, почему у меня не запускается S.T.A.L.K.E.R, когда у товарища он работал на карте с 128 мегабайтами, почему не работает тема оформления AERO на Windows Vista и многое другое. В итоге я плюнул на это дело и полностью перешел на новую платформу с PCI-E видеокартами, а данная же 9250 еще очень долго работала в компьютере, который был сделан для просмотра видео, ТВ-передач через ТВ-тюнер, просмотр DVD ну или всяких видео с флешек. Грубо говоря, домашняя медиаприставка подключенная к кинескопному телевизору. Был он собран в компактном корпусе, вкупе с Prescott 3GHz, внутри всегда было жарко, и спустя 7 лет видеокарта с пассивным охлаждением получила отвал.

Пора поговорить о технических характеристиках наших двух карточек. Начнем с Gigabyte. Я не смог снять радиатор охлаждения, поэтому полюбоваться на чип мы не сможем.

Чип оперативной памяти Mosel Vitelic объемом 16 мегабайт.

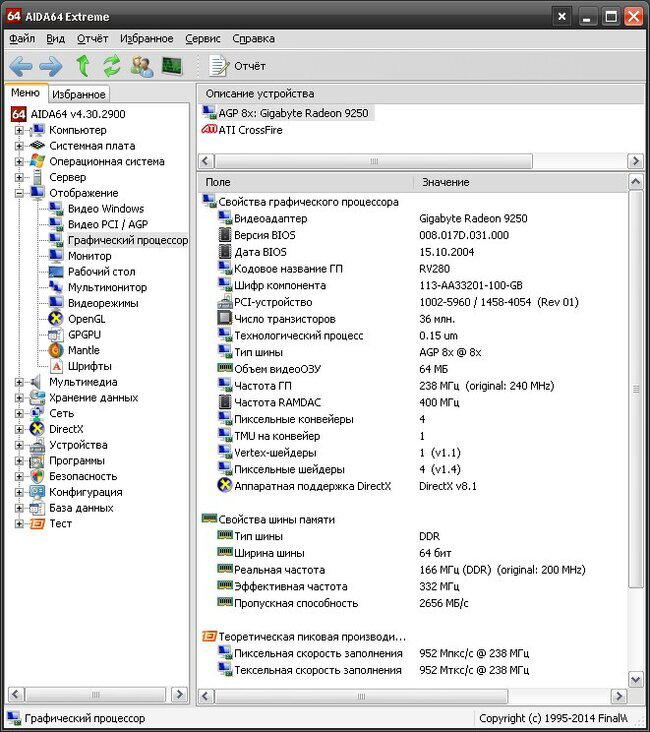

Сегодня скриншоты с AIDA64 будут не в конце статьи как обычно, а немного раньше.

Итак, Gigabyte Radeon 9250 имеет графический процессор RV280 и работает на частоте в 238МГц (вы же помните, что я говорил, что не все вендоры соблюдают частоту в 240МГц), объем памяти составляет 64 мегабайта, который набран из 4 микросхем типа DDR по 16 мегабайт с частотой 332МГц. Ширина шины памяти составляет 64 бита. Видеокарта работает на шине AGP 8x. Из графики у нас: 4 пиксельных шейдера, 1 вершинный шейдер и поддержка DirectX 8.1.

AIDA64

С такими характеристиками видеокарта от производителя Gigabyte в 3DMark 2001 выбивает 4442 попугая. Запомнили.

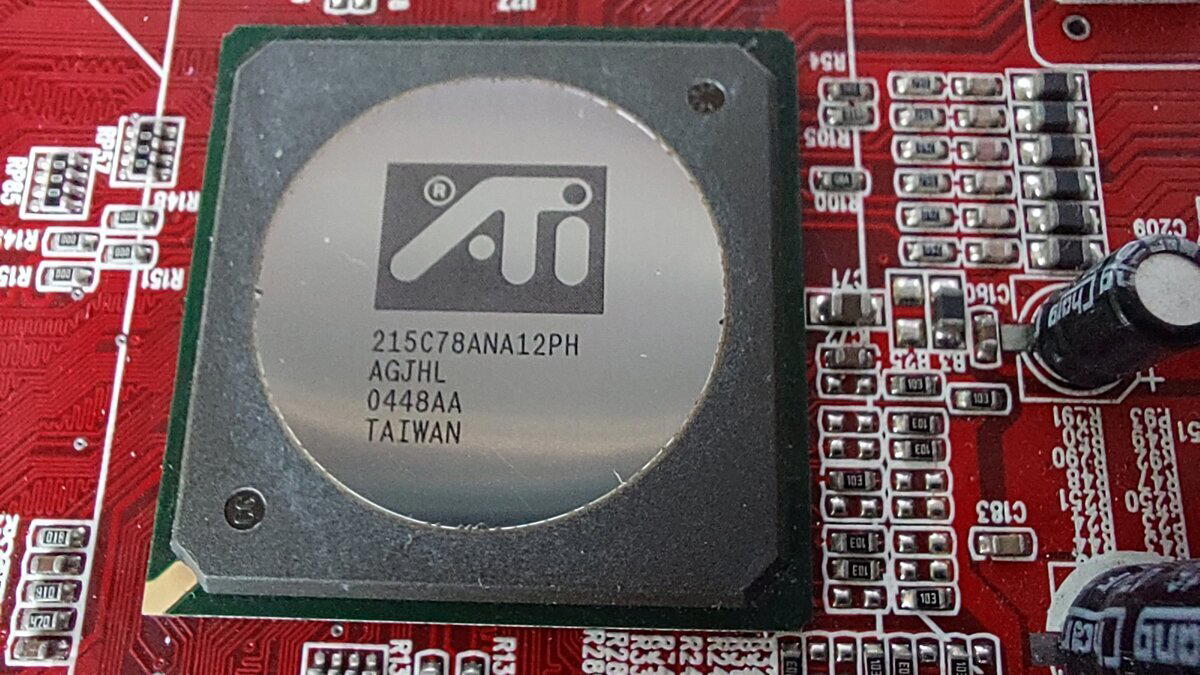

Теперь на сцену выходит видеокарта, которая подозрительно похожа на карту от Diamond. Вот тут радиатор я снял без проблем.

Графический процессор RV280.

А вы знали?

Видите этот код на графическом процессоре, который начинается на 215? По началу этого кода вы можете определить принадлежность чипа, но в основном это полезное умение нужно только для тех, кто меняет BGA чипы. Начало 215 означает, что перед вами графический чип, причем неважно для видеокарты настольного компьютера или видеочип для ноутбука, но и тут есть нюанс. AMD еще решила так маркировать чипсеты(северные мосты) со встроенной видеокартой (IGP). Начало 216 означает, что перед вами северный мост без встроенной графики и так же неважно для какого устройства. Начало 218 означает, что перед вами южный мост, но это уходит в прошлое(понятие южный мост).

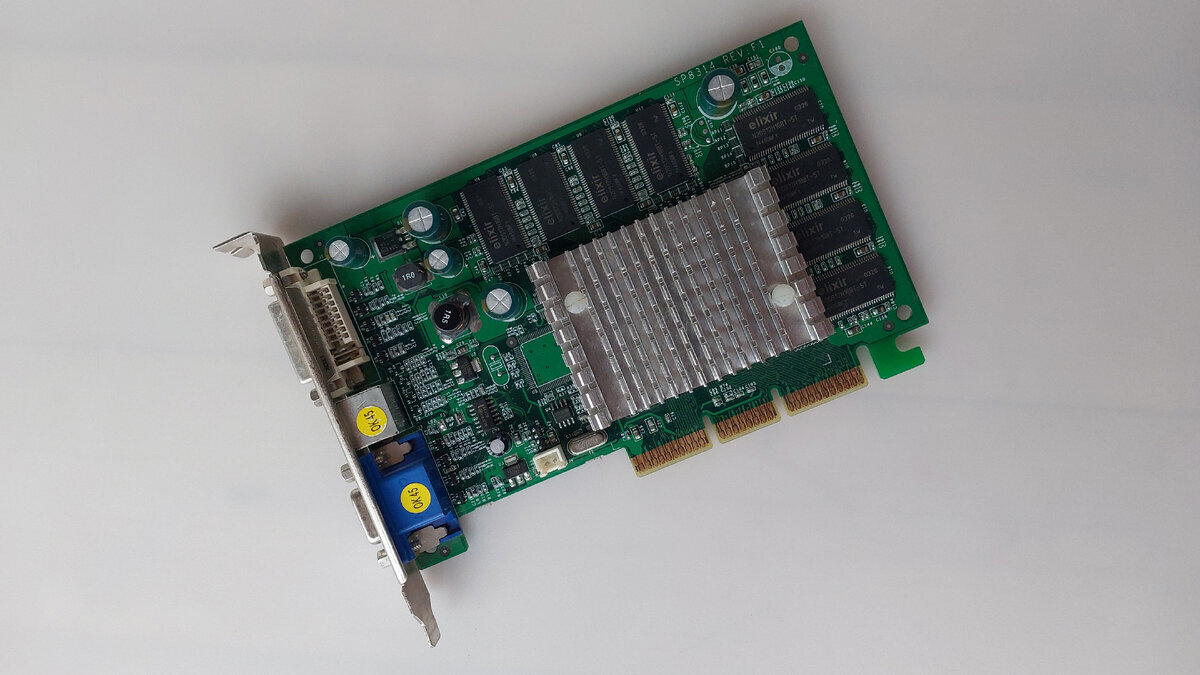

Чип оперативной памяти Elixir 16 мегабайт.

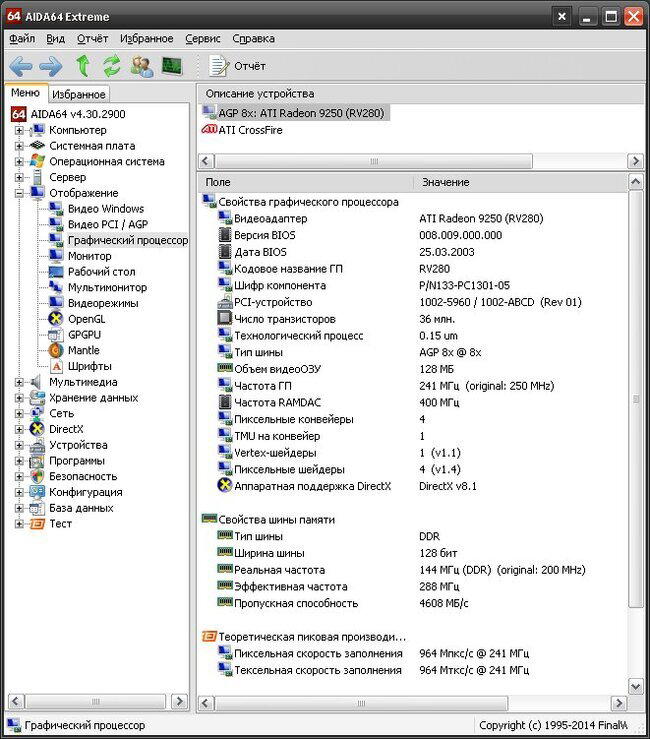

Чисто технически у нас тут то же самое, что и у Gigabyte, пробежимся лишь по отличительным моментам.

Частота графического чипа 241МГц, при этом AIDA радостно рапортует, что оригинальная частота 250МГц. Возможно, данная карта стала 9250 именно тупой перепрошивкой. Частота памяти 288МГц, которая, судя по AIDA, тоже занижена.

Вы наверное сейчас спросите «Ты же сказал что на наклейке с лицевой стороны написана частота памяти, а там указано 143МГц.»

Один момент друзья. Я указываю в статье эффективную частоту памяти, реальная же у нас 144МГц (подумаешь на 1МГц ошибочка).

Давайте я вам объясню, что к чему. Дело в том, что у нас используется память типа DDR (Double Data Rate) и в отличии от старой памяти SDRAM за один такт может передаваться вдвое больше данных. Так и появилось понятие реальной частоты на которой работает чип (планка) памяти и эффективная частота.

Вернемся к статье. Оперативная память у нас типа DDR набранная 8 чипами по 16 мегабайт, что в сумме составляет 128 мегабайт. Ширина шины при этом 128 бит. Больше разницы нет

AIDA64

Кстати интересный момент можно увидеть в "Дата BIOS". Radeon 9250 появился на свет в 2004 году, а BIOS 2003.

Эта же карта в 3DMark 2001 выбивает уже 5968 попугаев. Кстати, если мне не изменяет память, Radeon 9100 показывала результаты куда лучше.

Чисто технически разница между двумя видеокартами только в ширине шины, а как меняется оценка. Подозреваю, что частоты были снижены из-за пассивного охлаждения, примененного в этих двух карточках. Если поставить активное охлаждение, вернуть частоты на свои оригинальные значения, думаю, что вторая карта покажет результат ничуть не хуже чем Radeon 9100.

Статья подходит к своему логическому завершению, надеюсь вам было интересно.

Так же вы можете написать ваш опыт использования этих видеокарт в комментариях.

Всем спасибо и до новых встреч.

Привет привет друзья. Что мы все по AGP да по AGP, пора бы уже посмотреть что было «ДО».

К сожалению, мы не уйдем так далеко к видеокартам на шине ISA, а остановимся чуть ранее на шине PCI. Данные видеокарты не являлись 3D ускорителями, а создавались именно для 2D. Чтобы поиграть во что-то серьезное к ним часто приобретались 3D ускорители 3Dfx Voodoo.

Рад вам представить видеокарту S3 Trio32 на целых 2 Мегабайта.

Видеокарта S3 Trio32. Лицевая сторона

По сравнению с другими S3, что я держал в руках (кроме Virge) она достаточно длинная.

Видеокарта S3 Trio32. Обратная сторона

Что можно сказать о данной видеокарте. Данная карта была бюджетной версией и без того бюджетной S3 Trio64. Разница между видеокартами была только в ширине шины памяти, у нашей гостьи она составляет всего 32 бита.

Видеокарты часто поставлялись штатно с 1 мегабайтом памяти и двумя свободными кроватками для установки дополнительной памяти. В те времена дополнительная память продавалась почти в каждом компьютерном магазине.

К слову, увеличение оперативной памяти до 2 мегабайт ни как не влияло на производительность игр, память влияла только глубину цветов рабочего стола при определенных разрешениях экрана.

Внутри графического чипа уже в то время компания S3 реализовала графическое ядро, RAMDAC и тактовый генератор. Хотя если честно я не припомню не одной PCI видеокарты, где все 3 компонента были разбросаны по плате. В любом случае, в наше время видеокарта выглядит привычно.

Вендор видеокарты ExpertColor

Нашу сегодняшнюю карту выпустила компания ExpertColor, достаточно известная в свое время.

Графический процессор

S3 Trio32, как я уже ранее сказал, является бюджетным вариантом S3 Trio64. Графическое ядро работает на частоте 50 МГц, на той же частоте работает и оперативная память карты. Кстати карта поддерживает разные виды памяти (но не одновременно) это FPM RAM или EDO RAM. К сожалению, обмануть систему и поставить два чипа по 256 Килобайт или, наоборот, по 1 Мегабайту, чтобы получить карту на 1.5 Мегабайта или на 3 Мегабайт не получится.

Поставить два чипа по 256 килобайт вместо родной памяти я пытался лично не так давно на S3 Trio64V+, самое интересное, что карта включается, работает но увы, пишет что памяти стоит 1 мегабайт и при загрузке Windows можно видеть разные графические артефакты, говорящие о проблемах с памятью.

Небольшой лайфхак. Для данной видеокарты можно добыть чипы памяти из планки памяти SIMM на 2 мегабайта c 4 чипами памяти. Вся проблема в том, что зачастую в этих планках редко стоят чипы необходимого корпуса SOJ. Иногда такие чипы памяти встречаются в CD приводах Asus в качестве кеш памяти

Маркировка платы и чип памяти.

Родная память на видеокарте набрана 8 чипами Toshiba типа EDO RAM по 128 килобайт каждая. Вы наверное спросите как же так, на чипе явно видна цифра 256. Если мы посмотрим в официальный Datasheet мы увидим следующие.

The TC514256AP/AJ/AZ is the new generation dynamic RAM organized 262,144 words by 4 bits.

Если перевести буквально в чипах памяти 262144 (256) строк по 4 бита. Если умножить 256 на 4 мы получим 1024 килобита что равняется 128 килобайтам.

Мне же карта попалась с двумя поврежденными кроватками под дополнительную память. Спустя какое-то время и просто решил впаять два чипа капитально и навсегда, так как нормальных живых кроваток я у себя не нашел.

D-Sub (VGA) видеовыход

Видеокарта снабжена одним единственным VGA выходом для подключения к монитору. Кстати вам не чего не мешает использовать в одном компьютере сразу две S3 для вывода изображения на разные мониторы (причем карты могут использоваться разные. В моем Intel Pentium 133 стоят одновременно S3 Trio32 и S3 Trio64 с разным объёмом памяти, и без проблем система с ними работает в режиме расширения экрана)

Из неприятных моментов это кривой RAMDAC. Несмотря на увеличение памяти я не смог добиться комфортной работы в расширении 1024х768 с любой цветовой палитрой, монитор просто показывает что режим не поддерживается. Видимо чистота обновления слишком низкая, либо заоблачная. Надо будет заиметь в мастерскую CRT монитор. На S3 Trio64 такого нет. Зато 800х600 стало в 32 бита и серфить OLD-DOS стало приятнее.